数据中心灾备-信息系统灾难恢复规范(国标)

作者 陈怀临 | 2013-08-20 10:39 | 类型 数据中心 | 2条用户评论 »

数据中心灾备指南-10 things your data center backup solution should do

作者 陈怀临 | 2013-08-19 16:57 | 类型 云计算, 数据中心 | 1条用户评论 »

OpenStack的未来取决于是否拥抱Amazon!

作者 陈怀临 | 2013-08-19 11:11 | 类型 云计算, 数据中心, 研发动态, 行业动感 | Comments Off

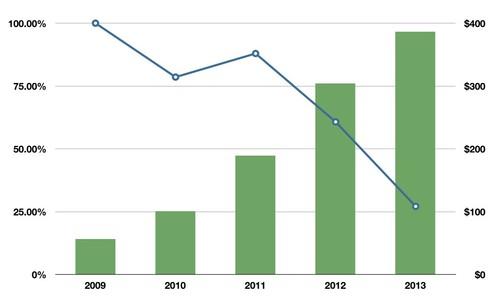

OpenStack的未来取决于是否拥抱Amazon!—— 一封致OpenStack社区的公开信 本文由:·@ben_杜玉杰 翻译,转载请注明本文链接!http://duyujie.org/post/56367280481/openstack-amazon-openstack 原文链接:http://www.cloudscaling.com/blog/cloud-computing/openstack-aws/ 亲爱的Stackers, 在过去的三年里,OpenStack社区弥漫着武断和不公平的定位,尤其是对于AWS和VMware。这种观点最现实的表达就是OpenStack应该建立和维护一套他自己的差异化的API。 我毫不掩饰自己的信念,那就是这一选择将伤害OpenStack,或许已经存在伤害。现在,这个问题变得更加严峻,我希望能够说服你支持我的主张,那就是OpenStack应该立即拥抱既定的公有云的API和特性。这对于该项目的成功至关重要。更重要的是这样做才是真正符合OpenStack的使命。 为了说服你,我首先会解释一下为什么会有一个差异化的API集合的这段历史,然后,我们再看看为什么AWS和GCE支配公有云是不可避免的。我会揭穿围绕着有关抄袭这个公有云API的所有谎言,最后,我们将直击云计算中“创新曲线”的胡言乱语。 我们为何沦落到如此地步 当OpenStack在2010年夏天发布的时候在它最初的两个模块中并没有“native”API。Nova最初只提供EC2 API。该部分是由NASA贡献的,侧重于重新打造一个兼容EC2的私有云系统。Rackspace API是在EC2 API之后添加进来的,也就是在2010年那个夏天,OpenStack项目发布不久之前[1]。 引用自NOVA项目[README]: You have come across a cloud computing fabric controller. It has identified itself as “Nova.” It is apparent that it maintains compatibility with the popular Amazon EC2 and S3 APIs. 请注意,在NOVA项目中没有任何描述提及过“原生的API”以及对目前的NOVA[README]的比较。 该项目的另一半Swift,使用它自己原生的API,其中一部分,也就是最初的Swift代码是来自于RackSpace的Cloud Files服务。 简单来说,OpenStack最初的“原生的”API,其中一半是AWS兼容的(NOVA),另一半是RackSpace公有云兼容的(Swift)。 然后,RackSpace并购了ANSO Labs ,从而实际上“拥有了”OpenStack代码另一半的贡献着。更重要的是,大多数能够决定该项目技术方向的项目团队负责人(PTLs) 都成为了RackSpace的员工。 在并购ANSO Labs的这段时间里,RackSpace的API才被更改为“nova-api”,这就是现在所谓的Nova的“native API”[2]。 该API在很大程度上与RackSpace Cloud Servers公有云服务的API是一致的。至今这个API变动不大,并且深深的影响了这个项目的命名法则(例如,“floating IPs”与“elastic IPs”) ,并在某种程度上影响了Nova的方向。 根本没有什么所谓的“native”API。事实上,把RackSpace Cloud Servers API称为“native API”是在宣扬一个概念,有一个OpenStack Nova API是独立于Amazon API的。现在很明显,事实上最初的OpenStack native API就是它的AWS EC2 API。 我们来控制OpenStack 自2010年上述决定做出以来,OpenStack项目的管理已日趋成熟。OpenStack基金会,一个独立的组织,目前主导着OpenStack的战略和商务方向,而其开发团队的技术精英在主导该项目的发展方向。 简而言之,社区控制着该项目的方向,并且是时候主张按照符合我们的最佳利益的策略来兼容公有云了,而不仅仅是由一个单一的,虽然是主要的贡献者来主导了。如果不能改变这个策略,最终很有可能会导致这个项目变得无足轻重而死去。 亚马逊主宰公有云 很明显AWS(也有可能是GCE)将完全主导公有云的竞争。但更重要的是,who cares?AWS和GCE主导并不意味着OpenStack失败。事实上,OpenStack很明显正走向“赢得”私有云的竞赛的道路上,并且快速拥抱Amazon将使得OpenStack处于主导混合云的关键位置。 在2011年二月的Cloud Connect大会上,我做过一个主题演讲,勾勒了“两个云的故事蓝图”,用数字比较了AWS和RackSpace Cloud Servers的规模和增长。在那个时候,我相信是RackSpace的年增长率给他们打了一剂强心针,使得在公有云的市场上他们被放在了AWS的死对头的位置(当时AWS年增长率是100%而RackSpace是90%)。 但在这之后的两年半的时间里,变化太大了。AWS的增长率有增无减,GCE正式加入竞赛。与此同行,RackSpace面临着增幅下滑。如果RackSpace今年Q2-Q4的盈利等同Q1,他们公有云将从最高90%的年增长率下滑到30%,在过去几年中出现惊人的跌幅。请参阅下图,假设2013年季度财季增长保持不变。

虽然没有关于GCE的增长率的公开信息,但我相信它与AWS是持平的。客户对他们的公有云服务的兴趣是如此之高,以至于他们等待列表中的客户数量已经大于实际上大多数生产环境中的公有云客户名单数量。而他们还仍然处于内测阶段。 是什么导致RackSpace公有云的突然下滑? 从公布的信息来看, AWS,很可能是GCE正在领跑公有云服务,并且给OpenStack社区一个显而易见的选择。[3] | |

数据中心《腾云》读后感

作者 陈怀临 | 2013-08-12 09:12 | 类型 数据中心, 行业动感 | 8条用户评论 »

|

[原文地址可参阅:http://blog.csdn.net/neterpaole/article/details/8826829 ] 1 TRILL/FabricPath/SPB 首先肯定是传统二层网络有哪些困境或者不给力的地方喽:1 STP阻塞掉一半链路,浪费带宽;2 接入交换机MAC地址表空间会过大;3 为了二层互联而设置的三层网管限制了虚拟机的漂移。 关于MAC地址表详细说明一下: 因为传统的二层交换机是通过学习来建立MAC地址表的。怎么学习呢,接入交换机会利用所有接收到的数据桢的源MAC地址来建立MAC表。由于传统二层MAC地址没有层次化概念,那么所有接收到的数据桢的源地址都会被放入MAC表中,导致一台交换机可能会学习到整个网段内的所有二层地址,即便大部分时间只跟其中一小部分人联系。 但是大二层技术则可以减小MAC地址表空间,比如FabricPath采用的就是“基于会话的MAC地址学习”,即只有那些目的地址为本地设备的数据帧的源地址才会被放入FabricPath/TRILL网关的MAC地址表中,其他数据帧的源地址以及广播帧的源地址都不会被学习。

既然二层网络的主要问题就是缺失了控制平面,只做根据MAC地址查表转发的工作,那么TRILL/FabricPath/SPB的主要功能就是在传统二层网络的基础上引入了控制平面,下面单独详述: 1) FabricPath:新增二层帧头,主要包括三个字段:源SwitchID,目的SwitchID,TTL。其中源/目的SwitchID分别两个字节,用于在节点间寻址;TTL主要用于防环。 2) TRILL:新增TRILL头和MAC头,其中TRILL头也是源RBridgeID,目的RBridgeID和TTL,这与FabricPath基本上完全一致。MAC头主要是方便与现有以太网兼容并存。本质上讲,TRILL与当前IP报文转发过程是完全类似的。 3) SPB:与前两者类似,同样采用IS-IS构建独立的控制平面,新增的二层帧头主要由三部分组成:源MAC,目的MAC和S-VID。其中源/目的MAC与TRILL、FabricPath中的出入网关完全类似,指代了这个大二层网络的起点和终点,只不过在SPB网络中的逐跳转发由类似于隧道标识的S-VID实现。这也正是SPB使用PBB(一种MAC-in-MAC技术)的核心思想所在。

2 虚拟接入与虚拟交换机 2.1 首先是为什么需要虚拟交换机,主要两个原因:1) 服务器虚拟化让一个物理服务器上存在多个虚拟机,那多个虚拟机收发数据都从这个物理服务器的网卡上出入,导致单个操作系统与接入交换机端口间是多对一的关系,原来针对单个端口的策略无法部署;2) 服务器管理和网络管理责权不清,互相推诿。 一句话概括就是目前虚拟机同交换机端口之间没有办法直接对应上。 2.2 那为什么仅用简单的虚拟机交换机vSwtich技术又不够呢? vSwtich技术其实由来已久了,包括软件VEB,如VMware vShpere内置的vSwitch,VMware分布式统一网络接入平台VDS(Virtual Distributed Switch),与vSphere结合的Cisco Nexus 1000v,开源的Open vSwtich以及硬件的VEB(Virtual Ethernet Bridging)。 但是这些vSwitch也叫VEB存在三个问题: 1) 功能弱。具体说,通常只具有简单的二层转发,缺乏QoS机制和二层安全策略,流量镜像能力差。 2) 功能弱也导致网管人员难以把针对物理端口的策略平滑地迁移到VEB或者vSwtich上来; 3) 由于其管理范围被限制在物理服务器内部,没法在整个数据中心提供针对虚拟机的端到端服务。 因此,就得搞像VN-Tag或者VEPA这种复杂的专门针对DCN的虚拟交换机。 2.3 Cisco VN-Tag 核心思想:VN-Tag的核心思想就是在现有的以太网数据桢的VLAN标识前面增加一个专用标记字段VN-Tag,这个VN-Tag主要是dvif_id和svif_id一对地址,分别对应于源和目的虚拟机的虚拟网络接口VIF,因此支持VN-Tag的上联交换机就能够区分不同的VIF,识别来自和去往特定虚拟机的流量了,这样就把对虚拟机的网络管理范围从服务器内部转移到上联网络交换机上了。 换句话说,VN-Tag是如何解决2.1中所说的虚拟机无法与交换机端口对应的问题的呢?这样:虽然服务器和上联接入交换机只有一条物理连接,但是交换机可以通过VN-Tag区分不同虚拟机的流量,然后在交换机上生成对应 关键特性: (1) Port Extender。根据上面的原理,由于虚拟化软件Hypervisor和服务器网卡不再具备寻址功能,而是变成一个单纯的网络桥接通道,因此被VN-Tag称为Port Extender。Port Extender最主要的功能就是加上和去掉VN-Tag标签 (2) 级联。正是由于前面Port Extender的特点,VN-Tag具有级联的特性。即对应的处理交换机controlling switch可以不是与服务器直连的接入交换机,而可以是网络中任意IP可达设备,这样级联的好处是可以把流量拉到高端汇聚甚至核心设备上去进行更加精细、高速的管理 (3) 迁移。由于VN-Tag与虚拟机VIF形成了固定的对应关系,因此不管虚拟机迁移到哪台服务器上去,原来部署在VIF端口上的策略都可以保持不变。 标准化与产业化: (1) 目前已从IEEE 802.1Qbh改为了IEEE 802.1Br(Bridge Port Extension) (2) 产品方面,服务器需要Cisco Palo卡或者更高级的Cisco VIC 1280卡,交换机要能识别VN-Tag。 2.4 HP VEPA 核心思想也是将虚拟机间的交换行为从服务器内部转移到上联交换机。 关键特性: (1) 发卡弯。其本质是对STP生成树协议的修改,对应的场景就是同一个服务器上不同虚拟机间通信的情形,通过强制反射Reflective Relay实现对传统STP的修改。这也叫做标准版的VEPA,对数据帧没有任何改动。 (2) Q-in-Q。这是增强版的VEPA,其本质是使用VLAN堆叠的Q-in-Q技术(802.1ad),即在传统以太网数据桢VLAN标签之外再加上一个标签,来标识不同虚拟机或者虚拟机组的流量。这个外层标签叫做S-Tag或者S-Channel或者形象地称为通道。在标准版VEPA中,上联交换机只能通过IP或者MAC地址区分不同虚拟机数据,而MAC和IP地址容易被作假和攻击,那么增强版VEPA就用另外一个标签S-Tag来实现更精细的流量管理和隔离。 标准与产业化 标准化石IEEE 802.1Qbg。 产品方面,虽然包括了除cisco和vmware之外的几乎所有厂商,但是目前仍缺少实际产品和案例的支撑,并且增强版VEPA仍然需要更换现有的交换机,因为Q-in-Q功能并不常见,当然也需要服务器网卡的支持。

3 虚拟网卡 虚拟网卡本质上就是前面提到的“虚拟接入”的具体执行中必不可少的一个环节。虽然广义上讲是SR-IOV技术(Single Root I/O Virtulization),具体上你可以理解成为Cisco Palo卡以及后续的VIC1280卡即可。虚拟网卡本质上讲完成两个重要工作: 1 将一个物理以太网卡对虚拟机虚拟化为多个独立的PCIe设备,即在一个PF物理通道上虚拟出多个轻量级的VF虚拟通道,每个对应一个虚拟机,将网络接入直接延伸到虚拟机层面。 2 为了支持前面的虚拟接入,在虚拟网卡上打上VN-Tag标签后再送往上联交换机,最终实现区分不虚拟机的流量,并可以在整个数据中心内部署针对性的隔离和Qos策略。 | |

思科数据中心DFA体系结构

作者 陈怀临 | 2013-08-11 18:16 | 类型 TechTalk, 云计算, 数据中心, 通讯产品 | Comments Off

现代数据中心:多路径二层网的FabricPath简介

作者 陈怀临 | 2013-07-30 16:14 | 类型 云计算, 数据中心 | 1条用户评论 »

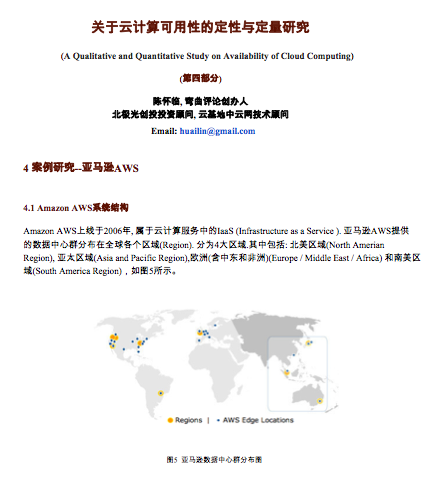

关于云计算可用性的定性与定量研究(六)

作者 陈怀临 | 2013-07-23 03:18 | 类型 云计算, 数据中心 | Comments Off

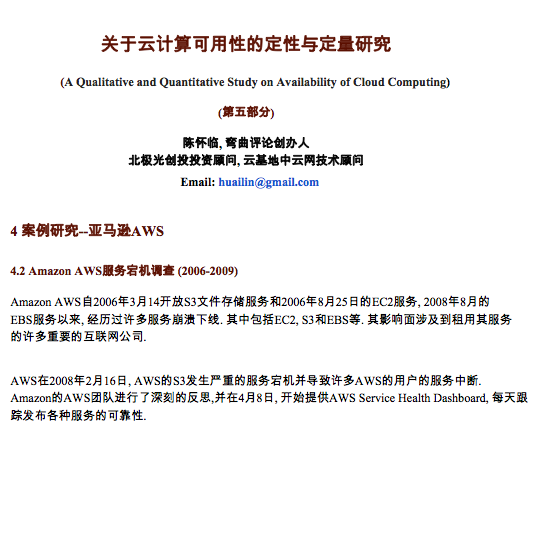

关于云计算可用性的定性与定量研究(五)

作者 陈怀临 | 2013-07-17 10:59 | 类型 云计算, 数据中心 | 1条用户评论 »

《云计算中的持久化与安全性》

作者 陈怀临 | 2013-07-13 12:46 | 类型 云计算, 数据中心 | Comments Off

|

原文看参阅:http://wangxu.me/blog/p/735 前几天,亚马逊的云服务(AWS)连续发生大规模服务中断,使得默默无闻的EBS(弹性块存储)服务再次被推上风口浪尖。实际上,过去一两年间,差不多所有AWS服务大规模中断,都可以听到EBS的叹息,难怪新浪的程辉兄说:“EBS仍然是公有云最大的难点和故障点”。 作为国内为数不多的,也大概是最早提供商用EBS服务的团队成员,我当即跳出来为EBS说了几句“公道话”,之后的图灵生日会上,和刘江老师聊天的过程中,他建议我把这些想法写出来,也让用户和相关产业了解,一个EBS服务的设计者是怎么看待自己这个“故障点”的。 首先说说我的总体观点,EBS是最后一道防线,所以重大故障才往往在EBS身上体现出来。只要存储不出问题,再大的问题也不容易造成长时间、大范围的停机,不论是网络还是计算,都是无状态的,有电、有链路就可以工作,而这些也是最容易通过冗余来保障可用性的;但存储则不同,对存储来说,数据正确是我们第一要保障的,如果真发生严重故障,我们不可以为用户迫切要求的可用性而冒险牺牲正确性。 系统设计的哲学:熔断器与冗余没有系统能避免异常情况的出现,大系统的设计中,最复杂、最难处理的地方往往是不常遇到的意外(超负荷)情况,在这里经常用到的两种策略是熔断器和冗余——

这两种策略几乎总是同时用到的——对普通的困难,我们争取用设计上的冗余来克服,让它对用户透明。但是,当系统无法承受的时候,就需要果断地中断服务。什么情况下中断服务,总是设计者最为头痛的地方,他们不愿意向用户暴露自己脆弱的一面,但也不能背弃对用户的承诺——如果你无法保证数据的持久写入,就不能欺骗用户说数据你已经存储好了。 而没有程序是没有Bug的,这些最极端的情况,往往是设计实现者自己也最难以枚举的,他们的测试很难涵盖到类似的情况,于是,对于包容性比较好的存储系统设计,在这样的困境下,尽力保持现场地退出服务,让独立的运维程序,甚至是人工来介入,恢复服务状态是一种负责任的态度。对于亚马逊的EBS故障情况,我个人基本是这么理解的。 那么好了,我想,一定有人要问一个问题,既然EBS可能会造成这样的窘境,为什么一定需要这么一个服务呢。 让人又爱又恨的EBS服务如果你想成为最好的云服务商,请做EBS服务,这是杀手服务;如果你想成为被人唾骂的云服务商,请做EBS服务,这是你的最大故障点。(改自《北京人在纽约》的经典台词) 亚马逊大多数的AMI(操作系统镜像)都放在EBS上,亚马逊很多虚拟机都用到了EBS服务,很多数据库都放在EBS磁盘上……亚马逊的EBS需要额外付费,亚马逊的EBS的性能并不稳定,甚至可以说亚马逊的EBS性能公认的不好……这一系列的事实同样是这么矛盾,一遍又一遍地问:为什么人们要用EBS服务呢?

概括地说,EBS提供了持久化的、具有独立于主机的生命周期的、高可用的块存储设备,在这一设备上可以创建支持POSIX语义的本地文件系统(或是Windows本地文件系统)。这些独一无二的特征,让用户们在口诛笔伐这个服务的同时,也离不开这个服务。 | |

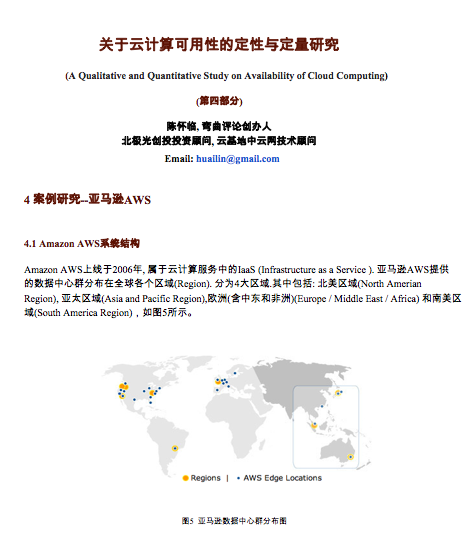

关于云计算可用性的定性与定量研究(四)

作者 陈怀临 | 2013-07-03 09:01 | 类型 云计算, 数据中心 | Comments Off

(2个打分, 平均:4.50 / 5)

(2个打分, 平均:4.50 / 5)