机器学习应用–深度学习“看风水”?

作者 AbelJiang | 2014-12-01 13:53 | 类型 Deep Learning, 机器学习 | Comments Off

|

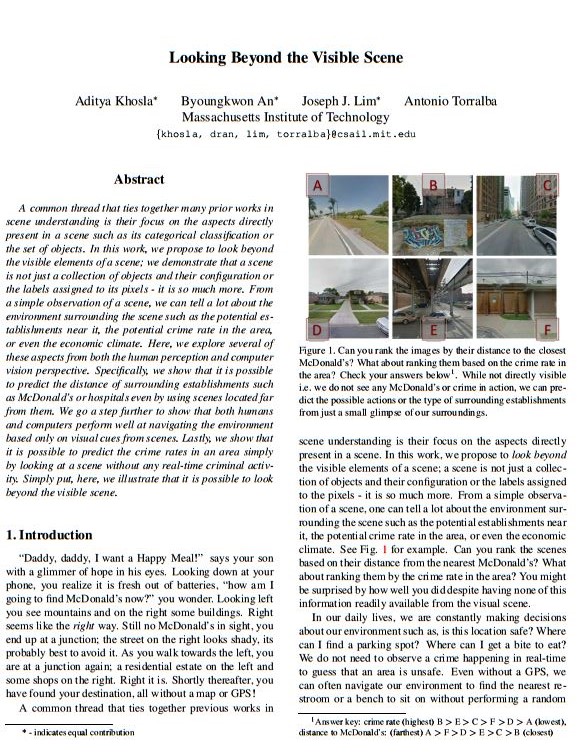

人类有种很奇妙的能力,通过建筑周边的景象,能大致推断某个地方是否安全,哪里可能有停车的地方,哪里可能有加油站。 这种决策不仅仅要求你看到某个景象,还需要一系列复杂的对于景象的理解和实时判断。那么问题来了–计算机能干这活么?如果能,计算机“看风水”有没有人看的准呢? MIT的CSAIL给出的答案是yes and sometimes。研究人员提出的算法能够观察一组图片并给出比人更为准确的判断。这些判断包括诸如某个地方犯罪率是不是高一些,某个地方是不是离麦当劳近一些此类的问题。 为了开发这个算法,研究团队用了来自八个美国主要城市的,嵌入GPS数据(包括犯罪率和麦当劳位置)的八百多张Google images来训练计算机。计算机利用深度学习技术自主整合图片包含的各种信息,包括你经常注意到的麦当劳周围的景物以及你不经常发现的一些景物信息。 研究人员已经将论文发表在了今年的CVPR会议上。研究者称,这项研究用途很广,比如将其用于导航软件规避高犯罪区域,或是帮助麦当劳确定其开设连锁店位置。 Reference: | |

深度学习的昨天、今天和明天

作者 AbelJiang | 2014-11-11 22:26 | 类型 Deep Learning, 机器学习 | Comments Off

往事如烟--《扒1扒神经网络的神经大神们》

作者 陈怀临 | 2014-10-06 10:42 | 类型 Deep Learning, 机器学习 | Comments Off

|

作者:Nick Zhang 。

自图灵提出“机器与智能”,一直就有两派观点,一派认为实现人工智能必须用逻辑和符号系统,这一派看问题是自顶向下的;还有一派认为通过仿造大脑可以达到人工智能,这一派是自底向上的,他们认定如果能造一台机器,模拟大脑中的神经网络,这台机器就有智能了。前一派,我想用“想啥来啥”来形容;后一派就称之为“吃啥补啥”,估计他们的思想来源于中国古代的原始思维,套一句庸俗的哲学词,前者偏唯心,后者偏唯物。这两派一直是人工智能领域里两个阶级、两条路线的斗争,这斗争有时还你死我活。

1949年,神经心理学家Hebb出版《行为组织学》(Organization of Behavior),在该书中,Hebb提出了被后人称为“Hebb规则”的学习机制。这个规则认为如果两个细胞总是同时激活的话,它们之间就有某种关联,同时激活的概率越高,关联度也越高。换句话说,就是“吃啥补啥”。2000年诺贝尔医学奖得主肯德尔(Eric Kandel)的动物实验也证实了Hebb规则。后来的各种无监督机器学习算法或多或少都是Hebb规则的变种。

明斯基是人工智能的奠基人之一,是达特茅斯会议的组织者。明斯基在一次会议上和罗森布拉特大吵,他认为神经网络不能解决人工智能的问题。随后,明斯基和麻省理工学院的另一位教授佩普特合作,企图从理论上证明他们的观点。他们合作的成果就是那本影响巨大、“是也非也”的书:《感知机:计算几何学》(Perceptrons: An Introduction to Computational Geometry)。在书中,明斯基和佩普特证明单层神经网络不能解决XOR(异或)问题。异或是一个基本逻辑问题,如果这个问题都解决不了,那神经网络的计算能力实在有限。其实罗森布拉特也已猜到“感知机”可能存在限制,特别是在“符号处理”方面,并以他神经心理学家的经验指出,某些大脑受到伤害的人也不能处理符号。但“感知机”的缺陷被明斯基以一种敌意的方式呈现,当时对罗森布拉特是致命打击。所有原来的政府资助机构也逐渐停止对神经网络的研究。1971年,罗森布拉特四十三岁生日那天,在划船时淹死。很多人认为他是自杀。王国维沉湖时遗言“经此世变,义无再辱”,在罗森布拉特,我猜“辱”是明斯基的书,“世变”是随后“神经网络”学科的消沉。不同的是,王静安谓之“世变”是历史潮流,但神经网络学科十年后会逆袭。 表面是科学,但有证据表明明斯基和罗森布拉特以前就有瓜葛。他们是中学同学。布朗克斯(Bronx)科学高中大概是全世界最好的高中,毕业生里出过八个诺贝尔奖、六个普利策奖。远的不说,明斯基是1944年毕业生,乔姆斯基是1945年毕业生,而罗森布拉特是1946年毕业生。美国高中学制四年,明斯基和罗森布拉特至少有两年重叠,而且彼此认识,互相嫉妒。1956年的达特茅斯会议定义了“人工智能”这个词,会议的组织者包括明斯基、麦卡锡和香农等,参会者还有司马贺,纽威尔等。这个会议在定义“人工智能”领域时只是提到了神经网络。那时明斯基是神经网络的支持者。他1954年在普林斯顿的博士论文题目是“神经-模拟强化系统的理论,及其在大脑模型问题上的应用”(Theory of Neural-Analog Reinforcement Systems and its Application to the Brain-Model Problem),实际是一篇关于神经网络的论文。他晚年接受采访时开玩笑说,那篇三百多页的博士论文从来没正式发表过,大概只印了三本,他自己也记不清内容了。貌似他想极力开脱自己和神经网络学科的千丝万缕的关系。达特茅斯会议的主题并不是神经网络,而是后来被纽维尔和司马贺称为“物理符号系统”的东西,也就是说达特茅斯会议,“想啥来啥”派是主要基调。 罗森布拉特被比他大一岁的明斯基妒忌是自然的。工作上,明斯基所负责的麻省理工学院的人工智能实验室也在向国防部和海军申请经费。大多数的圈内科学家,对罗森布拉特突然被塑造的明星范儿很反感。明斯基早期也是“吃啥补啥”派出身,但此时已经改为“想啥来啥”派了。由于他和佩普特对感知机的批判,俩人后来被“吃啥补啥”派称为“魔鬼搭档”。其实明斯基认识佩普特结识还是通过麦卡洛克的介绍,历史真是纠结。被称“魔鬼”是因为《感知机》第一版有言:“罗森布拉特的论文大多没有科学价值。”这话跳步确实有点大,但罗森布拉特人缘不好,没有得到同行的支持。 比罗森布拉特小一岁的维德罗(Widrow)是斯坦福大学教授,在罗森布拉特刚提出“感知机”时,就提出了Adaline可适应性算法。Adaline和感知机很相似,也是机器学习的鼻祖模型之一。罗森布拉特享受盛誉时,维德罗也沾了光,但在罗森布拉特死后,他却并没有被非难。维德罗在几十年后回忆说,那是因为他后来主要在电机系(EE)做集成电路的工作,而不是在计算机系里从事派系繁杂的人工智能研究,圈子不同,老死不相往来。

在信息科学和神经科学的结合部的失败,并没有影响到神经生物学内部。哈佛神经生物学家胡贝尔(Hubel)和威瑟尔(Wiesel)对视网膜和视皮层(visual cortex)中神经细胞的信息处理模式做了深入研究,他们为此获得1981年的诺贝尔医学奖。随后,麻省理工学院英年早逝的大卫·马尔(Marr)为视觉信息处理建立数学模型,影响了后来连接主义的运动。威瑟尔后来离开哈佛去了洛克菲勒大学。1991年洛克菲勒大学时任校长大卫·巴尔的摩出了学术丑闻被迫辞职后,威瑟尔出任洛克菲勒校长,为把那所学校建成生物学的重镇做出贡献。 1974年,哈佛的一篇博士论文证明了在神经网络多加一层,并且利用“后向传播”(Back-propagation)学习方法,可以解决XOR问题。这篇论文的作者是沃波斯(Werbos),他后来得到了IEEE神经网络学会的先驱奖。沃波斯这篇文章刚发表时并没引起多少重视,那时正是神经网络研究的低谷,文章不合时宜。 神经网络在1980年代的复兴归功于物理学家霍普菲尔德(Hopfield)。1982年,那时在加州理工担任生物物理教授的霍普菲尔德,提出了一种新的神经网络,可以解决一大类模式识别问题,还可以给出一类组合优化问题的近似解。这种神经网络模型后被称为霍普菲尔德网络。1984年,霍普菲尔德用模拟集成电路实现了自己提出的模型。霍老也培养了一批后起之秀,包括现在在生物学重镇Salk研究所担任计算神经生物学实验室主任的Terry Sejnowski。霍老后转往普林斯顿担任分子生物学教授,现已退休。霍普菲尔德模型的提出振奋了神经网络领域。一帮早期神经网络研究的幸存者,在生物学家克里克(Crick,对,就是发明DNA双螺旋的那位诺贝尔奖得主)和认知科学大佬唐·诺曼(Don Norman)的鼓励下,以加州大学圣地亚哥分校为基地,开始了“连接主义”(Connectionism)运动,这个运动的领导者是两位心理学家鲁梅尔哈特(Rumelhart)和麦克利兰德(McLelland),外加一位计算机科学家辛顿(Geoffrey Hinton)。 | |

不玩社交网络,隐私还是个事儿!

作者 AbelJiang | 2014-10-06 09:21 | 类型 机器学习 | Comments Off

|

节选自:http://www.wired.com 感兴趣可以看原文,较长,节选部分翻译 拜重度收集癖患者Google和Facebook所赐,只要你使用社交网络,就可以和隐私说拜拜了。但是最新的一项研究显示,即使你不用社交网络,这些公司还是可以挖掘出你的信息。确实有点吓人。 研究者无法从Facebook或是LinkedIn拿到数据,于是选择了对外公开存档数据的,相对较老的社交网络Friendster进行研究。研究者发现,如果Friendster使用某些先进预测算法,可以估测出一些非Friendster用户的敏感信息,比如一些非注册用户的性取向。 这项研究的作者之一,来自ETH Zurich university的David Garcia称,对于小众类别,比如同性恋,他的分析技术精度可以达到60%,而普通的分类算法精度不到5%。这篇论文仅分析了性取向,但是Garcia认为,这种分析方法同样适用于年龄,情感状况,职业,甚至政治立场。 值得一提的是在Facebook做得越来越大,越来越强调广告盈利,越来越多的涉足用户隐私问题的同时,一个刚诞生两个多月的Facebook替代品Ello,正以每小时50000名新注册用户的势头迅速崛起。Ello没有广告,并且允许用户使用非真实姓名,这也受到了不愿透露真实姓名边缘群体同性恋,双性人,变性人的欢迎。 | |

Persona机器学习应用–Follow Twitter的不同面

作者 AbelJiang | 2014-09-08 11:45 | 类型 机器学习, 行业动感 | Comments Off

|

新浪微博是一个非常棒的平台,但在产生有价值信息的同时,也夹杂了许多无用的信息。比如有些账号,本来是分享野史怪谈的,却冷不丁的夹杂了一些广告信息,或是纯个人吐槽发泄,这样就让你看微博的时候觉得非常乱杂。而Persona从狭义上就是用来解决这种问题的,也希望国内开发者,或微博官方也能推出类似应用,方便用户迅速提取有价值信息。下文引自techcrunch.com Our identities are prismatic. We’re not the same person to everyone. Yet when you follow someone on Twitter, your feed overflows with a combination of their personal, professional, and social tweets. But thanks to TechCrunch Disrupt Hackathon project Persona, you can choose which dimensions of someone’s identity you want to see. Persona uses machine learning to classify people’s tweets into separate themed timelines around different topics they tweet about, like their work, personal life, and interests. If you ever wished you could just get someone’s smart professional insights without knowing what they had for lunch, or love their taste in art but yawn when they nerd out on tech or current events, Persona could banish boring tweets from your feed. As someone who straddles a lot of scenes, I bet some of my Twitter followers would be relieved to follow just one side of my identity. By day I’m chronicling startups and analyzing the latest Facebook product changes, yet by the afternoon I’m sharing silly memes and soothing songs, and at night I’m posting photos from parties and hippie-dippie life affirmations. Entrepreneurs, culturenauts, and friends all follow me for different reasons, but I fear I overwhelm their streams with types of tweets they don’t want. Persona could solve this. It was built by the machine-learning guru and CEO behind Guesswork, a customer intent prediction and personalization tool we covered last month. Mani Doraisamy and his brother Prabhakar tell me that on Twitter “we’re blowing our own trumpets,” more concerned with broadcasting our opinions than with those who receive them. So while Persona began as a hackathon project, Mani plans to formally launch Persona soon here. Persona will automatically scan the words used in your tweets and assign them to three streams on your Persona page: personal, professional, or social. Alternatively, you can add custom labels to these dimensions of your identity and tag your tweets into them, which also teaches Persona’s algorithm. If you want to check out the different version of someone else’s Twitter stream, they don’t need to have signed up. Persona will run its machine learning algorithm on their profile and do the categorization for them. By working with the Twitter dev team at the Disrupt Hackathon, the Doraisamy brothers learned how to build Persona without running into API limit problems. And while they don’t plan to monetize the app directly, they’ll feed its learnings into Mani’s app Guesswork. Some believe we should all own up to the different sides of personality and live with a unified identity. But that’s easier said than done if you live or work with people who might not take kindly to your political views, humor, or after-hours adventures. You should never be ashamed of who you are, but with an app like Persona, you can still respect the time and attention of people who follow you, no matter who they want you to be. | |

A Few Useful Things to Know about Machine Learning

作者 AbelJiang | 2014-09-03 17:02 | 类型 机器学习 | Comments Off

Google收购图像识别初创公司Jetpac

作者 AbelJiang | 2014-08-26 16:57 | 类型 机器学习 | Comments Off

|

谷歌近年买下的各种公司:List of mergers and acquisitions by Google 原文链接:http://www.theguardian.com Google is buying Jetpac, a “city guides” company with a twist which used image recognition and neural network technology to recommend places it deemed the happiest, most popular or with the best views and scenic hikes. Jetpac offered special “City Guides” for more than 6,000 destinations, using neural network technology developed by Pete Warden, the company’s co-founder and chief technology officer. “We can spot lipstick, blue sky views, hipster moustaches and more, through advanced image processing on billions of photos,” Jetpac’s home page explains. The app worked by analysing public photos with location data shared on Flickr, Instagram and other photo networks for particular elements, and then extracting key elements about them. The current Jetpac apps will be removed from the Apple App store within days, and support will end on 15 September, Jetpac says on its web page. It did not yet have an app for Android. The purchase, for an undisclosed sum, points to Google’s growing interest in artificial intelligence applications as it seeks to grow offerings such as its Google Now personal assistant. This year it acquired the British AI company DeepMind for $400m. Jetpac, with its neural network systems, seems to fit into that area. Warden wrote two demonstrator apps, currently still available on Apple’s App Store: “Spotter” which attempts to identify objects, and Deep Belief, which can be “trained” to recognise objects. Both use neural network systems for their processing. Neural networks are collections of algorithms which in effect mimic the functioning of brain systems: they can be “trained” to recognise particular elements in pictures, or in text, and flag their occurrence or absence. The system relies for its accuracy on feedback rather than explicit programming – so that in training a neural network to recognise a moustache, one would give it a huge number of photos to work on, and keep telling it when it was correct and incorrect. The neural network dynamically adjusts the weighting of various algorithms until it the answers are more and more correct. Earlier this year Jetpac said it had identified the “UK’s happiest city” – which it identified as Belfast, based on public Instagram photos. At the time Warden said that 5m photos per day were being uploaded which included geotagging and were public – the raw “data exhaust” that Jetpac needed to produce its analysis. In August 2012 Google bought the printed travel guide company Frommer’s, but then sold it back to the founder Arthur Frommer in April 2013. | |

机器学习走向开源–PredictionIO founder Simon Chan专访

作者 AbelJiang | 2014-08-22 21:53 | 类型 机器学习 | Comments Off

|

原文链接:http://readwrite.com Making Machine Learning SimpleReadWrite: You call yourself the “MySQL of prediction.” What does that mean? Simon Chan: Before the birth of MySQL, database management systems (think Oracle, DB2, etc.) were largely inaccessible to many developers and companies. Such systems are complex, expensive and proprietary. MySQL has rewritten the history of the relational database industry. It allows every website and application, regardless of the size, to be powered by a database server. The current world of machine learning is similar to the old days of the database industry. Machine learning is still inaccessible to most companies and developers. The cost of development and maintenance of machine learning infrastructure is extremely high. Companies like Google, LinkedIn and Twitter spend huge amounts of money to recruit data scientists. PredictionIO, as MySQL did to the database industry, can be the machine learning server behind every application. It is 100% open source, developer-friendly and production-ready. RW: Machine learning sounds great, but historically hasn’t worked as advertised, or it’s required extensive engineering resources to pull off. What does PredictionIO do differently? SC: We believe that every prediction problem is unique; therefore, most black box machine learning solutions don’t work as planned. PredictionIO makes the life of developers easier by handling a lot of heavy lifting, such as algorithm evaluation and distributed deployment. It also comes with a number of built-in predictive engines for developers to use right away. But more importantly, PredictionIO is a customizable open-source product. This means that developers can optimize and improve the predictive engines whenever they need to. Open-Sourcing The MachinesRW: You’re open source. How does this help? SC: We don’t believe in “black box” approaches to machine learning, as I noted. Open source allows developers and data scientists to contribute to the PredictionIO ecosystem. PredictionIO is showcased by Github as one of the most popular open source machine learning projects in the world—thousands of developers are engaged in making it better. Currently contributions include SDKs (e.g., for iOS, .NET, Node.js) and plugins (e.g., for Magento and Drupal), but we’re also seeing new engines and algorithms run on top of our infrastructure. RW: How many companies truly need machine learning in their apps? What are some examples of how companies incorporate machine learning today? SC: As far as we know, hundreds of applications are powered by PredictionIO now. And it’s just the beginning. Le Tote, which sends personalized clothing to its subscribers, is using PredictionIO to discover customers’ fashion preferences. PerkHub manages enterprises’ employee perks programs and is using PredictionIO to personalize product recommendations in their weekly emails. We’re also working on some exciting projects yet to be announced in domains such as mobile health and gaming with applications that include churn analysis and trend detection. As Easy As MySQLRW: How hard is this? Can average developers really make use of this or do they need to be a PhD? SC: If you can use MySQL, you can use PredictionIO. RW: How do you plan to use your new funding? SC: There are a lot of product features we want to develop. We are hiring. Developers and machine learning engineers who are passionate about building the industry-changing machine learning server should contact us.

| |

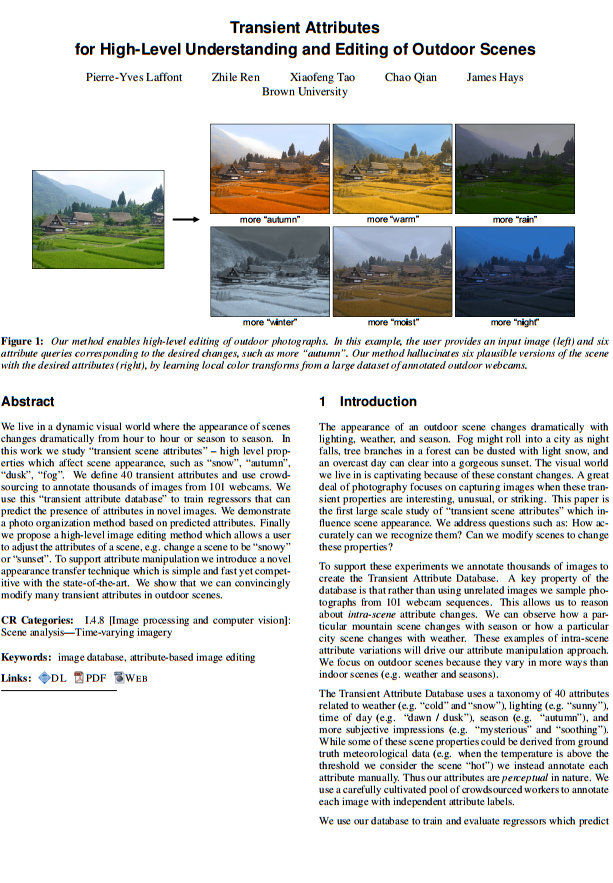

布朗大学新研究–图片编辑算法改变图片天气,季节

作者 AbelJiang | 2014-08-13 20:32 | 类型 机器学习 | Comments Off

|

布朗大学最近研发的图片编辑算法,可以通过简单的文本指令,瞬间改变图片中的天气,季节,呈现出一天中不同时刻的下效果。 该算法要求用户用自然语言指令,录入一系列包括天气,时刻,季节等特征。举例来说,想让一张晴天的照片变成雨天,只需要导入一张图,并且输入“more rain”就行了;一张七月的图片想让它更像一月拍的,那你只需要输入“more winter”。该算法可以通过常见的40余种室外天气特征来编辑图片。 这项研究的初衷是方便那些不熟悉图片编辑软件复杂操作的多数人,让他们能很容易的编辑和调节图片。 改变图片里的天气涉及很多细节,不仅是将蓝天变成灰色,还要对真个图片的颜色和对比度进行调节。这项操作对专业的图片编辑都要费一番力气,而这种新算法利用机器学习技术,使得这一切可以一键完成。 项目伊始,开发团队设定了四十种不同的环境特征,从简单的阴天,晴天,下雪,下雨,起雾,到主观性的阴郁,明朗,敏感,神秘,或是冷静。第二步是训练算法,这些不同的特征到底是什么样的。为了达到这个目的,研发者通过设置在世界各地的101台固定摄像头来采集同一景象在不同环境条件下的图片,并录入数据库。利用Mechanical Turk,借助人工标记超过8000张图片的特征(特征来自于先前设定的40种之中)。这些被标记了的图片被用于训练算法。 该项研究将会在即将召开的SIGGRAPH 2014进行展示。 参考链接:http://phys.org/news | |

Andrew Ng谈Deep Learning

作者 陈怀临 | 2014-08-04 09:05 | 类型 Deep Learning, 大数据, 机器学习 | Comments Off

|

《程序员》:Amara法则说,“我们倾向于高估科技的短期影响力,而又低估其长期影响力。”在你看来,Deep Learning的短期和长期影响分别是什么?历史上,我们曾对实现人工智能有过错误估计,对于Deep Learning的前景,人们是否过于乐观?

Andrew Ng:我对Deep Learning的前景很乐观,它的价值在过去几年已得到印证,未来我们还会沿着这个方向继续努力。语音识别、计算机视觉都将获得长足进步,数据与科技的碰撞,会让这一切变得更具价值。在短期,我们会看到身边的产品变得更好;而长期,它有潜力改变我们与计算机的交互方式,并凭借它创造新的产品和服务。

不过围绕Deep Learning,我也看到存在着某种程度的夸大,这是一种不健康的氛围。它不单出现于媒体的字里行间,也存在于一些研究者之中。将Deep Learning描绘成对人脑的模拟,这种说法颇具吸引力,但却是过于简化的模仿,它距离真正的AI或人们所谓的“奇点”还相当遥远。目前这项技术主要是从海量数据当中学习,理解数据,这也是现今有关Deep Learning技术研究和产品发展的驱动力。而具备与人的能力相匹配的AI需要无所不包,例如人类拥有丰富的感情、不同的动机,以及同感能力。这些都是当下Deep Learning研究尚未涉及的。

《程序员》:关于神经网络的研究,在很多方面依靠生物学、神经科学等领域。在你看来,Deep Learning的模型是否已经完善?若没有,目前最大的缺陷或困难在于何处?

Andrew Ng:Deep Learning模型尚未完善,主要存在两项挑战。一项是可扩展性,我们坐拥海量数据,却难以建造计算能力足够强大的计算机系统,处理这些数据。我青睐百度的原因之一,即在于它拥有复杂而强大的海量数据处理基础架构,但对Deep Learning来说,问题尚未得到解决。另一项挑战在于算法,我们也不知道恰当的算法是什么。从这两点看,尽管我们已取得了不小的进步,但前路依然漫漫。

《程序员》:为了开发智能机器,许多年前,Daniel Hillis和他的Thinking Machines曾尝试突破von Neumann架构,你觉得当今的硬件是否是实现智能机器的最好选择?如果不是,当前的计算机架构有哪些限制,我们需要做哪方面的突破?

Andrew Ng:这是一个有趣的话题。我们尚不知道怎样的硬件架构是智能机器的最佳选择,因而更需要拥有灵活性,快速尝试不同的算法。在这方面,GPU相对易于编程,因而可以高效地尝试不同的算法。作为对比,ASIC(专用集成电路)的运行速度比GPU更快,但开发适合Deep Learning的ASIC难度高、周期长,在漫长的研发过程中,很可能我们早已发现了新算法。

GPU与CPU结合是目前的首选硬件平台,不过随着技术的进一步成熟,这种现状有可能发生改观。例如,目前已有几家初创公司正在研发专门用于Deep Learning的硬件系统。

《程序员》:有一种说法是,对人脑机制理解的缺乏是我们开发智能机器的最大限制之一,在这个存在许多假设和未知的前沿领域进行研究,你怎样判断自己研究的方向和做出的各种选择是否正确?

Andrew Ng:诚然,神经科学尚未揭开人脑的运作机制,是对这项研究的一种制约。但如今我们尝试的算法,大多只是粗略地基于神经科学研究的统计阐释,这些研究启迪我们的灵感,鼓励我们尝试新算法。但现实中,我们更主要地依据算法真实的运行效果进行评判,假如一味追求模拟神经的运作方式,不一定能带来最优的结果。有时我们偏重神经科学原理,例如某些模拟大脑局部的算法;但更多时候,性能是准绳。若按比例划分,前者大约只占2%,后者则占据98%。

因为我们不知道何种算法最优,所以才不断尝试,衡量是否取得进步的方式之一(并非唯一方式),是观察新算法能否在应用中表现得更好,例如Web和图像搜索结果是否更准确,或者语音识别的正确率更高。假如回望五年,你就会发现,那时我们曾认为颇有前景的算法,如今已然被抛弃。这些年,我们有规律地,甚至偶然地发现一些新算法,推动着这个领域持续前进。

《程序员》:关于Deep Learning的原理,已有许多人知晓。为了做出一流研究和应用,对于研究者来说,决胜的关键因素是什么?为何如今只有少数几人,成为这个领域的顶尖科学家?

Andrew Ng:关于决定因素,我认为有三点最为关键。

首先是数据,对于解决某些领域的问题,获取数据并非轻而易举;其次是计算基础架构工具,包括计算机硬件和软件;最后是这个领域的工程师培养,无论在斯坦福还是百度,我都对如何快速训练工程师从事Deep Learning研究,成为这个领域的专家思索了很长时间。幸运的是,我从Coursera和大学的教学经历中获益良多。创新往往来自多个观念的整合,源于一整支研究团队,而非单独一个人。

从事Deep Learning研究的一个不利因素在于,这还是一个技术快速发展的年轻领域,许多知识并非依靠阅读论文便能获得。那些关键知识,往往只存在于顶尖科学家的头脑中,这些专家彼此相识,信息相互共享,却不为外人所知。另外一些时候,这群顶尖科学家也不能确定自己的灵感源于何处,如何向其他人解释。但我相信,越来越多的知识会传递给普通开发者;在百度,我也正努力寻找方法,将自己的灵感和直觉高效地传授给其他研究者。尽管我们已有这方面的教程,但需要改进之处仍有很多。

此外,许多顶尖实验室的迭代速度都非常快,而Deep Learning算法复杂,计算代价很高,这些实验室都拥有优秀的工具与之配合,从快速迭代中学习进步。

《程序员》:十年前,Jeff Hawkins在《On Intelligence》中已经向普通人描述了机器与智能之间的关系,这些描述与我们现在看到的Deep Learning似乎非常相似。在这最近的十年中,我们新学到了什么?

Andrew Ng:包括我在内,Jeff Hawkins的作品启发了许多AI研究者,多年以前,我个人还曾是Hawkins这家公司的技术顾问之一。但在现实中,每个人的实现细节和算法迥异,与这本书其实颇有不同。例如在书中,Hawkins极为强调与时间相关的临时数据的重要性,而在Deep Learning中,虽然用到了临时数据,但远没有那重要,另外网络的架构也大不相同。在最近十年中,我们认识到了可扩展的重要性,另外我们还找到了进行非监督式学习更好的方式。

关于工作选择

《程序员》:为什么选择百度开展你的工作,它的哪些特点,是你觉得其他公司所不具备的?

Andrew Ng:我喜欢在任务高度驱动的环境下工作,通常我是这些任务的发起者。我为能更好地发展AI,令互联网上的每个人都能从中受益而兴奋。

几个月前,我仔细评估了几个选项后,决定加入百度。一方面在于王劲团队打造了非常优秀的基础设施,同时百度还拥有庞大的数据。另一方面,我为百度的灵活快速所吸引,当我的朋友余凯和徐伟决定搭建GPU集群,马上就得到了实现,此外没有任何一家公司推出Deep Learning产品的速度快过这里,而且还是应用在互联网广告这种核心业务上。对于Deep Learning这样未知因素很多的技术来说,灵活性至关重要。我还发现北京的互联网公司讨论的往往是日活跃用户,而在硅谷则是月活跃用户,或许这也可以作为灵活性的一个注解。

还有一点我很少谈起,却非常重要——因为这里的人。与他们相处,我感到非常愉快。当我开始在百度工作后,妻子Carol曾对我说,她从未见过我如此努力,却又如此开心。

《程序员》:你在百度的研究产品和成果能为外界带来什么(例如是未来否有可能将你的成果共享给其他人,推动整个领域的发展)?

Andrew Ng:我希望能将成果与外界分享,也许不是所有内容都适合,但希望通过某种形式,分享我们的研究。不过我加入的时间尚短,接下来我希望能有更多成果可以公布。 | |