10Gbit 以太网 FCoE 与 iSCSI 之对决 (FCoE vs. iSCSI. vs ATAoE)

作者 Cheng | 2010-11-25 17:27 | 类型 行业动感 | 38条用户评论 »

|

SNIA SDC2010: 10Gbit 以太网 FCoE 与 iSCSI 之对决 (FCoE vs. iSCSI. vs ATAoE) 存储网络工业协会 (SNIA, 不是SINA) 组织的一年一度的 Storage Developer Conference 2010 会议今年九月份照例在硅谷 Santa Clara 召开,本文试图透过此会议之 presentation slides 对当前存储行业之热点问题分析一二: 首先面临的问题是如何取得这些 slides, 直接点击左侧 “2010 Presentations” 会到达登录页: http://www.snia.org/events/storage-developer2010/presentation 可能拦住了大部分访问者,不过这边有人去了现场,拿到了用户名和密码可以登录: ID: SDC2010_SantaClara 登录后你会发现其实是个小把戏:多一个 ‘s’, 单数变复数,并且这个URL也可以不经登录、直接访问的,只是未公开而已, http://www.snia.org/events/storage-developer2010/presentations (其实这几年SNIA的惯例都是如此,大家以后熟悉了可以自己猜出来,这也是包括 SNIA 在内各会议举办方的惯例:花了报名费到现场参加会议的人才能知晓某个特别URL或ID&Password之为特别途径去取得 slides, 要不然每年上千美元的报名费找谁收去。嘘——潜规则大家知晓就好,不要没事找事去通知SNIA的人、下一年改了规则就不好玩了) ========================= 正文 ========================= 关注近几年 SDC 会议材料 (上面URL中2010可以换成2009,2008,2007同样有效), 有几个传统话题:

新兴话题:

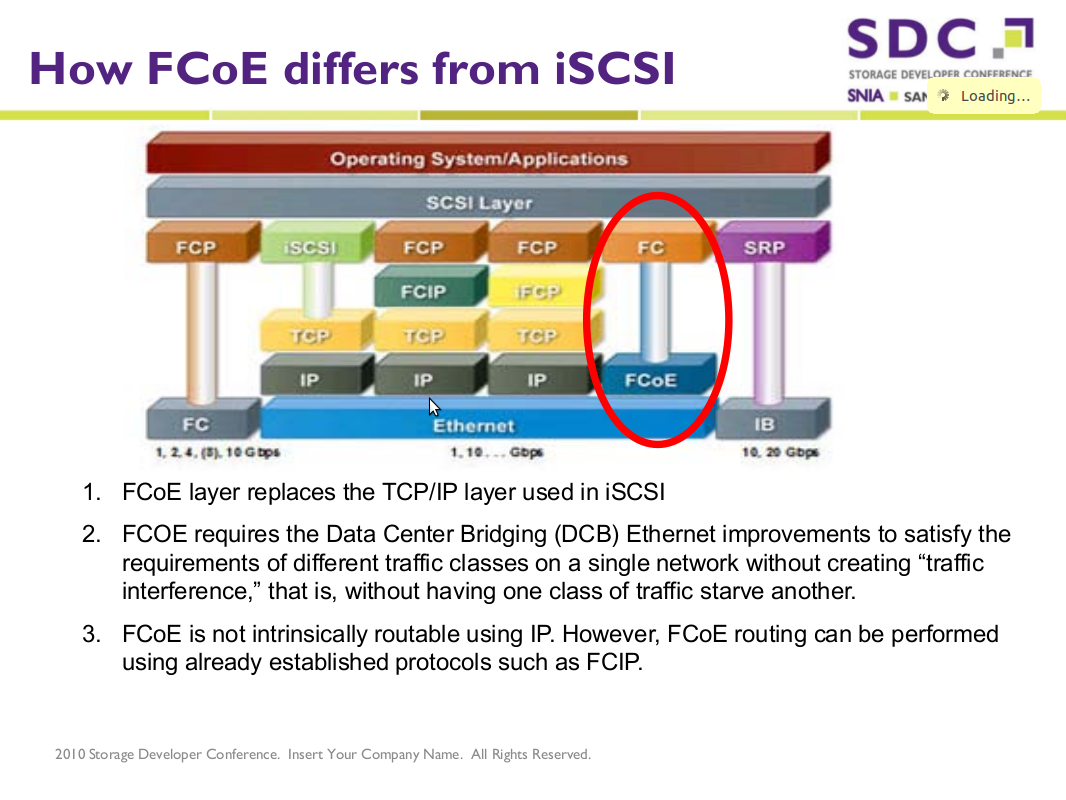

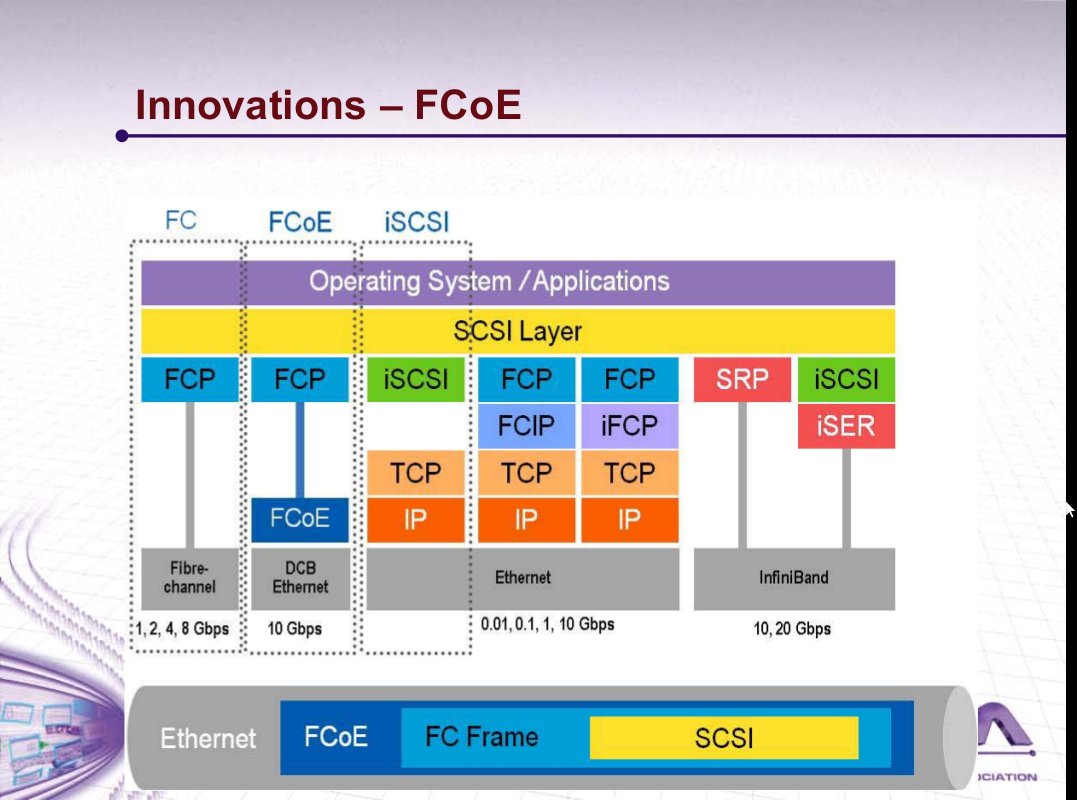

======================= 正文 FCoE ======================= 干货在我看来就只有 FCoE 了,这是个相对很新的协议,全名是 Fibre Channel over Ethernet, 直到2009年6月才有INCITS 的 T11组的 FC-BB-5规范,设计之意图就是运行在以太网之上的光纤存储协议; SDC2010上有 LSI 的 Distinguished Engineer 在同时测试两种HBA的过程中有一些总结: 从部署方面说,早在2009年加州洛彬矶县给1千万居民的档案data-center考虑升级时就在考虑了FCoE,有了这张图: http://www.networkworld.com/supp/2009/ndc1/012609-fiber-channel-over-ethernet.html

这个领域目前是方兴未艾,就连许多名词都尚未达成业界共识:

另一篇 slides 在谈 FC updates 也提到了 FCoE 的一些详细协议细节,特别一点是上面提到 DCB Ethernet, 并不是普通的10Gbit Ethernet, 查了一下主要区别在于 PAUSE 信号, Priority Flow, Congestion Notification 等, 将 普通 10Gbit Ethernet 进一步打造成为 Lossless Ethernet, 上层的 FC 协议并没有 TCP 之类重传的智能; 更进一步可以看看 “Intro to FCoE by EMC” 视频; http://www.youtube.com/watch?v=EZWaOda8mVY iSCSI 已死? FCoE 当立?话说 iSCSI 协议进 RFC3720 还是2003年的事情,话犹在耳,但 FCoE 的概念自2005年出道以来,就不断有人预示了 iSCSI 的最终没落,且看评论: http://www.theregister.co.uk/2008/10/15/fcoe_io_kill_iscsi/ The Storage Architect 的观点认为 iSCSI 最终失败的原因有几个:

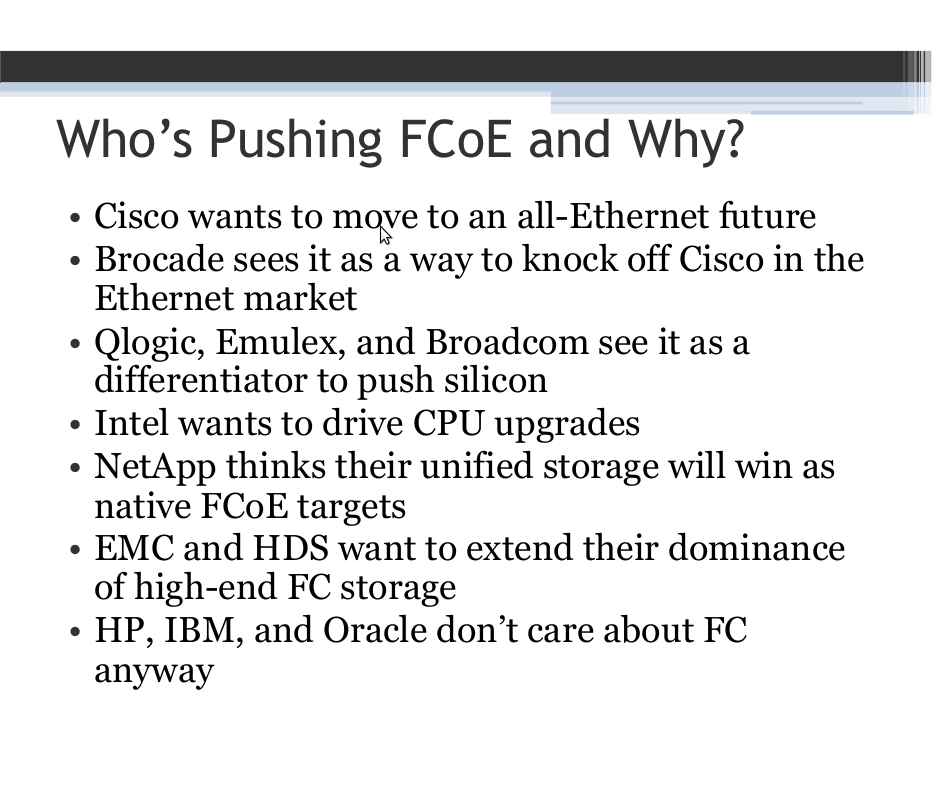

另外, iSCSI 虽有 TCP/IP 带来的路由能力,但在企业存储网几乎无用;FC界早有FCIP和iFCP尝试把FC运行在TCP/IP之上、失败告终。 The Storage Architect 的观点 既然 iSCSI 失败,那么 FCoE 将显然地成功。 http://virtualgeek.typepad.com/virtual_geek/2009/06/why-fcoe-why-not-just-nas-and-iscsi.html 再看 FCoE 背后的 Big Players, 今年 lisa10 中有个 slides 总结了一张如下: 插曲:提到以太网层面上的存储协议竞争,还不得不提及另一家小公司 Coraid 早在2004年就已实现的 相当轻量级的 ATA over Ethernet 协议, http://en.wikipedia.org/wiki/ATA_over_Ethernet 轻量级到了什么程度呢? 相比于 FCoE iSCSI 动辙上百页的描述文件,ATAoE 甚至只用了9页就描述完了。而且它甚至是无连接的,就不用说 iSCSI 的 Login/Session Phase 了,AoE 可以类比于 UDP 之 over IP, 而且 AoE 只放了14字节头在 Ethernet header 之上(于是共28字节)、等等;可惜小公司似乎不关注于此类大公司大市场所需要的合纵连横之术,找遍了互联网就只有一家 Coraid 在死守,甚至在 LinuxJournal Magazine 上每月都整版广告 “Professional ATAoE”, … 是啊,有谁能比你更专业于 AoE 呢。 国内依然是 IP-SAN (iSCSI) / NAS 市场的火热,只在今年SNW世界有思科有一人略讲了FCoE协议,其它仍停留在”大云存储”之类比较虚的概念层面。不过就国内相对滞后发展的特性而言,FC 的 dominant地位也许并不存在,一旦10Gbit普遍流行,依然可以在上面运行TCP/IP和iSCSI, 对应于上面LSI所做的 FCoE vs iSCSI 的测试;不知在硬件层面国内有没有厂商能做得出10Gbit以太网芯片、或是交换机芯片,可以比肩 Cisco Brocade ?; 但至少存储整机方案方面,不要再停留在 IET SCSI Target + Samba 就出一个 IP-SAN (iSCSI) / NAS 了,想想 FCoE, 是代替 iSCSI 翻牌的另一次良机。 | |

雁过留声

“10Gbit 以太网 FCoE 与 iSCSI 之对决 (FCoE vs. iSCSI. vs ATAoE)”有38个回复

都架在10GE上的话,ISCSI与FCOE的性能差别不大,一个是ETH+IP+TCP+SCSI,另一个是ETH+FC+SCSI(FC也有两三层)。主要是又能卖更多的新硬件了,不是别的。

以cisco在数据中心的地位,FCoE有很大的胜算。

cisco在数据中心什么地位?

FCOE和iSCSI谁能走得更远,其实主要还是核心厂商的支持和推动,两大阵营的比拼。现在云计算这么火,而之前的网格计算显得很落魄,关键的原因也是工业界的支持。

cisco在数据中心这块市场还是非常牛叉的,至少在网络设备这块是No.1,在存储这块嘛也在极力渗透。

FCoE和iSCSI都是网络层的技术,你想想看那个的赢面大?

传统以太/IP技术QoS缺陷成就了FC,这也是iscsi/NAS被认为是低端产品的原因。

在数据中心,以太和FC分别统治着LAN和SAN,谁也无法吃掉对方,实现融合只能是兼容方式。FC显然不可能兼容以太,只有以太兼容FC了。因此新的数据中心以太网必须能够承载FC,而且必须保留FC协议的功能。更重要的是,提供承载功能的以太技术,必须达到类似FC的QoS,于是传统以太的改良版CEE出现了。

在数据中心,FCoE只是表象,真正的革命是CEE。只有具备了CEE功能,FCoE才能在整个数据中心部署,否则只能作为简化服务器I/O的功能部署在边缘。

大云存储好玩, 里面有FCoE + OTV + 另外一个好玩的东西. 不过得等几个月才有

好文章,学习并收藏!

#7楼说的没错,CEE才是重点,但这个术语已被 IETF 标准化成为 DCB Ethernet 了,

• Data Center Bridging is a project to create lossless Ethernet

• IEEE name is Data Center Bridging (DCB)

• Cisco trademarked Data Center Ethernet (DCE)

• Many vendors used to call it Converged Enhanced Ethernet (CEE)

http://www.snia.org/events/storage-developer2010/presentations/bof/GregMcSorley-Latest_Update_Fibre_Channel.pdf

#lisa10 的这一篇说的是相同一回事 Storage over Ethernet: What’s in It for Me?

Stephen Foskett, Gestalt IT

http://www.usenix.org/events/lisa10/tech/slides/foskett.pdf

因为与TCP/IP可以在允许丢包的以太网上工作不同的是,FC以及上层的SCSI都不允许丢包,为了开发FCoE是由Cisco早在2007年就在开发DataCenterEthernet,后面其它Player跟进而发展了CEE,其内容相似只是名词术语不同而已,直到2009年IETF给它标准化成为 Data Centre Bridging, 是在普通10Gbit以太网又加上了这些扩展协定:

- Priority Flow Control (PFC) 802.1Qbb

- PAUSE 802.3x

- Traffic Classes 802.1p/Q

- Bandwidth Management (ETS) 802.1Qaz

- Data Center Bridging Exchange Protocol (DCBX)

- Congestion Management (QCN) 802.1Qau

最终打造成为了 Lossless 10Gbit Ethernet.

to crquan:

请教一下,EVB有没有进展?

什么是EVB?有相关标准化的术语么?

http://en.wikipedia.org/wiki/EVB

802.1Qbg和802.1Qbh,将VM之间的交换功能由Server转移到Switch,解放服务器CPU资源

Cisco做的硬件FCoE方案(CNA/Fabric/Switch)谁都插手不了,

现在Intel为首主导的Open-FCoE项目看前来前景不错,就看哪些厂家能在10Gbit成熟的时机快速的集成出产品;

新加坡已经有企业在部署10Gbit以太网了,反而是银行、航空等传统领域,而IT型企业还满了拍子。

还是弯曲的资源丰富,很快就淘到了2篇非常有价值的关于存储的文章

fcoe 相比iscsi还是成本高,两者肯定还是要共存很久的。AoE要说也挺开放的,成本最低,为什么没有其他公司支持呢?

窃以为,SNIA就是一个存储厂商自娱自乐的PARTY,我想针对WEB industry ,厂商们的这种自我意淫是很可笑的。。。;可是针对商业用户就不同了,banking或者utility需要商业化的承诺。与此对应的,google或者FB(也包括国内的BAID,TB)自己开发一个OSI 2层以上的存储协议也就是半年的功夫而已的。。。

基于markting talking的云存储。。。。。。真的只是浮云!

作者明显有很强的倾向性,其实FCoE和iSCSI到底谁最后会赢还不一定。

原因很简单:

iSCSI原来一直不被看好的主要原因是长期受制于网络的性能,原来GE的性能比FC低很多。但是这个问题现在逆转了,FC的速率是4倍速提升,而以太是10倍速提升。在10GE时代,iSCSI已经与FC的性能不相上下了,可是以太的发展远远快于FC,目前40GE即将部署,100GE技术也已成熟,请问在40GE和100GE时代FC怎么在性能上与iSCSI竞争?

其次,有人可能说FCoE不是解决了FC的速率问题了吗?可是FCoE需要DCE支持,需要端到端的流控和新协议,新PHY,新的MAC。对原来的以太基本不兼容,这样扩展性就很差。CISCO自己的方案中NEXUS7000就不支持。可见,应用范围很小。

而iSCSI不存在这个问题,它是基于IP组网的,扩展性好是毋庸置疑的。以太组不了大网是众所周知的,这也是为什么CISCO要搞一个OTV的原因,请问穿越OTV还能再提供DCE的性能?这不是笑话吗,支持OTV就默认了实际上扩展性还是要IP才行

一个小小的问题, 多条10GB链路可以做聚合么?

在传统的ethernet环境中, 数据包可以乱序到达, 在目的端重新排序, 而在DCB, DCE中, 似乎数据包是以发出的顺序到达目的端的, 不知道理解的对不对.

to 云中漫步: 完全赞同,俺也觉得FCoE没戏。

让用户把以太网交换机换掉,换个FCoE交换机,然后才能支持FCoE,这跟FC有什么差别吗?如果用户需要用Lun copy做远程备份,用FCoE还需要再拉一根光纤,这也不现实。10GE iSCSI的性能已经超过了8G FC,TCP/IP协议栈开销是大了一点,随着硬件的更新换代,软件的进步,这已经不是主要问题了。

今天的FCoE,就是昨天的ATM、OS/2,自我标榜技术先进,有高贵血统,被很多人看好,并认为是未来方向。最后却不了了之。

自从有了iSCSI之后,以前不知道SAN啥东西的小企业,现在都开始用IP SAN了,比如网吧,这一定是发展的前兆。

有前途的技术,都是从山寨开始的,比如:IP网络、X86微处理器、ARM。而那些自我标榜有着高贵血统的“先进”技术,从诞生的一刻起,就经开始走向没落了。

从简化I/O和网络融合角度看,FCoE和iSCSI实现了相同功能,但FC的可靠性是传统IP/以太网无法比拟的。FCoE保留了FC网络的可靠性,因此发展迅速。

基于可靠性考虑,在大型数据中心里,没有FC是不可想象的。IP SAN的应用仅限于低端,有国内存储厂商轰轰烈烈发布了万兆IP SAN,最终还是不得不在该设备上提供FC接口。

OTV与FCoE没直接关系,它解决的是跨广域虚拟机迁移问题:由于虚拟机只能在二层网络内迁移,因此不得不在三层的广域网里打一个二层的隧道。

FCoE及相关技术产品化很快,服务器主流厂商都在推CNA卡。网络厂家方面,Cisco在N5K FCoE边缘解决方案之后推出了边缘到核心的FCoE解决方案(10月N7K发布了32Port FCoE板卡)。Brocade11月发布了全新的FCoE交换机VDX6720,HP/H3C即将发布FCoE产品,Juniper EX系列也宣称未来支持FCoE。同时越来越多的存储厂家也在其设备上提供FCoE接口,包括IP SAN厂家。

10G物理链路捆绑没有问题,但由于FC与以太的网络可靠性机制不同,多条FCoE链路无法捆绑。FC/FCoE通过多条互相独立的链路保证可靠性,每条链路都保证顺序到达。

To OS9600

你还没明白我的意思,FCoE需要DCE的支持才能运行,而DCE是全新的技术,支持很有限,这一点限制了其应用范围。即便是CISCO也只是在NEXUS5000下面支持了这个协议族。也就意味着用以太承载FCoE时部署范围不能超过一个NEXUS5000的范围。这是从设备的角度来看其局限性。

从协议的局限性来看,全以太的二层网络做IDC网络时无法组成大型网络,这是由以太本身决定的。正因为如此,CISCO才需要OTV把二层扩展到其他的二层以太网去。但是问题在于OTV是三层的协议,DCE涉及到物理层和链路层底层的握手协商功能无法通过OTV透传到对端,使得DCE穿越OTV失效。失去了DCE的支持,FCoE无法可靠工作。

从上面的分析可以看出,FCoE所提供的高性能与高可靠完全是有下面的DCE支持的,没有DCE,FCoE就什么都不是了。而如果部署DCE,iSCSI也可以工作的很好。楼上说FC的可靠性是IP无法可比恐怕说法错误,说性能好倒是真的,因为FC是帧结构传输,实时性好。但是FC的致命伤是其有限的扩展性和对传输介质近乎变态的要求,使得FC难以部署在大型网络。

To OS9600

从目前的市场发展趋势来看,FC还是占有绝大多数市场份额,这是历史原因。但是在企业万兆开始流行之后iSCSI的增长率大大提高,2009年全年,用户在iSCSI存储设备上的开支为19亿美元,据IDC统计,到2013年,这一数字将增长到44亿美元,每年的增长率达到 了23.4%。2009年用户在光纤通道/FCoE/InifiniBand上消费了92亿美元,据IDC统计,到2013年将会增长到111亿美元,每 年的增长率不到5%。Forrester市场研究公司对213家公司做了一次关于存储和统一连接规划的调查,调查发现2/3的受访 者在未来一至三年内有转向统一连接的计划,有56%的人认为iSCSI是最佳候选,而27%的人认为FCoE才是最佳候选。数据中心市场分析公司IT Brand Pulse的CEO兼统一网络实践高级分析师Frank Berry说:“我的确认为只要你有一个无损的以太网连接,iSCSI就可以用来统一你的存储”。

Berry预计未来5年内iSCSI存储的销售收入会超过光纤通道存储的销售收入。

To:云中漫步

云兄高见,佩服。

本人对数据中心比较感兴趣,谈谈个人见解,请指教。

FCoE需要DCE的支持才能运行,而DCE是全新的技术,支持很有限,这一点限制了其应用范围。即便是CISCO也只是在NEXUS5000下面支持了这个协议族。也就意味着用以太承载FCoE时部署范围不能超过一个NEXUS5000的范围。这是从设备的角度来看其局限性

————————

如果FCoE部署在边缘(如N5000、Brocade 8000),则无需DCE。如果FCoE全网部署(N7000+N5000或Brocade DCX+8000),则必须DCE(N7K已经支持DCE)。

从协议的局限性来看,全以太的二层网络做IDC网络时无法组成大型网络,这是由以太本身决定的。正因为如此,CISCO才需要OTV把二层扩展到其他的二层以太网去。

———————————

FCoE仅仅适用于数据中心内部,跨广域的数据中心互联还是以光纤直联(城域)或三层互联(FC/IP网关)解决,

如果部署DCE,iSCSI也可以工作的很好

———————————-

FCoE的优势之一就是兼容现有的FC,从保护用户投资和适应服务器管理员使用习惯角度看,FCoE比iSCSI更有优势。而且,即便是都在DCE里跑,FC的可靠性也比IP高(FC没有重传机制)。

FC可靠性比IP高:

IP传输采用Push方式,无论接收端端情况如何,发送端先把数据发送过去,尽管有流控机制,但QoS仍然很难保证。

FC传输采用Pull方式,在确认对端可以接收之后,发送端才传输数据。

两种机制差别很大,在服务器访问繁忙时,FC可以保证大规模的并发访问,而IP则把大量带宽和服务器资源浪费在数据重传上。

安全性方面:FC SAN连接服务器和存储设备,不连接终端,避免了攻击和病毒。

新用户,写两句。 关于云中漫步提到的 在Nexus 5000 过去FCOE只是支持single-hop, 就是FCOE的包无法跨越第二个N5000的问题已经解决。两种方法,或者第一个N5000 启动NPV模式, 或者支持FCOE的设备,一般叫FCF(FC forwarder) 之间像FC一样跑E Port(NE) port 。

另外,个人觉得FCOE 应该有戏, 主要是Ethernet的发展, 就是一个简单+便宜的历史。 如果有一天, 你的服务器上主板标配一个FCOE口, 可以同时传输Ethernt+FC,用户非常容易接受。而且,量越大,价格越便宜。现阶段的驱动可能在数据中心中可以减少一半的线缆。

另外, DCE,CEE,DCB都是一个东西,CEE大概是Broacade等提出的。DCE 是思科提到。最后 IEEE推出标准 DCB。 主旨是如何做一个不丢包的Ethernet, 以便承载不允许丢包FC。ANSI 的 T11 也做了关于FC的物理层,数据链路层如何用Ethernet的标准。所以ISCSI 是SCSI over IP。 FCoE 是FC over lossless Ethernet。 DCE应该对 ISCSI 没有帮助。

没有DCE,FCoE就什么都不是了。而如果部署DCE,iSCSI也可以工作的很好

————————-

FCoE保留了FC特征,解决了服务器与存储之间通信可靠性,而DCE解决了网络转发的可靠性,二者缺一不可。

iSCSI基于IP,即使承载在DCE上,服务器与存储之间通信仍然不可靠

to 26楼:

N7000的FCoE板卡N7K-F132XP支持NPV或FCF吗?

云中漫步提出了一个很好的问题:“FCoE需要DCE的支持才能运行,而DCE是全新的技术,支持很有限,这一点限制了其应用范围。”

实际上,就算是FCoE在服务器端取代FC,对用户来说也是非常有吸引力的,FCoE的全局扩展可以慢慢做。

另外,我觉得FCoE和iSCSI至少在先阶段针对的完全是不同的市场,高端应用包括银行、医疗、政府部门,至少在三年内不可能在存储领域考虑iSCSI

To All:

这里不是争论iSCSI与FC谁好谁坏的问题,而是谁会最终占网络存储的主流的问题。 就好比拿IBM的大型机与PC比,或者ATM与IP比。 一点小小的性能优势无法改变市场趋势,否则无法解释性能低劣的Windows打败了性能更好的OS2,DEC的VAX打败了IBM的大型机,PC服务器打败了UNIX服务器。实际上,用户在选择时重点是够用就好,并非性能发烧友。我承认银行可能还是会固守在FC上,实际上很多银行还在用大型机,说明银行不差钱。但是大部分企业还是要计算IT成本的,否则无法解释iSCSI增长率高于FC的事实。

其实这里楼上想说的是企业已经在FC上有大量的投资,希望能保护投资,那么应该在交换机上出FC口,在交换机的线卡上实现FCoE的封装和协议。至于成本,FCoE成本低吗?没有看出来。传统以太是很便宜,那是所有人都在用导致海量的结果。FCoE只有存储有用,DCB从头到尾是全新的,虽说有个以太的名字,但是和我们说的以太不是一回事。用的厂家,部署的设备都极少,请问海量从哪里来?成本怎么摊薄?

目前的现状是,iSCSI硬卡只有Emulex和Broadcom(尚未发布只是公开)的CNA卡支持,后续可能会有更多的厂商推出万兆iSCSI硬卡。如果用软iSCSI initiator的话,一个10G口子会耗掉30%左右甚至更高的CPU,就算用最新的Intel CPU也是这样,所以基本上4个10G口就会耗死一台阵列。但是FC卡就不会有这种情况,FCoE同样也不会。退一步讲,如果10G的FCoE与硬10G iSCSI比的话,卡件与协议本身来讲都差不多,成本也差不多,所以就要看外围辅助设备的成本,一台FCoE交换机目前来讲还是远贵于10G以太交换机,所以要是小规模部署,甚至不如用8G FC交换机划算了。其次是看看场景,FCoE更适合想融合之前已经部署的FC与新部署的以太网的场景,也就是大型久建的数据中心,对于新建数据中心,这个趋势还不明朗,之前和Emulex的一个人交流过,他的意思是新建数据中心他们推荐使用iSCSI硬卡,但是我估计这种说法是含有很大水分的,毕竟Emulex是目前仅有的一家提供硬iSCSI卡成品的公司,他们推荐iSCSI可能有一定市场目的。但是我个人看法,FCoE目前Qlogic、Brocade和Emulex都有产品了,为何10G的iSCSI硬卡只有Emulex一家产品,证明FCoE今后可能会有一波行情。 FCoE和iSCSI,谁O不是O?区别就是一个是FC,一个是TCPIP,抛开以太网,单看FC和TCPIP,前者高效但是扩展性差,后者效率稍低但是扩展性很好,其实这已经与以太网无关了,还是最后到底是认同FC还是认同TCPIP的问题。我的看法是,FCoE会弄出一波行情,但是FCoE,像FC一样,很邪门,要求交换机配合,交换机里必须灌入相应的Firmware模块来处理这些Fabric协议逻辑,FCoE交换机除了需要处理Fabric逻辑,还需要处理Fabric到以太网的转换翻译逻辑,不但增加了复杂度和故障点,而且势必又会在多个厂商之间产生兼容性问题,这个恐怕会成为它称霸的一个累赘。所以我个人还是偏向于看好iSCSI的称霸。FCoE与iSCSI,厂商也尚未看清,谁也不敢贸然选路。

云计算兴起,计算资源、存储资源越来越集中,相应的数据中心的规模越来越大,组网越来越复杂。数据中心的可靠性要求也越来越高,网络结构也需要简化。FCoE、DCE是客户需求催生的结果,不是过度消费。

iSCSI增长不代表FCoE没有前途,二者各有市场。iSCSI应用集中在中小企业或大企业的非关键业务上,但至今为止,iSCSI还没有进入大型数据中心,那里依旧是FC/FCoE的天下。

回 29楼, F系列卡硬件支持FCF

To 冬瓜头,赞同。

To All

先来简单review一下FCoE的背景情况:

FCoE从开始到现在,一直都是Cisco在主导。2008年,Cisco拉着Nuova一起和主要的存储适配器厂商Intel,Qlogic,Emulex建立了CIN-DCBX的技术术语,EMC/Netapp等存储厂商经过测试开始绑定Nexus5k开始销售。

很快,Cisco推出了UCS并使用Nexus5k的硬件并集成了FCoE的功能,Qlogic/Emulex也相继发布了新一代的CNA卡,在CEE-DCB的市场炒作下,FCoE的标准最先被T11的FC-BB-5发布出来,IEEE的DCB标准草案也频繁更新,IBM/HP/Dell等相继resell Cisco的Nexus5k。

2010年,Cisco本身的FCoE不断完善功能,Nexus5k支持了Multi-hop能力,Nexus7k新版本下的F1卡也即将支持FCoE。同时,Emulex/HP/Intel/Linux/EMC等公司纷纷加强FCoE的投入力度。

再来发表一下个人看法:

FCoE是Cisco是站在自己的市场角度、根据敏锐的市场需求分析而开发的一块新地盘,一马当先的冲在前面,同时,依赖自己的行业号召力和合作关系(当然也有利益关系)在推动行业主流服务器、存储厂商加大力度一起开发,也取得了不小的进展。

但是,FCoE在Nexus5000上已经支持快2年了,真正大规模部署的案例其实还是少之又少,其原因是什么吗?

我想,这个问题的答案如32楼的冬瓜头已经基本解释很清楚了。目前厂商尚且没有最终定论,用户(有思想的)又怎么会看的清楚?至于坚定的选择FCoE的路线,还是iSCSI的道路,只有拭目以待。

最后总结一下个人观点:现阶段FCoE可能要比iSCSI走在前面,长远来看iSCSI一定会赶上甚至占据领先位置。

iSCSI随着DCB技术的标准化及成熟必定受益,其性能、延迟及不稳定行等传统诟病将大大改善,而IP已经被证实是未来网络的核心。Cisco的FCoE技术的广域扩展实现也是要依赖于FCIP的。

可以看到,FCoE像FC一样并不开放,身体变了,思想依然没变,而且还要求身体跟着脑袋变一变(CEE/DCE)。本来承载到以太网上,指望着开放一些。所以,这里面的猫腻就看出来了,FCoE是思科称霸存储网络的一张王牌,其目的就是为了称霸存储网络,进一步称霸数据中心,从VCE,VCN联盟就看出来了。思科。。。。

FCoE像FC一样不开放,身体变了,思想依然没变,而且还要求身体跟着脑袋变一变(CEE/DCE)。本来承载到以太网上,指望着开放一些,现在看来,只是改朝换代而不是革命。所以,这里面的猫腻就看出来了,FCoE是当初Cisco主推的,Cisco称霸了以太网,他当然希望存储网络全都转到以太网,但是传统FC根深蒂固,所以弄出个FCoE来,以太网宁愿在FC的光辉思想下对自身的一些“瑕疵”进行修改。FCoE作为Cisco称霸存储网络的一张王牌,其目的就是为了称霸存储网络,进一步称霸数据中心,Cisco同样拥有自己的服务器,他只是没有自己的存储,所以他选择与别人结盟。从VCE,VCN联盟就看出来了。

而Intel的Openfcoe,显然是希望大家都用软Initiator,靠强大的CPU来执行而不是专用ASIC从而带动CPU的销量和发展。

英特尔发布开源Open FCoE技术

http://www.oschina.net/news/15120/open-fcoe