The Dawn of Artificial Intelligence

作者 AbelJiang | 2015-05-26 20:47 | 类型 Deep Learning, 机器学习 | Comments Off

百度语音识别新突破–Deep Speech系统

作者 AbelJiang | 2014-12-24 11:33 | 类型 Deep Learning, 机器学习 | Comments Off

|

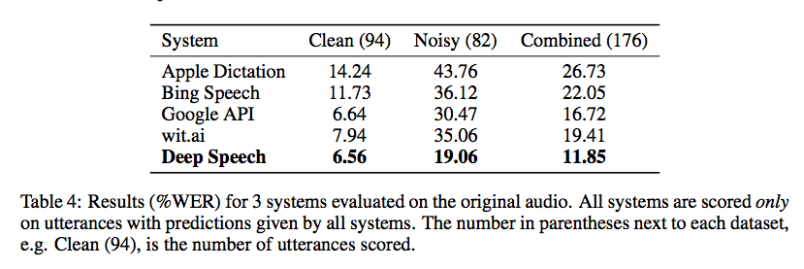

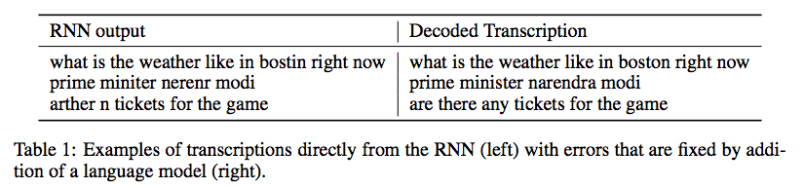

原文转载自:https://gigaom.com 相关论文:DeepSpeech: Scaling up end-to-end speech recognition Chinese search engine giant Baidu says it has developed a speech recognition system, called Deep Speech, the likes of which has never been seen, especially in noisy environments. In restaurant settings and other loud places where other commercial speech recognition systems fail, the deep learning model proved accurate nearly 81 percent of the time. That might not sound too great, but consider the alternative: commercial speech-recognition APIs against which Deep Speech was tested, including those for Microsoft Bing, Google and Wit.AI, topped out at nearly 65 percent accuracy in noisy environments. Those results probably underestimate the difference in accuracy, said Baidu Chief Scientist Andrew Ng, who worked on Deep Speech along with colleagues at the company’s artificial intelligence lab in Palo Alto, California, because his team could only compare accuracy where the other systems all returned results rather than empty strings. Ng said that while the research is still just research for now, Baidu is definitely considering integrating it into its speech-recognition software for smartphones and connected devices such as Baidu Eye. The company is also working on an Amazon Echo-like home appliance called CoolBox, and even a smart bike. “Some of the applications we already know about would be much more awesome if speech worked in noisy environments,” Ng said. Deep Speech also outperformed, by about 9 percent, top academic speech-recognition models on a popular dataset called Hub5’00. The system is based on a type of recurrent neural network, which are often used for speech recognition and text analysis. Ng credits much of the success to Baidu’s massive GPU-based deep learning infrastructure, as well as to the novel way them team built up a training set of 100,000 hours of speech data on which to train the system on noisy situations. Baidu gathered about 7,000 hours of data on people speaking conversationally, and then synthesized a total of roughly 100,000 hours by fusing those files with files containing background noise. That was noise from a restaurant, a television, a cafeteria, and the inside of a car and a train. By contrast, the Hub5’00 dataset includes a total of 2,300 hours. “This is a vast amount of data,” said Ng. ” … Most systems wouldn’t know what to do with that much speech data.” Another big improvement, he said, came from using an end-to-end deep learning model on that huge dataset rather than using a standard, and computationally expensive, type of acoustic model. Traditional approaches will break recognition down into multiple steps, including one called speaker adaption, Ng explained, but “we just feed our algorithm a lot of data” and rely on it to learn everything it needs to. Accuracy aside, the Baidu approach also resulted in a dramatically reduced code base, he added. You can hear Ng talk more about Baidu’s work in deep learning in this Gigaom Future of AI talk embedded below. That event also included a talk from Google speech recognition engineer Johan Schalkwyk. Deep learning will also play a prominent role at our upcoming Structure Data conference, where speakers from Facebook, Yahoo and elsewhere will discuss how they do it and how it impacts their businesses. | |

【邢波】机器学习需多元探索,中国尚缺原创引领精神

作者 陈怀临 | 2014-12-17 11:49 | 类型 Deep Learning, 机器学习, 科技普及 | 1条用户评论 »

|

【邢波Eric P. Xing】清华大学物理学、生物学本科;美国新泽西州立大学分子生物学与生物化学博士;美国加州大学伯克利分校(UC,Berkeley)计算机科学博士;现任美国卡耐基梅隆大学(CMU)计算机系教授,2014年国际机器学习大会(ICML)主席。美国国防部高级研究计划局(DARPA)信息科学与技术顾问组成员。(他在中国大数据技术大会上的报告请参考阅读原文链接) Professor of Carnegie Mellon University Program Chair of ICML2014Dr. Eric Xing is a Professor of Machine Learning in the Schoolof Computer Science at Carnegie Mellon University. His principal researchinterests lie in the development of machine learning and statisticalmethodology; especially for solving problems involving automated learning,reasoning, and decision-making in high-dimensional, multimodal, and dynamicpossible worlds in social and biological systems. Professor Xing received aPh.D. in Molecular Biology from Rutgers University, and another Ph.D. inComputer Science from UC Berkeley.

【杨静lillian】这次您受邀来中国参加大数据技术大会,在您看来,中国大数据相关技术和生态发展到了什么水平?与美国的差距主要体现在哪些方面? 【邢波Eric P. Xing】中国的大数据技术与题目跟进国外趋势还做得不错。但在原创性部分有欠缺。也许由于工程性,技术性上的原创工作通常不吸引眼球且风险极大这样的特点,所以没人愿意啃硬骨头。整体不算太差,但缺少领军人物,和领先的理念。还有在导向上,倾向于显著的效益和快的结果,但对于学术本身的追求不是很强烈。如果效果不是立竿见影,愿意碰的人就少。大部分人都这样,就是趋向于平庸。整个生态系统上看,中国大数据发展水平与欧洲、日本比并不差,公众的认知也热烈。整个环境还蛮好。与中国学生有点像,群体不见得差,但缺少特别杰出的领袖,和有胆识的开拓者。

人工智能的目标没有上限,不应以人脑为模板

【杨静lillian】您说过深度学习只是实现人工智能目标的一种手段,那么在您看来,人工智能的目标到底是什么?抛开《奇点临近》的科学性,您认为机器智能总体超越人类这个目标在2050年前后有可能实现么?或者说在2050年前后,世界的控制权会不会由人工智能主导? 【邢波 Eric P. Xing】人工智能的目标其实是没有上限的。人工智能的目标并不是达到动物或人类本身的智力水平,而是在可严格测量评估的范围内能否达到我们对于具体功能上的期待。例如用多少机器、多长时间能达成多少具体任务?(这里通常不包含抽象,或非客观任务,比如情绪,感情等。)人的智力不好评价,尤其标准、功能、结果及其多元,很多不是人工智能追求的目标。科幻家的浪漫幻想和科学家的严格工作是有区分的。大部分计算机科学家完成的工作可能不那么让人惊叹,但很多任务已经改变世界。例如,飞机自动驾驶装置可能没有人的智能,但它完成飞行的任务,却比人类驾驶员好。 再比如弹钢琴,机器也可以弹钢琴,精确程度肯定超过人。但是否有必要发明机器人代替人弹钢琴来上台表演,或机器人指挥家甚至机器人乐队?从这个角度看,我个人没有动力或必要去发明机器人来弹钢琴,至少我不认为应该去比较机器和人类钢琴家。钢琴大师如霍洛维茨,鲁宾斯坦是不能被机器替代的、比较的,虽然他们也弹错音。一个武术大师,如果现在用枪来和他比武力,把他打死,有意义吗?那么标准是什么?我认为我们应该去想和做一些更有意义和价值的事情。 关于2050年的未来预测,如果非要比较的话,我认为人工智能不会达到超越人类的水平,科学狂人或科幻家也许喜欢这样预测未来,博得眼球,但科学家需要脚踏实地做有意义的工作。所谓奇点是根本不可能的。未来学家这样去臆测也许是他们的工作;政治家、企业家、实践学家向这个方向去推动则是缺乏理性、责任和常识;而科学家和技术人员去应和,鼓吹这些则是动机可疑了? 人工智能脱离人类掌控?这种可能性不能排除。但要是咬文嚼字的话,如果是计算机的超级进步涌现出智能,以至脱离人类掌控而自行其道,那还何谓“人工”?这就变成“自然智能”。我认为“世界的控制权会不会由人工智能主导”这类题目定义就不严肃,无法也无益做科学讨论,也不能被科学预见。

【Ning】能否通俗科普一下机器学习的几个大的技术方向,和它们在实践中可能的应用。 【邢波 Eric P. Xing】很难科普的讲,不使用专业术语。机器学习不过是应用数学方法体系和计算实践的一个结合,包罗万象。比如图模型(深度学习就是其中一种),核(kernel)方法,谱(spectral)方法,贝叶斯方法,非参数方法,优化、稀疏、结构等等。我在CMU的机器学习课和图模型课对此有系统全面的讲解。 机器学习在语音、图形,机器翻译、金融,商业,机器人,自动控制方面有广泛的应用。很多自然科学领域,例如进化分析,用DNA数据找生物的祖先(属于统计遗传的问题),需要建模,做一个算法去推导,数学形式和求解过程与机器学习的方法论没有区别。一个成熟的,优秀的机器学习学者是应被问题、兴趣和结果的价值去激励、推动,而不是画地为牢,被名词所约束。我本人在CMU的团队,就既可以做机器学习核心理论、算法,也做计算机视觉、自然语言处理,社会网络、计算生物学,遗传学等等应用,还做操作系统设计,因为底层的基本法则都是相通的。

【李志飞】大数据,深度学习,高性能计算带来的机器学习红利是不是差不多到头了?学术界有什么新的突破性或潜在突破性的新算法或原理可以把机器学习的实际应用性能再次大幅提升? 【邢波 Eric P. Xing】大数据、深度学习、高性能计算只是接触了机器学习的表层,远远不到收获红利的时候,还要接着往下做。算法的更新和变化还没有深挖,很多潜力,空间还很大。现在还根本没做出像样的东西。另外我要强调,机器学习的所谓红利,远远不仅靠“大数据、深度学习、高性能计算”带来。举个例子,请对比谷歌和百度的搜索质量(即使都用中文),我想即使百度自己的搜索团队也清楚要靠什么来追赶谷歌。

【Ning】世界各国在机器学习方面的研究实力如何?从科普的角度来看,人的智能和人工智能是在两个平行的世界发展么? 【邢波 Eric P. Xing】不太愿意评价同行的水平。人的智能和人工智能可以平行,也可以交互。

【杨静lillian】您既是计算机专家,还是生物学博士,在您看来,如果以未来世界整体的智能水平作为标准,是基因工程突破的可能性大,还是人工智能领域大,为什么? 【邢波 Eric P. Xing】基因工程其实突破很多。在美国和全球转基因的食品也有很多。胰岛素等药物也是通过转基因菌株来生产,而不是化学合成。诊断胎儿遗传缺陷的主要手段也基于基因工程技术。但是舆论风向在变,也不理性。例如我小时候读的《小灵通看未来》里,“大瓜子”等神奇食品现在已经通过基因技术实现。从技术上看,我们已经实现了这个需要,但公众是否接受,是个问题。科学家要对自己的责任有所界定。例如造出原子弹,科学家负责设计制造,但怎么用是社会的事。 人工智能领域也已经有很多应用型的成果,但也还有很大空间。人工智能就是要去达到功能性的目标,有很多事情可以用它去达成,但这里不见得包括感情思考。人的乐趣就是感情和思考,如果让机器代替人思考,我认为没有这个需要。 靠基因工程提升人的智能基本不可能,人的成就也未必与基因完全相关,例如冯.诺依曼,很大程度是后天环境教育形成的。基因只是必要条件,而非充分条件。作为一个生物学博士,我反对用基因工程改变人的智能的做法,认为这很邪恶。科学家应该对自然法则或上帝有所敬畏。在西方,优生学是不能提的,因为它违反了人本主义的原则和人文人权的理念。我个人认为这个题目在科学道德上越界了,是不能想象的。

【杨静lillian】您说过美国的大脑计划雷声大雨点小,请问欧盟的大脑工程您怎么看,会对人工智能发展起到促动作用么?或者说,人工智能研究是否应以人的大脑为模型? 【邢波 Eric P. Xing】欧洲大脑工程的争议很大,包括目标和经费分配。但这个目标也提升了社会和公众的对于科学的关注,工程的目的不用过于纠结。这个项目就是启发式的,培养人才,培养科学实力的种子项目。 大脑工程,无论欧洲和美国,对人工智能发展没有直接的促进作用。以仿生学来解释人工智能工程上的进步,至少在学术上不是一个精确和可执行的手段,甚至是歧路。只是用于教育公众,或者通俗解释比较艰深的科学原则。 人工智能不必也不应以人脑为模型。就像飞机和鸟的问题,两者原理手段完全不同。人工智能应该有自己的解决办法,为什么要用人脑的模型来限制学科的发展?其实有无数种路径来解决问题,为什么只用人脑这一种模板?

机器学习领域应多元探索,巨大潜力与空间待挖掘

【李志飞】更正一下我的问题: 现有的机器学习算法如深度学习在利用大数据和高性能计算所带来的红利是不是遇到瓶颈了?(至少我所在的机器翻译领域是这样) 接下来会有什么新机器学习算法或原理会把大数据和高性能计算再次充分利用以大幅提升应用的性能?我觉得如果机器学习领域想在应用领域如机器翻译产生更大的影响,需要有更多人做更多对应用领域的教育和培训,或者是自己跨界直接把理论研究跟应用实践结合起来 【邢波 Eric P. Xing】机器学习的算法有几百种,但是目前在深度学习领域基本没有被应用。尝试的空间还很大,而且无需局限在深度学习下。一方面机器学习学者需要跨出自己的圈子去接触实际,另一方面应用人士也要积极学习,掌握使用发展新理论。

【杨静lillian】您认为谷歌是全球最具领导性的人工智能公司么?您预测人工智能技术会在哪几个领域得到最广泛的应用?人工智能产业会像互联网领域一样出现垄断么? 【邢波 Eric P. Xing】谷歌是最具有领导性的IT公司。世界上没有人工智能公司,公司不能用技术手段或目标定义名称和性质。人工智能是一个目标,而不是具体的一些手段。所以有一些界定是不严肃的。关于应用领域前面已经谈过了。

【杨静lillian】您曾经比喻,中国的人工智能领域里,有皇帝和大臣,您怎么判断中国人工智能产业的发展水平和发展方向?最想提出的忠告是什么?

【邢波 Eric P. Xing】中国整个IT领域,以至科学界,应该百花齐放,有的观点占领了过多的话语权,别的观点就得不到尊重。目前业界形成一边倒的局面,媒体的极化现象比较严重。建议媒体应该平衡报道。中国目前深度学习话语权比较大,没人敢批评,或者其他研究领域的空间被压缩。这种研究空间的压缩对机器学习整个领域的发展是有害的。学界也存在有人山中装虎称王,山外实际是猫的现象。坦率的说,目前中国国内还没有世界上有卓越影响的重量级人工智能学者,和数据科学学者。中国需要更多说实话,戳皇帝新衣的小孩,而不是吹捧的大臣、百姓和裸奔的皇帝。不要等到潮水退去,才让大家看到谁在裸奔。 现在一些舆论以深度学习绑架整个机器学习和人工智能。这种对深度学习或以前以后某一种方法的盲目追捧,到处套用,甚至上升到公司、国家战略,而不是低调认真研究其原理、算法、适用性和其它方法,将很快造成这类方法再次冷却和空洞化,对这些方法本身有害。行外人物、媒体、走穴者(比如最近在太庙高谈阔论之流)对此的忽悠是很不负责的,因为他们到时可以套了钱、名,轻松转身,而研发人员投入的时间、精力和机会成本他们是不会在乎的。美国NSF、军方和非企业研究机构与神经计算保持距离是有深刻科学原因的,而国内从民到官这样的发烧,还什么弯道超车,非常令人怀疑后面的动机和推手。

【杨静lillian】确实如您所说,现在大多数中国企业或学术机构,被一个大问题困扰。就是缺乏大数据源,或者缺乏大数据分析工具,那么怎样才能搭上大数据的时代列车呢? 【邢波 Eric P. Xing】首先我没有那样说过,我的看法其实相反。即使给那些企业提供了大数据,他们真会玩么?这有点叶公好龙,作为一个严肃的研究,应该把工具造出来。得先有好的技术,别人才会把数据提供给你。有时小数据都没做好,又开始要大数据,没人会给。可以用模拟,更可以自己写爬网器(crawler)自己在网上抓。例如我们的实验室,学生就可以自己去找数据源。研究者的心态有时不正确,好像社会都需要供给他,自己戴白手套。其实人人都可以搭上“大数据”这个列车,但需要自己去勤奋积极努力。

【杨静lillian】Petuum开源技术系统会成为一种大数据处理的有效工具么?可以取代Spark? 【邢波 Eric P. Xing】希望如此。更客观地说,不是取代。是解决不同的问题,有很好的共生、互补关系。

中国学术界的原创性待提高,缺乏灯塔型领军人物

【刘成林】@杨静lillian问题提的好!期待详细报道。另外我加一个问题,请Eric给中国人工智能学术界提点建议,如何选择研究课题和如何深入下去。 【邢波 Eric P. Xing】希望中国人工智能学术界要对机器学习、统计学习的大局有所掌控,全面判断和寻找,尚未解决的难题。这需要很多人静下来,慢下来,多读,多想。而不是跟风或被热点裹挟。得有足够的耐心,屏蔽环境的影响和压力。在技术上得重视原创性,如果只把学术看成是一个短时期的比赛,价值就不大。得找有相当难度,而自己有独特资源的方向,就保证了思想的原创性和资源的独特性。要分析清楚自己的优势。 例如我们做的Petuum,很多人就不敢碰。我们开始时甚至都不懂操作系统,从头学;我们放缓了步子,两年近十人只出两篇文章。但不尝试怎么知道?得给自己空间。

【张宝峰】邢老师提到过在机器学习领域,美国可以分成几个大的分支,比如Jordan 算一个,能否再详细的阐述还有哪些其他分支和流派? 【邢波 Eric P. Xing】这算八卦。原来有几个流派,但现在流派的界限已经非常模糊了。

【刘挺-哈工大】您认为哪些方向或组织有希望出现领军人物? 【邢波 Eric P. Xing】国内的同行思路有些短板,所以研究领域比较割裂。上层不够高,下层也不够深,横向也不宽,因此扎根不够,影响有限。所以比较缺憾,体现为很多割裂的领域。 在中国的企业界和学术界哪里会出现领军人物?这个问题我认为:对什么叫“领军人物”国内的同行的定义还相当肤浅,功利。除了商业上的成功,或者学术上获奖,这些显性成就,还需要有另外的维度。例如从另外一个角度,具有个人魅力,他的思想、理论、人格被很多人追随和推崇的,有众多门生甚至超越自己的,就没有。中国的研究者不善于建立自己的体系,去打入一个未知的境界,做一个灯塔型的人物。这种人物在中国特别少,基本上没有。 在美国M.Jordan就是这样的人物,就有灯塔型的效应,被众人或学术界效法,敬佩,和追随,包括他的反对者。他也不是中国最典型的最年轻教授等成功人物,而是大器晚成,到了45岁才开始发扬光大,上新台阶。但他的做为人的魅力(会五国语言,年轻时弹琴挣钱,平时风趣博学);他的勤奋自律(到Berkeley后正教授了还和我们一起在课堂听课,从头学统计,优化,到现在还天天读文献);他的工作和生活的平衡(现在自己组乐队,和孩子玩儿);他的众多学生的成就(很多方向和他大不相同,甚至相对);他的严谨,严肃的学风;和他的洞察力。这些都是除了学术成就之外他成为领军人物的要素。我们国内知识分子接近这个境界的太少了。不要说学术上的差距,就连上餐桌品酒、懂菜,说话写作遣词造句的造诣都差不少。所以,先不要急出领军人物;先从文化上培育土壤,培育认真、一丝不苟的习惯和精神,培育热爱教学、热爱学生的责任;培育洁身自好、玉树临风的气质;注重细节、小节、修养,再由小至大、由士及贤、由贤入圣。在这个境界上,学问就变成一种乐趣了,就可以做出彩了。

【张宝峰】欢迎回国,把Pleuum变成实际产业标准。 【邢波 Eric P. Xing】不是没有可能,但也需要好的平台和环境、机缘。这次回国参会,很兴奋的是,学术界和产业界都对机器学习的技术有很大的热情,也有信念去获取成功,相当积极。我个人的观点,通过交流,收获很大。期望这种交流继续,也期待国内的学界、媒体、企业能够共同促进产业生态的发展,利益多样化。可以是金钱的成功,也可以是原创性的增长。而不是被某一个目标来一统天下。 如果回国发展,应该有更多商业上的机会。但是国内的起点低,有些规则两国不一样。现在人生的目标不是钱,而是对乐趣的满足,以及服务社会。实现自我的价值,也让家人,朋友,学生,师长,同事开心。 下个月还有机会回国,到时也期待与大家继续交流互动。非常感谢@杨静lillian 提供这个和大家交流的机会。也钦佩她专业敬业。这次结识很多朋友,后会有期! | |

The Wall Street Journal吴恩达专访

作者 AbelJiang | 2014-12-08 13:47 | 类型 Deep Learning, 机器学习, 行业动感 | Comments Off

|

原文转载自:http://blogs.wsj.com Six months ago, Chinese Internet-search giant Baidu signaled its ambitions to innovate by opening an artificial-intelligence center in Silicon Valley, in Google’s backyard. To drive home the point, Baidu hired Stanford researcher Andrew Ng, the founder of Google’s artificial-intelligence effort, to head it. Ng is a leading voice in “deep learning,” a branch of artificial intelligence in which scientists try to get computers to “learn” for themselves by processing massive amounts of data. He was part of a team that in 2012 famously taught a network of computers to recognize cats after being shown millions of photos. On a practical level, the field helps computers better recognize spoken words, text and shapes, providing users with better Web searches, suggested photo tags or communication with virtual assistants like Apple’s Siri. In an interview with The Wall Street Journal, Ng discussed his team’s progress, the quirks of Chinese Web-search queries, the challenges of driverless cars and what it’s like to work for Baidu. Edited excerpts follow: WSJ: In May, we wrote about Baidu’s plans to invest $300 million in this facility and hire almost 200 employees. How’s that coming along? Ng: We’re on track to close out the year with 96 people in this office, employees plus contractors. We’re still doing the 2015 planning, but I think we’ll quite likely double again in 2015. We’re creating models much faster than I have before so that’s been really nice. Our machine-learning team has been developing a few ideas, looking a lot at speech recognition, also looking a bit at computer vision. WSJ: Are there examples of the team’s work on speech recognition and computer vision? Ng: Baidu’s performance at speech recognition has already improved substantially in the past year because of deep learning. About 10% of our web search queries today come in through voice search. Large parts of China are still a developing economy. If you’re illiterate, you can’t type, so enabling users to speak to us is critical for helping them find information. In China, some users are less sophisticated, and you get queries that you just wouldn’t get in the United States. For example, we get queries like, “Hi Baidu, how are you? I ate noodles at a corner store last week and they were delicious. Do you think they’re on sale this weekend?” That’s the query. WSJ: You can process that? Ng: If they speak clearly, we can do the transcription fairly well and then I think we make a good attempt at answering. Honestly, the funniest ones are schoolchildren asking questions like: “Two trains leave at 5 o’ clock, one from …” That one we’ve made a smaller investment in, dealing with the children’s homework. In China, a lot of users’ first computational device is their smartphone, they’ve never owned a laptop, never owned a PC. It’s a challenge and an opportunity. WSJ: You have the Baidu Eye, a head-mounted device similar to Google Glass. How is that project going? Ng: Baidu Eye is not a product, it’s a research exploration. It might be more likely that we’ll find one or two verticals where it adds a lot of value and we’d recommend you wear Baidu Eye when you engage in certain activities, such as shopping or visiting museums. Building something that works for everything 24/7 – that is challenging. WSJ: What about the self-driving car project? We know Baidu has partnered with BMW on that. Ng: That’s another research exploration. Building self-driving cars is really hard. I think making it achieve high levels of safety is challenging. It’s a relatively early project. Building something that is safe enough to drive hundreds of thousands of miles, including roads that you haven’t seen before, roads that you don’t have a map of, roads where someone might have started to do construction just 10 minutes ago, that is hard. WSJ: How does working at Baidu compare to your experience at Google? Ng: Google is a great company, I don’t want to compare against Google specifically but I can speak about Baidu. Baidu is an incredibly nimble company. Stuff just moves, decisions get made incredibly quickly. There’s a willingness to try things out to see if they work. I think that’s why Baidu, as far as I can tell, has shipped more deep-learning products than any other company, including things at the heart of our business model. Our advertising today is powered by deep learning. WSJ: Who’s at the forefront of deep learning? Ng: There are a lot of deep-learning startups. Unfortunately, deep learning is so hot today that there are startups that call themselves deep learning using a somewhat generous interpretation. It’s creating tons of value for users and for companies, but there’s also a lot of hype. We tend to say deep learning is loosely a simulation of the brain. That sound bite is so easy for all of us to use that it sometimes causes people to over-extrapolate to what deep learning is. The reality is it’s really very different than the brain. We barely (even) know what the human brain does. WSJ: For all of Baidu’s achievements, it still has to operate within China’s constraints. How do you see your work and whether its potential might be limited? Ng: Obviously, before I joined Baidu this was something I thought about carefully. I think that today, Baidu has done more than any other organization to open the information horizon of the Chinese people. When Baidu operates in China, we obey Chinese law. When we operate in Brazil, which we also do, we obey Brazil’s law. When we operate in the U.S. and have an office here, we obey U.S. law. When a user searches on Baidu, it’s clear that they would like to see a full set of results. I’m comfortable with what Baidu is doing today and I’m excited to continue to improve service to users in China and worldwide. | |

Spark的现状与未来发展

作者 陈怀临 | 2014-12-02 10:17 | 类型 Deep Learning, 机器学习 | 1条用户评论 »

|

[转载文章] Spark的发展对于一个具有相当技术门槛与复杂度的平台,Spark从诞生到正式版本的成熟,经历的时间如此之短,让人感到惊诧。2009年,Spark诞生于伯克利大学AMPLab,最开初属于伯克利大学的研究性项目。它于2010年正式开源,并于2013年成为了Aparch基金项目,并于2014年成为Aparch基金的顶级项目,整个过程不到五年时间。

由于Spark出自伯克利大学,使其在整个发展过程中都烙上了学术研究的标记,对于一个在数据科学领域的平台而言,这也是题中应有之义,它甚至决定了Spark的发展动力。Spark的核心RDD(resilient distributed datasets),以及流处理,SQL智能分析,机器学习等功能,都脱胎于学术研究论文,如下所示:

Discretized Streams: Fault-Tolerant Streaming Computation at Scale. Matei Zaharia, Tathagata Das, Haoyuan Li, Timothy Hunter, Scott Shenker, Ion Stoica. SOSP 2013. November 2013.

Shark: SQL and Rich Analytics at Scale. Reynold Xin, Joshua Rosen, Matei Zaharia, Michael J. Franklin, Scott Shenker, Ion Stoica. SIGMOD 2013. June 2013.

Discretized Streams: An Efficient and Fault-Tolerant Model for Stream Processing on Large Clusters. Matei Zaharia, Tathagata Das, Haoyuan Li, Scott Shenker, Ion Stoica. HotCloud 2012. June 2012.

Shark: Fast Data Analysis Using Coarse-grained Distributed Memory (demo). Cliff Engle, Antonio Lupher, Reynold Xin, Matei Zaharia, Haoyuan Li, Scott Shenker, Ion Stoica. SIGMOD 2012. May 2012. Best Demo Award.

Resilient Distributed Datasets: A Fault-Tolerant Abstraction for In-Memory Cluster Computing. Matei Zaharia, Mosharaf Chowdhury, Tathagata Das, Ankur Dave, Justin Ma, Murphy McCauley, Michael J. Franklin, Scott Shenker, Ion Stoica. NSDI 2012. April 2012. Best Paper Award and Honorable Mention for Community Award.

Spark: Cluster Computing with Working Sets. Matei Zaharia, Mosharaf Chowdhury, Michael J. Franklin, Scott Shenker, Ion Stoica. HotCloud 2010. June 2010.

在大数据领域,只有深挖数据科学领域,走在学术前沿,才能在底层算法和模型方面走在前面,从而占据领先地位。Spark的这种学术基因,使得它从一开始就在大数据领域建立了一定优势。无论是性能,还是方案的统一性,对比传统的Hadoop,优势都非常明显。Spark提供的基于RDD的一体化解决方案,将MapReduce、Streaming、SQL、Machine Learning、Graph Processing等模型统一到一个平台下,并以一致的API公开,并提供相同的部署方案,使得Spark的工程应用领域变得更加广泛。

Spark的代码活跃度

从Spark的版本演化看,足以说明这个平台旺盛的生命力以及社区的活跃度。尤其在2013年来,Spark进入了一个高速发展期,代码库提交与社区活跃度都有显著增长。以活跃度论,Spark在所有Aparch基金会开源项目中,位列前三。相较于其他大数据平台或框架而言,Spark的代码库最为活跃,如下图所示:

从2013年6月到2014年6月,参与贡献的开发人员从原来的68位增长到255位,参与贡献的公司也从17家上升到50家。在这50家公司中,有来自中国的阿里、百度、网易、腾讯、搜狐等公司。当然,代码库的代码行也从原来的63,000行增加到175,000行。下图为截止2014年Spark代码贡献者每个月的增长曲线:

下图则显示了自从Spark将其代码部署到Github之后的提交数据,一共有8471次提交,11个分支,25次发布,326位代码贡献者。

目前的Spark版本为1.1.0。在该版本的代码贡献者列表中,出现了数十位国内程序员的身影。这些贡献者的多数工作主要集中在Bug Fix上,甚至包括Example的Bug Fix。由于1.1.0版本极大地增强了Spark SQL和MLib的功能,因此有部分贡献都集中在SQL和MLib的特性实现上。下图是Spark Master分支上最近发生的仍然处于Open状态的Pull Request:

可以看出,由于Spark仍然比较年轻,当运用到生产上时,可能发现一些小缺陷。而在代码整洁度方面,也随时在对代码进行着重构。例如,淘宝技术部在2013年就开始尝试将Spark on Yarn应用到生产环境上。他们在执行数据分析作业过程中,先后发现了DAGSchedular的内存泄露,不匹配的作业结束状态等缺陷,从而为Spark库贡献了几个比较重要的Pull Request。具体内容可以查看淘宝技术部的博客文章:《Spark on Yarn:几个关键Pull Request(http://rdc.taobao.org/?p=525)》。

| |

机器学习应用–深度学习“看风水”?

作者 AbelJiang | 2014-12-01 13:53 | 类型 Deep Learning, 机器学习 | Comments Off

|

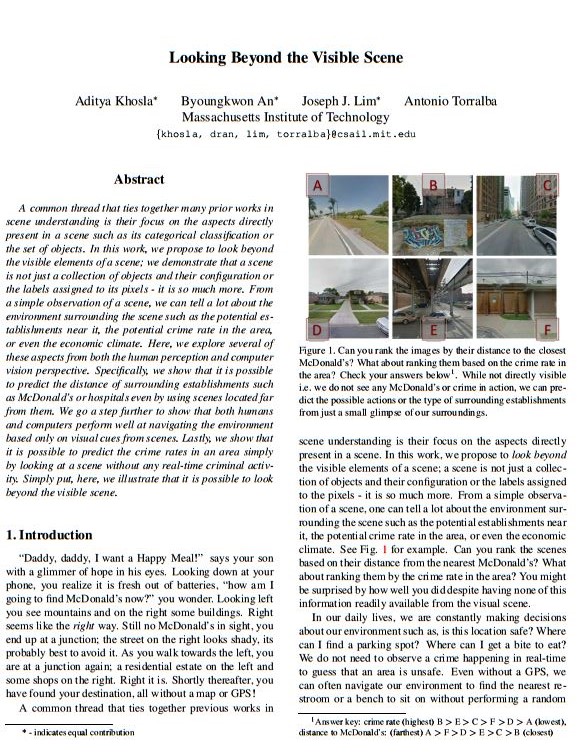

人类有种很奇妙的能力,通过建筑周边的景象,能大致推断某个地方是否安全,哪里可能有停车的地方,哪里可能有加油站。 这种决策不仅仅要求你看到某个景象,还需要一系列复杂的对于景象的理解和实时判断。那么问题来了–计算机能干这活么?如果能,计算机“看风水”有没有人看的准呢? MIT的CSAIL给出的答案是yes and sometimes。研究人员提出的算法能够观察一组图片并给出比人更为准确的判断。这些判断包括诸如某个地方犯罪率是不是高一些,某个地方是不是离麦当劳近一些此类的问题。 为了开发这个算法,研究团队用了来自八个美国主要城市的,嵌入GPS数据(包括犯罪率和麦当劳位置)的八百多张Google images来训练计算机。计算机利用深度学习技术自主整合图片包含的各种信息,包括你经常注意到的麦当劳周围的景物以及你不经常发现的一些景物信息。 研究人员已经将论文发表在了今年的CVPR会议上。研究者称,这项研究用途很广,比如将其用于导航软件规避高犯罪区域,或是帮助麦当劳确定其开设连锁店位置。 Reference: | |

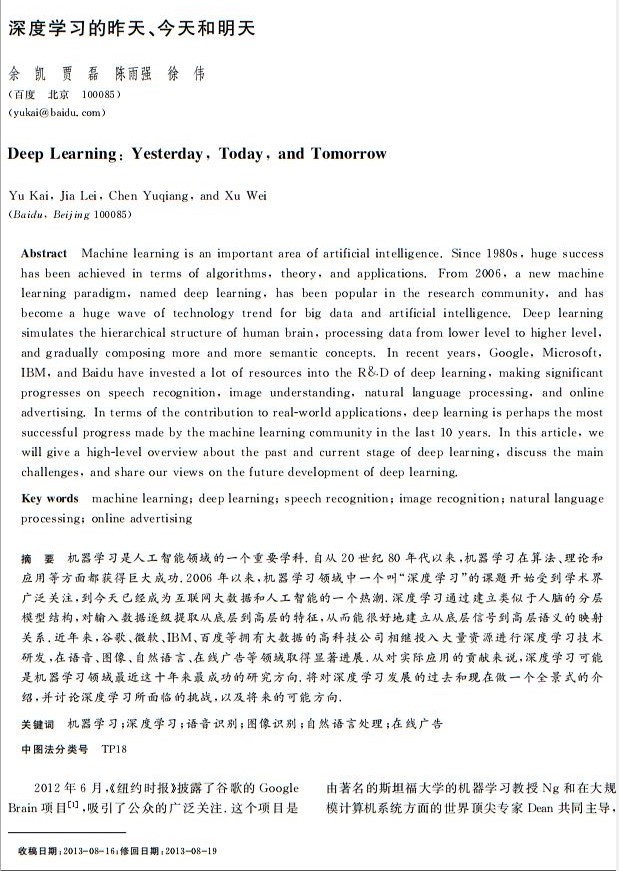

深度学习的昨天、今天和明天

作者 AbelJiang | 2014-11-11 22:26 | 类型 Deep Learning, 机器学习 | Comments Off

往事如烟--《扒1扒神经网络的神经大神们》

作者 陈怀临 | 2014-10-06 10:42 | 类型 Deep Learning, 机器学习 | Comments Off

|

作者:Nick Zhang 。

自图灵提出“机器与智能”,一直就有两派观点,一派认为实现人工智能必须用逻辑和符号系统,这一派看问题是自顶向下的;还有一派认为通过仿造大脑可以达到人工智能,这一派是自底向上的,他们认定如果能造一台机器,模拟大脑中的神经网络,这台机器就有智能了。前一派,我想用“想啥来啥”来形容;后一派就称之为“吃啥补啥”,估计他们的思想来源于中国古代的原始思维,套一句庸俗的哲学词,前者偏唯心,后者偏唯物。这两派一直是人工智能领域里两个阶级、两条路线的斗争,这斗争有时还你死我活。

1949年,神经心理学家Hebb出版《行为组织学》(Organization of Behavior),在该书中,Hebb提出了被后人称为“Hebb规则”的学习机制。这个规则认为如果两个细胞总是同时激活的话,它们之间就有某种关联,同时激活的概率越高,关联度也越高。换句话说,就是“吃啥补啥”。2000年诺贝尔医学奖得主肯德尔(Eric Kandel)的动物实验也证实了Hebb规则。后来的各种无监督机器学习算法或多或少都是Hebb规则的变种。

明斯基是人工智能的奠基人之一,是达特茅斯会议的组织者。明斯基在一次会议上和罗森布拉特大吵,他认为神经网络不能解决人工智能的问题。随后,明斯基和麻省理工学院的另一位教授佩普特合作,企图从理论上证明他们的观点。他们合作的成果就是那本影响巨大、“是也非也”的书:《感知机:计算几何学》(Perceptrons: An Introduction to Computational Geometry)。在书中,明斯基和佩普特证明单层神经网络不能解决XOR(异或)问题。异或是一个基本逻辑问题,如果这个问题都解决不了,那神经网络的计算能力实在有限。其实罗森布拉特也已猜到“感知机”可能存在限制,特别是在“符号处理”方面,并以他神经心理学家的经验指出,某些大脑受到伤害的人也不能处理符号。但“感知机”的缺陷被明斯基以一种敌意的方式呈现,当时对罗森布拉特是致命打击。所有原来的政府资助机构也逐渐停止对神经网络的研究。1971年,罗森布拉特四十三岁生日那天,在划船时淹死。很多人认为他是自杀。王国维沉湖时遗言“经此世变,义无再辱”,在罗森布拉特,我猜“辱”是明斯基的书,“世变”是随后“神经网络”学科的消沉。不同的是,王静安谓之“世变”是历史潮流,但神经网络学科十年后会逆袭。 表面是科学,但有证据表明明斯基和罗森布拉特以前就有瓜葛。他们是中学同学。布朗克斯(Bronx)科学高中大概是全世界最好的高中,毕业生里出过八个诺贝尔奖、六个普利策奖。远的不说,明斯基是1944年毕业生,乔姆斯基是1945年毕业生,而罗森布拉特是1946年毕业生。美国高中学制四年,明斯基和罗森布拉特至少有两年重叠,而且彼此认识,互相嫉妒。1956年的达特茅斯会议定义了“人工智能”这个词,会议的组织者包括明斯基、麦卡锡和香农等,参会者还有司马贺,纽威尔等。这个会议在定义“人工智能”领域时只是提到了神经网络。那时明斯基是神经网络的支持者。他1954年在普林斯顿的博士论文题目是“神经-模拟强化系统的理论,及其在大脑模型问题上的应用”(Theory of Neural-Analog Reinforcement Systems and its Application to the Brain-Model Problem),实际是一篇关于神经网络的论文。他晚年接受采访时开玩笑说,那篇三百多页的博士论文从来没正式发表过,大概只印了三本,他自己也记不清内容了。貌似他想极力开脱自己和神经网络学科的千丝万缕的关系。达特茅斯会议的主题并不是神经网络,而是后来被纽维尔和司马贺称为“物理符号系统”的东西,也就是说达特茅斯会议,“想啥来啥”派是主要基调。 罗森布拉特被比他大一岁的明斯基妒忌是自然的。工作上,明斯基所负责的麻省理工学院的人工智能实验室也在向国防部和海军申请经费。大多数的圈内科学家,对罗森布拉特突然被塑造的明星范儿很反感。明斯基早期也是“吃啥补啥”派出身,但此时已经改为“想啥来啥”派了。由于他和佩普特对感知机的批判,俩人后来被“吃啥补啥”派称为“魔鬼搭档”。其实明斯基认识佩普特结识还是通过麦卡洛克的介绍,历史真是纠结。被称“魔鬼”是因为《感知机》第一版有言:“罗森布拉特的论文大多没有科学价值。”这话跳步确实有点大,但罗森布拉特人缘不好,没有得到同行的支持。 比罗森布拉特小一岁的维德罗(Widrow)是斯坦福大学教授,在罗森布拉特刚提出“感知机”时,就提出了Adaline可适应性算法。Adaline和感知机很相似,也是机器学习的鼻祖模型之一。罗森布拉特享受盛誉时,维德罗也沾了光,但在罗森布拉特死后,他却并没有被非难。维德罗在几十年后回忆说,那是因为他后来主要在电机系(EE)做集成电路的工作,而不是在计算机系里从事派系繁杂的人工智能研究,圈子不同,老死不相往来。

在信息科学和神经科学的结合部的失败,并没有影响到神经生物学内部。哈佛神经生物学家胡贝尔(Hubel)和威瑟尔(Wiesel)对视网膜和视皮层(visual cortex)中神经细胞的信息处理模式做了深入研究,他们为此获得1981年的诺贝尔医学奖。随后,麻省理工学院英年早逝的大卫·马尔(Marr)为视觉信息处理建立数学模型,影响了后来连接主义的运动。威瑟尔后来离开哈佛去了洛克菲勒大学。1991年洛克菲勒大学时任校长大卫·巴尔的摩出了学术丑闻被迫辞职后,威瑟尔出任洛克菲勒校长,为把那所学校建成生物学的重镇做出贡献。 1974年,哈佛的一篇博士论文证明了在神经网络多加一层,并且利用“后向传播”(Back-propagation)学习方法,可以解决XOR问题。这篇论文的作者是沃波斯(Werbos),他后来得到了IEEE神经网络学会的先驱奖。沃波斯这篇文章刚发表时并没引起多少重视,那时正是神经网络研究的低谷,文章不合时宜。 神经网络在1980年代的复兴归功于物理学家霍普菲尔德(Hopfield)。1982年,那时在加州理工担任生物物理教授的霍普菲尔德,提出了一种新的神经网络,可以解决一大类模式识别问题,还可以给出一类组合优化问题的近似解。这种神经网络模型后被称为霍普菲尔德网络。1984年,霍普菲尔德用模拟集成电路实现了自己提出的模型。霍老也培养了一批后起之秀,包括现在在生物学重镇Salk研究所担任计算神经生物学实验室主任的Terry Sejnowski。霍老后转往普林斯顿担任分子生物学教授,现已退休。霍普菲尔德模型的提出振奋了神经网络领域。一帮早期神经网络研究的幸存者,在生物学家克里克(Crick,对,就是发明DNA双螺旋的那位诺贝尔奖得主)和认知科学大佬唐·诺曼(Don Norman)的鼓励下,以加州大学圣地亚哥分校为基地,开始了“连接主义”(Connectionism)运动,这个运动的领导者是两位心理学家鲁梅尔哈特(Rumelhart)和麦克利兰德(McLelland),外加一位计算机科学家辛顿(Geoffrey Hinton)。 | |

Andrew Ng谈Deep Learning

作者 陈怀临 | 2014-08-04 09:05 | 类型 Deep Learning, 大数据, 机器学习 | Comments Off

|

《程序员》:Amara法则说,“我们倾向于高估科技的短期影响力,而又低估其长期影响力。”在你看来,Deep Learning的短期和长期影响分别是什么?历史上,我们曾对实现人工智能有过错误估计,对于Deep Learning的前景,人们是否过于乐观?

Andrew Ng:我对Deep Learning的前景很乐观,它的价值在过去几年已得到印证,未来我们还会沿着这个方向继续努力。语音识别、计算机视觉都将获得长足进步,数据与科技的碰撞,会让这一切变得更具价值。在短期,我们会看到身边的产品变得更好;而长期,它有潜力改变我们与计算机的交互方式,并凭借它创造新的产品和服务。

不过围绕Deep Learning,我也看到存在着某种程度的夸大,这是一种不健康的氛围。它不单出现于媒体的字里行间,也存在于一些研究者之中。将Deep Learning描绘成对人脑的模拟,这种说法颇具吸引力,但却是过于简化的模仿,它距离真正的AI或人们所谓的“奇点”还相当遥远。目前这项技术主要是从海量数据当中学习,理解数据,这也是现今有关Deep Learning技术研究和产品发展的驱动力。而具备与人的能力相匹配的AI需要无所不包,例如人类拥有丰富的感情、不同的动机,以及同感能力。这些都是当下Deep Learning研究尚未涉及的。

《程序员》:关于神经网络的研究,在很多方面依靠生物学、神经科学等领域。在你看来,Deep Learning的模型是否已经完善?若没有,目前最大的缺陷或困难在于何处?

Andrew Ng:Deep Learning模型尚未完善,主要存在两项挑战。一项是可扩展性,我们坐拥海量数据,却难以建造计算能力足够强大的计算机系统,处理这些数据。我青睐百度的原因之一,即在于它拥有复杂而强大的海量数据处理基础架构,但对Deep Learning来说,问题尚未得到解决。另一项挑战在于算法,我们也不知道恰当的算法是什么。从这两点看,尽管我们已取得了不小的进步,但前路依然漫漫。

《程序员》:为了开发智能机器,许多年前,Daniel Hillis和他的Thinking Machines曾尝试突破von Neumann架构,你觉得当今的硬件是否是实现智能机器的最好选择?如果不是,当前的计算机架构有哪些限制,我们需要做哪方面的突破?

Andrew Ng:这是一个有趣的话题。我们尚不知道怎样的硬件架构是智能机器的最佳选择,因而更需要拥有灵活性,快速尝试不同的算法。在这方面,GPU相对易于编程,因而可以高效地尝试不同的算法。作为对比,ASIC(专用集成电路)的运行速度比GPU更快,但开发适合Deep Learning的ASIC难度高、周期长,在漫长的研发过程中,很可能我们早已发现了新算法。

GPU与CPU结合是目前的首选硬件平台,不过随着技术的进一步成熟,这种现状有可能发生改观。例如,目前已有几家初创公司正在研发专门用于Deep Learning的硬件系统。

《程序员》:有一种说法是,对人脑机制理解的缺乏是我们开发智能机器的最大限制之一,在这个存在许多假设和未知的前沿领域进行研究,你怎样判断自己研究的方向和做出的各种选择是否正确?

Andrew Ng:诚然,神经科学尚未揭开人脑的运作机制,是对这项研究的一种制约。但如今我们尝试的算法,大多只是粗略地基于神经科学研究的统计阐释,这些研究启迪我们的灵感,鼓励我们尝试新算法。但现实中,我们更主要地依据算法真实的运行效果进行评判,假如一味追求模拟神经的运作方式,不一定能带来最优的结果。有时我们偏重神经科学原理,例如某些模拟大脑局部的算法;但更多时候,性能是准绳。若按比例划分,前者大约只占2%,后者则占据98%。

因为我们不知道何种算法最优,所以才不断尝试,衡量是否取得进步的方式之一(并非唯一方式),是观察新算法能否在应用中表现得更好,例如Web和图像搜索结果是否更准确,或者语音识别的正确率更高。假如回望五年,你就会发现,那时我们曾认为颇有前景的算法,如今已然被抛弃。这些年,我们有规律地,甚至偶然地发现一些新算法,推动着这个领域持续前进。

《程序员》:关于Deep Learning的原理,已有许多人知晓。为了做出一流研究和应用,对于研究者来说,决胜的关键因素是什么?为何如今只有少数几人,成为这个领域的顶尖科学家?

Andrew Ng:关于决定因素,我认为有三点最为关键。

首先是数据,对于解决某些领域的问题,获取数据并非轻而易举;其次是计算基础架构工具,包括计算机硬件和软件;最后是这个领域的工程师培养,无论在斯坦福还是百度,我都对如何快速训练工程师从事Deep Learning研究,成为这个领域的专家思索了很长时间。幸运的是,我从Coursera和大学的教学经历中获益良多。创新往往来自多个观念的整合,源于一整支研究团队,而非单独一个人。

从事Deep Learning研究的一个不利因素在于,这还是一个技术快速发展的年轻领域,许多知识并非依靠阅读论文便能获得。那些关键知识,往往只存在于顶尖科学家的头脑中,这些专家彼此相识,信息相互共享,却不为外人所知。另外一些时候,这群顶尖科学家也不能确定自己的灵感源于何处,如何向其他人解释。但我相信,越来越多的知识会传递给普通开发者;在百度,我也正努力寻找方法,将自己的灵感和直觉高效地传授给其他研究者。尽管我们已有这方面的教程,但需要改进之处仍有很多。

此外,许多顶尖实验室的迭代速度都非常快,而Deep Learning算法复杂,计算代价很高,这些实验室都拥有优秀的工具与之配合,从快速迭代中学习进步。

《程序员》:十年前,Jeff Hawkins在《On Intelligence》中已经向普通人描述了机器与智能之间的关系,这些描述与我们现在看到的Deep Learning似乎非常相似。在这最近的十年中,我们新学到了什么?

Andrew Ng:包括我在内,Jeff Hawkins的作品启发了许多AI研究者,多年以前,我个人还曾是Hawkins这家公司的技术顾问之一。但在现实中,每个人的实现细节和算法迥异,与这本书其实颇有不同。例如在书中,Hawkins极为强调与时间相关的临时数据的重要性,而在Deep Learning中,虽然用到了临时数据,但远没有那重要,另外网络的架构也大不相同。在最近十年中,我们认识到了可扩展的重要性,另外我们还找到了进行非监督式学习更好的方式。

关于工作选择

《程序员》:为什么选择百度开展你的工作,它的哪些特点,是你觉得其他公司所不具备的?

Andrew Ng:我喜欢在任务高度驱动的环境下工作,通常我是这些任务的发起者。我为能更好地发展AI,令互联网上的每个人都能从中受益而兴奋。

几个月前,我仔细评估了几个选项后,决定加入百度。一方面在于王劲团队打造了非常优秀的基础设施,同时百度还拥有庞大的数据。另一方面,我为百度的灵活快速所吸引,当我的朋友余凯和徐伟决定搭建GPU集群,马上就得到了实现,此外没有任何一家公司推出Deep Learning产品的速度快过这里,而且还是应用在互联网广告这种核心业务上。对于Deep Learning这样未知因素很多的技术来说,灵活性至关重要。我还发现北京的互联网公司讨论的往往是日活跃用户,而在硅谷则是月活跃用户,或许这也可以作为灵活性的一个注解。

还有一点我很少谈起,却非常重要——因为这里的人。与他们相处,我感到非常愉快。当我开始在百度工作后,妻子Carol曾对我说,她从未见过我如此努力,却又如此开心。

《程序员》:你在百度的研究产品和成果能为外界带来什么(例如是未来否有可能将你的成果共享给其他人,推动整个领域的发展)?

Andrew Ng:我希望能将成果与外界分享,也许不是所有内容都适合,但希望通过某种形式,分享我们的研究。不过我加入的时间尚短,接下来我希望能有更多成果可以公布。 | |

DeepMind公司研究–利用深度强化学习教计算机玩小游戏

作者 AbelJiang | 2014-05-19 19:45 | 类型 Deep Learning, 机器学习 | Comments Off

|

去年,Google买过一个机器学习的初创公司,叫DNNresearch。这个小公司是有多伦多大学的Geoffrey Hinton教授和他的两位研究生共同建立的。Geoffrey Hinton教授算是神经网络领域男神级的人物了,贴一下他在Coursera开过的神经网络课程。今年,Google又花了将近五亿美刀买下同样研究机器学习的初创公司DeepMind。Facebook,以及雅虎等公司也曾以不菲的价格买过研究机器学习的初创公司,抢人的节奏啊。下面贴一下DeepMind在被收购之前比较有名的成果,教计算机玩小游戏。详情戳图。 | |