凌云(LingCloud)云计算系统开源版本发布

作者 sswv | 2011-05-31 21:38 | 类型 云计算 | 24条用户评论 »

|

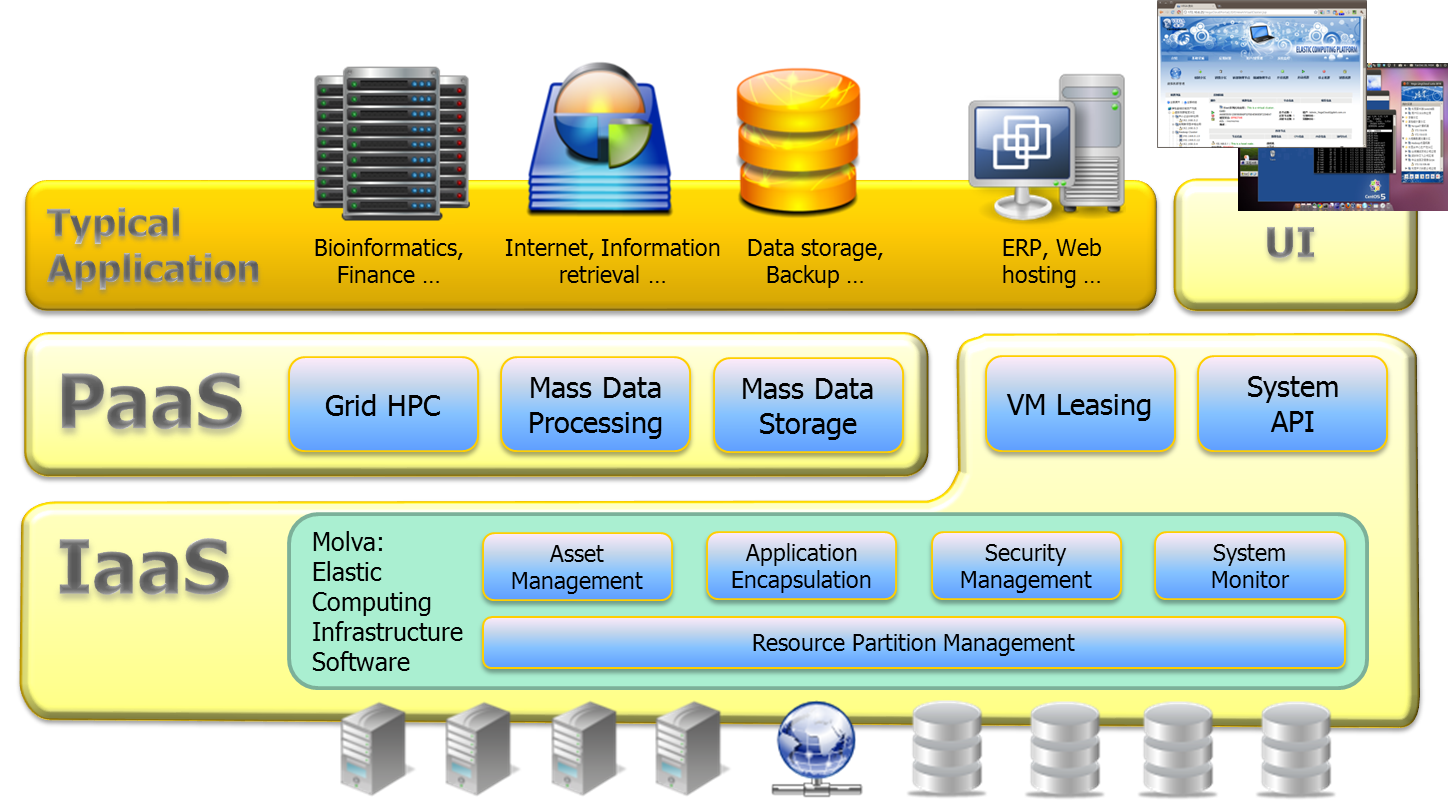

凌云(LingCloud)是中国科学院计算技术研究所分布式与云计算研究团队研发的一套云计算系统软件。它旨在解决云计算系统中异构负载支持、多租户资源租赁、系统高效整合等问题。凌云的技术特点包括:(1)异构应用模式支持——一套系统同时支持虚拟化资源租赁、高性能计算、大规模数据处理和海量存储应用模式,也支持其他应用模式直接接入;(2)单一控制点——提供单一逻辑视图,资源类型对用户透明;使用统一的用户界面和 API 进行管理,操作范围既可以面向系统,也可以面向应用;(3)无干扰的应用运行时管理——在云集中管理模式的前提下尽可能减小系统对应用运行时的干涉,保证应用性能与资源利用率,利于应用迁移和遗留系统接入;(4)多租户支持——在相同物理资源、单一系统实例上提供多租户环境,为云租户提供全局账号单一登录、安全与性能隔离,支持按使用量记账。凌云具备自主、集约、高效、安全和易用的优势,它适合构建面向政府、企业、学校与科研机构的私有云,也适合管理面向数据中心的公有云。凌云系统目前已经在国内若干家科研单位生产性使用。

凌云系统的学术论文[1]已发表于 2011 年 5 月在韩国釜山举行的第 9 届 IEEE 并行与分布式处理及应用国际会议(IEEE International Symposium on Parallel and Distributed Processing with Applications, ISPA 2011),并获得最佳论文奖(Best Paper Award)。凌云开源消息在大会的发布引起了国内外同行的关注。 [1] Xiaoyi Lu, Jian Lin, Li Zha, Zhiwei Xu. Vega LingCloud: A Resource Single Leasing Point System to Support Heterogeneous Application Modes on Shared Infrastructure. The 9th IEEE International Symposium on Parallel and Distributed Processing with Applications (ISPA 2011), 2011, pp.99-106. (Best Paper Award) [2] Yongqiang He, Rubao Lee, Yin Huai, Zheng Shao, Namit Jain, Xiaodong Zhang, Zhiwei Xu. RCFile: A Fast and Space-efficient Data Placement Structure in MapReduce-based Warehouse Systems. The 27th International Conference on Data Engineering (ICDE 2011), 2011, pp.1199-1208. [3] Yongqiang Zou, Jia Liu, Shicai Wang, Li Zha, Zhiwei Xu. CCIndex: A Complemental Clustering Index on Distributed Ordered Tables for Multi-dimensional Range Queries. The 7th IFIP International Conference on Network and Parallel Computing (NPC 2010), 2010, pp.247-261. (Finalist for Best Paper Award) | |

雁过留声

“凌云(LingCloud)云计算系统开源版本发布”有24个回复

(4个打分, 平均:3.50 / 5)

(4个打分, 平均:3.50 / 5)

终于沙发了,将计算、存储、网络等资源抽象为可租赁的资产接入系统,这个是最核心的吧?不知道弹性如何?

近距离接近沙发

弹性就是用虚拟机

现在的IAAS 比较麻烦的就是网络,因为网络硬件设备都是不开放编程接口的。所以在做网络的自动部署和弹性扩展的时候, 虚拟机,存储能实现自动化,但网络却是个很大的麻烦。 尤其是在使用Vt-d的情况下

看到这个挺鸡冻的,可惜还没开放文档耶。不知道虚拟机管理策略是怎么做的,对这块感兴趣。

弹性做好了,不仅仅靠虚拟机吧?亚麻的s3,没有虚拟,照样弹棉花

与咱们的小吴总的人云有没有一些比较?

跟随首席,我这样看,吴总的人云基于yuntable,从LingCloud看不仅是虚拟机,数据处理也有了,盘子要比吴总的yun大一大圈

跟人云不同吧。 这个提供两个层次的云计算服务。

1.IAAS,主要卖点的资源的弹性管理与自动部署。可以为中小公司打造私有云平台。

2.PAAS,基于IAAS+Hadoop等等,提供平台服务。

人云可以没有虚拟化, 就直接分布式数据库+类mapredius = PAAS。

只是现在做IAAS的,虚拟机管理可以用VM的hypervisor 或者 libvirt等, 存储可以用IP-SAN, 分布式文件系统, 但还没有看到好的网络管理与部署的解决方案。

呵呵,谢谢首席和各位的mention^_^

无论在平台范围,还是在团队实力方面,我们的人云都无法和凌云相提并论。我们只希望把YunTable做好做精,使得它能快速存储和分析海量的数据:)

关于网络可以关注一下OpenVSwitch

http://openvswitch.org/

The current stable release of Open vSwitch (version 1.1.1) supports the following features:

* Visibility into inter-VM communication via NetFlow, sFlow(R), SPAN, and RSPAN

* LACP (IEEE 802.1AX-2008)

* Standard 802.1Q VLAN model with trunking

* 802.1ag link monitoring

* Fine-grained min/max rate QoS

* Support for HFSC qdisc

* Per VM interface traffic policing

* NIC bonding with source-MAC load balancing, active backup, and L4 hashing

* OpenFlow protocol support (including many extensions for virtualization)

* IPv6 support

* Multiple tunneling protocols (Ethernet over GRE, CAPWAP, IPsec, GRE over IPsec)

* Remote configuration protocol with local python bindings

* Compatibility layer for the Linux bridging code

* Kernel and user-space forwarding engine options

* Multi-table forwarding pipeline with flow-caching engine

to 11楼:

我说的网络问题,是指数据中心整体网络的部署问题。 open vswitch 只解决了最边缘交换的问题, 但没有解决整个网络的问题。

比如, 用户需要在IAAS上部署一套业务,它需要网关,路由,VLAN等网络属性,这些都需要配置在VM沿途的所有open v-switch, core-switch, access switch 上。

这样才能真正意义上实现自动部署。 可是硬件设备上不开放接口的, 那么, 目前只能通过手动配置来完成?

目前有解决方案,思科的nexus 1000v软件交换机,以及nexus5k,7k配套。

to 13 , 这个是思科, vmware, emc 阵营的方案。 对一般IT公司来说,没法重用现有硬件, 而且有设备绑定困扰。及时是他们, 好像整体网络解决的也不太好。每家都有自己的利益诉求在里面。

从这来看, 交换路由也需要开发接口。也许openflow 提供了方向, 可是没有几个硬件厂商是真心支持的。

开放

提供网络业务,不一定需要hop by hop部署。一般来说Edge部署业务为主,Core无需业务感知做大管道即可

具体到OVS,它把Edge放在了Host,此时无论是TOR还是Aggr还是Core都是中间管道了,不再需要感知和开放业务特性。因此,OVS可以部署在任何现有网络设备上,并且对网络设备要求极低,能完成基本转发即可,它甚至可以穿越L3实现跨多个网络模块的大二层(用GRE封装)

当然,光有OVS是不够的,还需要另一个Edge:每个租户在DC出口要有一个虚拟的网络业务设备(类似vmware的vshield edge),完成诸如VPN、load balance等网关功能。但这种形态的设备也是单独部署的,不会和DC的TOR/Aggr/Core switch共置,因为其需求完全不同。

因此DC内的switch,的确在OVS的场景下是可以用很便宜的大管道设备搞定,无需做复杂的业务感知和业务开放

可惜都没抓住“云计算”的本质。

弯曲的朋友们,大家好。看了各位的留言,我们凌云团队深感欣慰。

首先,我代表凌云团队,就大家对凌云的关注表示感谢。

其次,大家留言中谈论到的许多问题,我们凌云都有考虑与涉及。但是由于种种原因,我们的开源版本目前从功能来讲,还是比较简单的,所以未必会覆盖到大家关心的若干问题,请大家见谅。但是,请大家持续关注凌云,我们会逐步开源我们其它部分的代码,并就大家关心但凌云目前没有涉及到的问题,会在未来的版本中,酌情考虑加入。

另外,凌云目前仍然是以研究为主,当前开源版本主要在探讨云计算的基本模型和体系结构,所以在设计和实现的方法学上,可能和企业界的朋友有些许区别,欢迎大家向我们提出宝贵建议,一起探讨。

最后,凌云一直在成长,需要大家的帮助、鼓励、支持与参与。

再次感谢大家!

to Ronnie

VT-d现在在向下一个版本演进,今后的硬件直接访问会支持虚拟机的动态迁移

貌似黄凯老师是凌云的首席指导老师?

去年内测的时候我亲自看过,貌似还不支持node之间的计算资源合并?

to libing

这个迁移的支持是通过Hypervisor来控制的吗? 不清楚现在这些支持硬件虚拟化的网卡是否提供了外部接口? 他的可编程性如何?

to 根本不相干

你的思路是: 在两个Edge上提供网络的控制, osw 和 网关 Edge,中间的switch提供透明的大管道, 这也是我们目前采用的solution。但问题是:

1. 这个大管道缺乏安全性和业务控制,这在大型数据中心里,能接受吗?

2. 网关Edge 和 Core为什么不在同一个设备上呢? 如果单独出这样一个Edge,增加了复杂度和用户成本。而且他跟Core的边界定义很容易混扰吧?

3. 即使单独出这样一个Edge,那么他是可控制的,开放接口的设备吗?他能承载云平台下的大量用户吗?

可能问题描述的不是很清晰, 如果有兴趣, 可以mail 沟通下。呵呵。

to ronnie

不好意思才看到

你的邮件地址是?

to libing

很好奇VT-d的演进版怎么从硬件上来支持动态迁移,能否透露一些信息或思路

VT-d break 动态迁移是因为物理设备没法这这个host上save,在另一个host上restore。所以只能通过hotplug的方法来做,但是这显然会break服务 (断网)。从软件的角度,可以通过teaming driver来解决。也就是当动态迁移是,把有VT-d直接分配的物理网卡hotplug out,由于teaming driver,网络不会断,等到迁移到新的host上后,再把物理网卡hotplug in。