POWER芯片震荡中国服务器产业

作者 陈怀临 | 2014-10-29 10:51 | 类型 研发动态, 芯片技术 | 5条用户评论 »

|

10月28日,中国POWER技术产业生态联盟在苏州成立,不仅由工信部副部长杨学山、江苏省副省长史和平亲自揭牌,而且几乎所有的国内服务器产业链企业全都齐聚苏州。问题来了,美国IBM的服务器芯片POWER缘何在中国受到如此重视,以至于震荡波席卷了整个中国服务器产业? 笔者在苏州现场发现签约不断,内容颇多,不过核心问题则在于以下四点。 一,IBM开放了服务器POWER8芯片的知识产权IP。这意味着中国企业可以在POWER8架构基础上进行自主创新,未来将在服务器芯片领域拥有难得的自主知识产权,类似于ARM的授权方式更有利于自主创新的国内大环境。 二,IBM同意开放软硬件系统并取消自身安全模块,允许中国加载国产安全模块。这意味着安全不等于可控,面对广受诟病的跨国企业IT产品的安全问题,IBM给出了颇有诚意的解决方案,更有利于自主可控的国内大环境。 三,IBM授权并转让给中国的不是落后技术,而是今年才发布的POWER8乃至未来几年后的POWER9芯片技术。这意味着不论对中国来说是市场换技术,还是对IBM来讲是技术换市场,正因为全球已经认识到服务器产业东迁中国的整体大环境,才使得市场和技术之间有了更匹配的交换价值。 四,刚刚成立的中国POWER联盟是与IBM全球OpenPOWER联盟平行的开放组织。相较于其他国家,中国IT产业和美国一样拥有完整的国产服务器生态链,IBM这种做法更容易吸引中国本土企业加盟,换句话说这样的组织架构更“接地气”。 这下该理解中国为何如此重视美国企业芯片的原因了吧。消息一出即引发业界震荡,但IT业界关心的话题又进入了新一轮扩展,具体看来多集中在如下四个方面:中美谈判都谈成了什么,IBM这样做的真实原因是什么,国产龙芯未来是否会受到影响,中国POWER芯片上市后是否仍会落后于主流市场?

爆料中美谈判内容 那么,这样意义深远的合作谈判是否会几经周折,耗时耗力?谈判过程是这样的。 全球背景是去年8月,IBM在开放POWER芯片后,宣布与谷歌、英伟达、泰安、Mellanox共同成立OpenPOWER联盟,现有成员已超过60家,包括中企业11家。 而中国政府指导的合作开始于今年3月。当时,还成立了工信部IBM联合工作小组,工信部和IBM签署了关于POWER技术产业合作MOU,包括微处理器,计算机系统,系统软件及应用生态系统,知识产权与培训等方面的合作内容。此后,四个月进入了多轮谈判过程。最终,在“核高基”重大专项专家组的直接领导下,就从IBM引进世界一流的64位指令系统及CPU技术在合作目标、引进和交付内容,分阶段合作规划、参与对象、时间进度安排等诸方面达成了一致意见。其中,POWER架构指令和POWER8 CPU芯片设计的两项技术授权协议早在7月26日就签署了协议文本。 据OpenPOWER联盟白金成员、POWER芯片中国被授权方——苏州中晟宏芯公司董事长郑茳透露,最后与IBM谈判的主要成果包括: “技术的先进性:IBM转让全球最先进的POWER8 CPU技术,并承诺继续转让POWER9 CPU技术,保持技术的持续先进性; 授权的长期性:IBM对技术的授权将不设定期限,可供中国长期使用;创新的自主性:IBM同意中国拥有在POWER8架构基础上进行自主创新权利,承诺我们的自主知识产权; 安全的可靠性:IBM同意开放软硬件系统,取消安全模块,并接受中国的安全审查。我们将加载国产的安全模块系统,满足国家的安全需要; 合作的全面性:IBM围绕POWER8 CPU技术的转化和产业化,开放和转让操作系统、中间件和数据库软件,开展人才培训、研发支撑、软件生态建设等全方位支持,帮助打造中国自主Power服务器产业生态链。 市场的全球性:我们在中国市场销售国产服务器CPU,基于我们自主CPU的国产服务器产品可以拓展全球市场。”

IBM难道是“活雷锋”? 在仔细阅读了谈判重点成果后,业界同仁们关心的问题又来了:商业谈判重点在于互利互惠,IBM难道是“活雷锋”,它这样做的原因是什么呢? 众所周知,在目前服务器主流市场中,x86服务器全球出货量高达95%,营收也超过70%,而剩下的部分基本就是POWER服务器的市场(UNIX服务器中POWER市占率70%),且前者优势大有继续扩大之势。为此,IBM的POWER服务器从原来只搭载UNIX操作系统开始支持Linux,在虚拟化方面从独有的POWERVM开始支持KVM,未来还将包括DOKER技术,进一步走向开放,并试图全面覆盖x86服务器市场。 虽然,POWER芯片与Intel最新芯片相比性能更胜一筹,但是根据创新经济学观点,成为主流技术或产品的根本原因不在于技术性能的优劣,而在于技术的扩散范围和扩散速度,从这点来看,不可否认,POWER目前形式急迫。正如一盘围棋棋到中盘,而中国则成为POWER芯片与Intel对抗中的胜负手。这是因为,在全球服务器产业东迁中国的大背景下,中国的服务器企业和以互联网为主的超大规模数据中心,甚至行业企业需求都成长迅速,这样的市场可以说直接决定了POWER的扩散范围。 另一方面,效法ARM开放芯片知识产权也成为POWER芯片在商业模式上的胜负手,开放的商业模式决定了POWER的扩散速度。除了更为吸引系统企业加盟,在服务器市场上尤其值得一提的是,以云计算、互联网为代表的超大规模数据中心已占服务器出货量的20%,他们掀起了从芯片开始深度定制化的潮流,这也就不难理解为何谷歌会成为OpenPOWER联盟的创始成员。 但是对于POWER不同的是,ARM靠授权收费,也许注定只能成为利润颇丰的中型企业;而IBM POWER效仿ARM模式,并不意味着蓝色巨人指望靠授权盈利,更重要的在于盘活整个POWER服务器市场,在相关软件、服务器、生态圈中获取商机。

龙芯该怎么办? 就在10月,曙光也刚刚发布了龙芯3B芯片和服务器,自然有业界同仁反应中国企业开发已久的龙芯是否会在因此受到影响?这确实是个难以回答的问题。笔者认为最好答案一定是,芯片产业百花齐放百家争鸣的局面才是市场化的局面。 不过,仔细分析下服务器市场上的几颗“芯”,你也许可以自己做出判断。目前服务器市场上,除了英特尔已有的强大生态圈,POWER芯片正在建立的开放生态圈之外,其他芯片的情况是:Oracle和富士通采用SPARC架构芯片搭载Unix操作系统,在高端服务器市场占据一席之地,但未形成开放的生态环境,市场份额上也大大低于POWER芯片;龙芯采用MIPS架构,自主知识产权,应用于国内敏感领域,还未能进入主流商业市场;被普遍看好的ARM架构以及相关服务器,普遍认为从移动端转移到服务器端要等到2016年才可能规模应用。 应该说,除了过硬的芯片性能外,开放的生态圈,着眼于更大的市场才是决定芯片未来前景的衡量标准。而在中国市场,芯片未来还要满足自主可控、自主知识产权的条件。从这些指标来衡量,任何一种芯片如果可以着力于上述方向,都将具备良好的潜质。

等中国芯片上市又落后了? 不可否认,从授权签约到真正生产出中国POWER芯片,这种技术上的引进、吸收再创新一定需要数年的时间。而服务器芯片基本三年换一代,等中晟宏芯的中国POWER芯片问世,那时POWER8还是新技术吗?这是不少服务器产业链专业人士的进一步问题。 这一点上,IBM给出了从POWER8到POWER9技术都将授权给中国的承诺。另一方面,目前中国唯一生产POWER芯片的中晟宏芯董事长郑茳也在28日苏州的会议上给出了产品路线图。第一代芯片CP1H将于2015年12月推出,12核心,去除了IBM安全模块,它对标的是英特尔E5-2690,首先满足安全透明的要求。2016年搭载国产OS和基础软件、针对中高端市场的CP1H系统将问世。2017年12月第二款芯片CP2问世,它集成自主的FPT,多路直连,IO增强,对标英特尔E5-2620/2650,这时的POWER芯片才是一款真正自主可控的芯片。而搭载这款芯片的CP2系统将针对中低端市场,预计于2018年6月问世。 据悉,中国POWER芯片瞄准的不只是政府系统的自主可控服务器,以及关键行业高性能自主可控服务器,还包括面向数据中心和云服务的中低端商用服务器,可谓针对主流商业市场。那么未来这场震荡波将持续多久,后续是否可以掀起层层涟漪效应,让我们拭目以待。 | |

科技一周~魔幻现实主义

作者 硅谷寒 | 2014-10-25 12:09 | 类型 硅谷科技周报 | Comments Off

系列目录 科技一周

科技一周~魔幻现实主义 2014/10/25

虽然,Magic Leap的CEO,Rony,在接受媒体采访时,对自己的产品尽量保密,但我们还是可以大概猜测出来:Magic Leap一定是一款可穿戴的虚拟现实设备,不,确切地说,应该是“魔幻现实”设备。Rony在谈到Oculus Rift(几个月前被Facebook收购)时,显然认为自己的产品比之格调高出许多。他认为,Oculus Rift仅仅是虚拟现实,也就是说,用计算技术构造出一个完全虚假的场景,并通过头盔展示给人们,而Magic Leap将会把人脑“想象中”的场景与真实的世界完全融合起来,达到一种魔幻的超现实的(Magic Realism)境界。其实,通俗点,Magic Leap就是一种“三维实时的自动PS”技术:) 举个例子来说,当你在海滨游乐场日光浴的时候,突发奇想,如果有一只巨大的虎鲸窜出来,将会是怎样的情景呢?好的,你现在可以戴上Magic Leap的设备,来欣赏一下你脑海里的想象与现实相结合的情景:一只虎鲸从海水里飞跃而出,震撼了整个海滨游乐场!这个场面,我们曾在《少年Pi的奇幻漂流》里见到过,但如果有了Magic Leap,我们可以随时随地沉浸在自己创造的“魔幻现实”里。 从图像处理的角度来说,Magic Leap是一种图像合成技术,与虚拟演播室,或者电影里看到的特效合成技术类似。当然,Magic Leap与它们还是有一定区别的,在电影特效里,大多通过前景传感器定位技术,把前景目标与背景合成起来,而Magic Leap因为受限于设备的穿戴性和处理的实时性,不可能给虚拟前景加装传感器。至于Magic Leap将采用什么样的定位技术,把前景与背景“完美”的合成起来?我也只有等到它发布之后,再做深入研究了。 [2]. http://techcrunch.com/2014/10/21/magic-leap-tech/ 图1. http://www.deshow.net/cartoon/michael-parkes-magic-realism-paintings-720.html#pic 图2. http://media.economist.com/sites/default/files/cf_images/20070407/D1407SB1.gif | |

华三 。 《万台规模下的SDN控制器集群部署实践》

作者 陈怀临 | 2014-10-22 11:33 | 类型 NFV, SDN | Comments Off

|

本文根据华三通信研发副总裁王飓在2014年QCon上海的主题演讲《SDN控制器集群中的分布式技术实践》整理而成。 目前在网络世界里,云计算、虚拟化、SDN、NFV这些话题都非常热。今天借这个机会我跟大家一起来一场SDN的深度之旅,从概念一直到实践一直到一些具体的技术。 本次分享分为三个主要部分:

我们首先看一下SDN。其实SDN这个东西已经有好几年了,它强调的是什么?控制平面和数据平面分离,中间是由OpenFlow交换机组成的控制器,再往上就是运行在SDN之上的服务或者是应用。这里强调两个,控制器和交换机的接口——我们叫做南向接口;另一个是往上的北向接口。 SDN的核心理念有三个,第一个控制和转发分离,第二个集中控制,第三个开放的API——可编程、开放的API接口。单纯看这三个概念,我们很难理解为什么SDN在网络业界现在这么火。这三个概念就能够支撑起SDN的成功吗?所以我们要探寻一下SDN背后的故事。 SDN背后的故事其实SDN在诞生之初,我们这些做网络的人对它不重视,最开始认为就是大学的教授搞出来的实验室里的玩具,并不认为会对产业界有大的影响,可是几年下来以后让我们每个人都大吃一惊,它发展太快了。这个背后有什么呢? 实际上在SDN的发展的几年当中有另外一个技术在迅速的发展,铺天盖地来到每个人的身边,就是云计算。说云计算我还想跟大家分享一个小故事,我前几天在公司准备QCon的胶片,我们公司的负责保洁的师傅说了,你做云计算啊?我说是啊,你也知道云计算?他说当然知道了,我经常用云计算,那我问他,你都怎么用的?他说上淘宝啊,经常买东西。然后我就问他了,那你知道淘宝应该算什么云吗?其实我问他这句话背后的含义是因为,在我们这个圈子里面把云分为公有云、私有云、混合云,我想问问他,结果他的答案非常让我震惊,淘宝你不知道吗?马云啊!所以我就深深的体会到了,起一个好的名字是非常重要的。 刚刚这个只是个笑话,体现了两个问题:第一个就是云计算现在地球人都知道,第二个就是每个人对云计算的理解又是不同的。我给云计算下了一个定义,就是使计算分布在海量的分布式节点上并且保持弹性,这么说可能比较抽象,再说的稍微形象一点就是说使资源池化,在你需要的时候可以按需索取、动态管理。 当人们围绕着按需索取动态管理做文章的时候,什么技术能达到这个要求呢?虚拟化技术。所以现在看云管理平台,OpenStack、CloudStack也好,都是围绕这三个方面——计算、存储还有网络的虚拟化做文章的。 在这股虚拟化的浪潮前面,计算虚拟化发展的最早也发展的最快,网络和存储的虚拟化就相对滞后一点。当人们把目光聚焦到网络虚拟化的时候,人们寻找解决网络虚拟化的方法和工具,这个时候SDN就出现在人们的视野里了。 刚刚讲的SDN三个理念:控制和转发分离可以使控制层面脱离对网络设备的依赖,可以快速发展;集中控制就很方便对资源进行池化和控制;开放的API——南向和北向接口——可以催生产业链,推动整个产业的快速发展。 开放的云计算数据中心解决方案都离不开SDN,从某种程度上讲,是云计算架构里面的基石,再讲另外一个话题,NFV也是比较热的话题,是网络功能虚拟化,和刚刚我讲的网络虚拟化就差一个字母,但是实际上阐述的是两个不同层面的概念。 我们讲了云计算需要网络虚拟化,实际上不是今天才有的,像我们做网络的人都知道在很久以前人们就有这种网络虚拟化的要求了,不过在那个时候我们管它叫VPN,虚拟专用网,以前使用的都是在一个公共的网络上虚拟出来一个专用的网络,让使用者以为这个网络就是给我专用的。 那么到了云计算时代,在我们讨论云数据中心的时候,就不再用原先的词了,现在说multi-tenant,多租户,其实道理是一样的,也是在一个公共的网络里隔离出来各个专用的网络。这个技术是什么?就是Overlay。数据层面看这俩技术没有本质的区别,都是实现了数据封装,方式就是在网上建立隧道把各个网络隔离开。

回头看NFV这个概念,就有点区别了:NFV是欧洲电信联盟提出来的。我们知道在运营商的机房里面看到成片的服务器、存储设备、还有大量的不同厂商不同的网络设备,云计算的时代这些运营商也不干了,这么搞太烦了,维护起来成本高,部署起来复杂,新业务上线很慢,他就强调能不能把这个世界搞得干净一点,机房当中只剩下三个设备:标准的交换机,标准的服务器还有标准的存储设备,除了这些设备,其他通通消失,把所有功能挪到标准的服务器上实现,强调网络功能的虚拟化。

所谓功能的虚拟化就是说把这个功能从传统的网络设备里拿出来。这个是欧洲电信联盟给出的NFV的架构图,我们看这个架构图的时候发现,这个下面的部分称为NFVI,就是基础设施,进行管理和虚拟化,目标是为了在上面提供这些他称之为VNF的功能。强调一下,这是一个一个的功能单元,这些功能单元运行在虚拟化出来的虚拟机或容器里。最右边这一块就是整个系统的管理。

我们看这个图可能会感觉很熟悉,这个就是OpenStack的架构图。云管理平台玩的就是虚拟化,管理的是计算、存储和网络。对比前后这两张图我们发现,其实NFV的架构就是云计算的架构,只不过它所强调的仅仅是运行在云计算上的服务,而不像我们普通的比如Hadoop服务为了大数据,或者WEB和数据库等等。NFV的服务都是为网络功能服务的,包括DHCP地址分配、NAT地址转换、防火墙、无线接入、宽带接入、3G核心网等等,都可以用虚拟的容器实现。所以其实网络功能和我们大家平时所熟悉的这些标准的APP或者是这些服务都是一样的,都可以一样的进行虚拟化和云化。

所以从这个层面上讲,一个广泛意义上的网络虚拟化会看到几个热门技术:SDN、NFV、Overlay,都是从不同的层面支撑虚拟化——SDN定义了一种控制和管理的网络架构,Overlay提供了一种解决数据平面转发和多租户隔离的技术手段,NFV指出了我的网络功能如何借助这个架构实现虚拟化。这里就有一个循环:网络虚拟化包含了网络功能虚拟化,网络功能虚拟化又依赖于云计算的架构,一旦这个循环形成了,这些新技术在彼此之间不停的碰撞,相互结合也相互竞争,也构成了我们今天这样一个网络世界变革的大时代。 SDN的部署案例下面给大家介绍一下我们在SDN领域的实际的案例。 在讲实际的案例之前,想先跟大家分享一下我们公司对未来网络发展的一个理解。我们知道现在SDN、NFV很热,但是传统的网络并不会消失,在很长的时间内这些技术会并存。我们强调一个什么概念呢?就是一个虚拟的融合架构。

这个图是一个三横三纵的结构,我们从三纵开始。最右边就是云,解决的是计算存储的问题;最左边是端。有人最近提出来一个概念,说现在的网络是云计算和移动互联网的时代,云计算就是云,而移动互联网就是端。对端的管理,不管是什么样的网络,我们最终检验网络质量的标准是什么?最终用户的体验。如果你的网络解决不好这个问题,你这个网络就很难说是成功的网络——所以中间就是云和网的结合体,就是网络的主体。 我们再横向看三层。底下一层就是基础的设备,包括终端设备、网络设备还有计算存储,包括NFV虚拟出来的网络单元也可以当成逻辑的网络设备放这里。第二层就是所谓的融合控制层:我们认为在网络上应该有这样一个层次,既可以管网,也可以管云,也可以管端,这些都需要进行一定的集中控制。最上边的一层就是所谓的资源管理层,在这个里面第一要对所有的资源进行池化,比如OpenStack这样的管理平台;在这个之上要提供一个业务编排的系统,把这些逻辑的分散的资源单元串在一起,才能够为用户提供服务;再之上就是针对不同的网络服务提供一些管理组件。 这个VCF架构强调每个层次都要对上一层次提供开放的接口,最终对最上面用户的应用提供可编程、可控制的能力。这实际上强调的是什么?就是对端和云中的应用提供了一种自动化的编排和管理的能力。 这么说可能比较抽象,我举个具体的例子,比如说你的手机拿起来了要上网,当你的手机上网的时候,传统的网络就是AC,无线控制器做Wifi认证;但是在我们这样一个融合架构里面,对这个手机进行认证的设备就不再是AC控制器了,而是VCF的网络控制器。在这个网络控制器对这个手机进行认证、允许上网以后,就知道这个手机是谁的,应该有什么权限,可以获取什么资源,这个时候就要执行一个我们称之为user profile的服务模板,执行之后会控制整个网络里面所有的设备,根据这个用户上网这一个动作,它就可以对这个用户所需要的所有的资源进行调整。这在传统的网络里是很难实现的。 另一个例子,在云数据中心一款APP上线,一般就是VM或者是一个容器的创建。一般情况下在云管理平台里面,容器创建的时候就要分配和指定资源,包括什么资源呢?CPU、内存、硬盘、网络出口带宽、还有这个服务前面要不要加防火墙、是不是大的集群中的成员前面要放负载均衡、要不要给它备份管理等等等等,这些功能实际上存在一个叫做app profile的文件里。这样在整个云里面,不论是存储还是计算资源还是网络资源都被这个APP上线调动了,他会根据你预先编排好的需求,动态对所有的资源进行调整。我们以前做应用的人对网络施加一些控制是很难的,只能对网络管理员提出要求,让他实现;但是现在,我们就具备一种动态管理的能力,这就是这样一个概念带来的一个变革。 所以说,我们认为VCF这样的概念实际上就是我们对SDN这个概念的发展和补充,是我们认为未来网络发展的趋势。 像这样一个整网融合的方案会比较大,我们真正在商用的时候往往只会使用一部分。比如说我们在给一个数据中心做方案的时候,可能重点关注于你的云和网;如果给一个城域网做方案,可能就是关注网;如果是给园区做网,就是关注端和网的管理。 下面我就给大家讲两个实际的案例。

第一个,浙江政务云。这个项目包含两个部分,一个是公有云,一个是政务云,公有云由阿里云承担,政务云由我们公司承建。我们看一下结构,在这个图里面我们会发现,有计算、存储,中间是一个由核心交换机和边缘交换机构成的网络把这些全部连接起来,同时还有网络的管理控制器和云的管理控制器,之上就是iMC——一个更高层的资源编排和管理软件。上面的OpenStack没有直接管理交换机,而是通过往OpenStack里面注入插件,把控制功能转给了控制器,包括云控制器和网络控制器,然后再去管理物理的设备。这样有什么好处呢?保留了开源云管理平台OpenStack的开放性,第三方应用可以用同一个API来做控制;而同时因为使用了专用的控制器,效率会有进一步的提升。 这个专用控制器就是SDN和Overlay技术的实现,可以对外控制三种网络角色:VxLAN VTEP控制虚拟化的vSwitch,VxLAN GW控制数据中心内的边缘交换机,VxLAN IP GW控制对外界连接的网关——核心交换机。 Overlay这个技术有一个特点,就是它初始化的时候,所有节点上的流表是空的。在什么时候才形成转发控制的能力呢?是随着业务的部署形成的。比如说当有一个VM想跟另外一个通讯的时候,第一个报文就被vSwitch捕获,然后分析一下,就知道应该从哪个虚机到哪个虚机,在源和目的的之间建立一个隧道下发流表,把这个初始的报文返给vSwitch,这样就过去了。 这样处理有甚么好处呢?最大的好处是节约资源。我们知道像这样的数据中心可能有几千或者几万个节点,就是几十万个虚拟机,如果让任意两个VM之间都可以通的话,大家算一下要多少的流表——这个资源是有限的。实际上不会所有的VM之间都有通讯的要求,根据业务部署可能只有很少数量的VM之间才会通信的要求,所以这样的方案很节省流表的资源。这个方案如果说有缺点的话是什么呢,因为它的这个首包上送给了控制器,越到后期在控制器这块的压力就会越来越大。这个问题怎么解决我们后面讲。

再看腾讯的这个方案。腾讯数据中心的情况是,他们自己已经有云管理平台,有自己的vSwitch,只是需要我们的物理交换机和控制器。这个方案展开一看大家会发现跟我刚刚讲的这个浙江政务云的方案其实是很类似的,也是SDN加Overlay的方案。只不过在这个方案里面,第一,不是所有的设备都是我们的,所以需要我们在我们的控制器上面有一些东西跟腾讯的云管理平台进行对接;第二,就是规模的问题,腾讯让我们建立这样的数据中心到什么规模呢?物理的服务器一万五千台。这给我们整个管理带来了很多的挑战,我们怎么才能部署控制器管理一万五千台的服务器,几十万的虚机?下面讲一下我们这个集群管理的部署方案以及具体的优化。 SDN Controller集群部署方案以及优化

讲解控制器部署之前,我们花一点时间进入控制器软件的内部,看看这个Controller的软件架构。可以看到我们也用一些开源的工具,然后之后呢还有一些各种层面的模块。我们去看一下具体的逻辑图,可能看的更清楚一点。

我们把控制器分成不同的层次:最下面我们称之为南向接口层,有OpenFlow、NetConf/XMPP、BGP等等不同的数据协议,这是因为控制器往下要管理不同的节点,这些不同的角色(vSwitch或物理交换机)使用的协议不一样。 第二层是SAL适配层,这一层屏蔽了不同的厂商/不同的设备对南向提供接口的差别,让上层的模块运行起来可以仅仅针对他关心的业务处理,而不用关心不同厂商的API有什么差别。 再往上就是基础的网络功能模块,这一块没什么说的。再往上就是内置应用。在SDN里面有两种应用,一种是内置的应用——就运行在SDN的控制器上,还有一种外置的应用——在上面。我们看到这里有Overlay模块:最关键的计算都是由这个Overlay模块完成的。 再往上就是北向接口层了,就是可编程的控制器要对外提供一个良好的编程接口。 还有一部分就是管理层,有软件的管理、软件自身的升级、增加模块,还有生命周期管理、集群的管理,还有一些UI的界面。

讲完这个层次图以后,回到刚刚的问题上。我们Overlay的过程——送给控制器,下发流表把这个包返回给vSwitch进行转发,这个是一次首包上送。这个方案所造成的问题就是对控制器的计算能力提出挑战。所以我们在这个方案里面重点优化首包上送的处理能力,对刚刚的结构不停的优化、进行重构。 最后我们做到什么性能呢?标准的Intel i7 4核处理器上,可以做到500k的处理能力。在这个基于Java的架构上,我想再做出质的提升恐怕就很困难了。 那么这一个控制器能管理多大的网络?瓶颈在首包上送的能力,我们可以计算一下:一个服务器有1个vSwitch,跑20-30个VM,每秒大概可以产生500以上的新流,就是每秒有500次跟一个新的、不同的设备通信。那么用我们刚刚的首包上送一除就知道,500K的TPS性能,一个控制器大概可以管理一千个Host;当一个数据中心规模在15k的时候,单节点控制器肯定搞不定了,就需要控制器集群。 我们把所有的控制器就是称之为一个团队(team),一部分成员是领导者(leader),一部分是成员(member)。Leader对上提供北向的访问接口,负责对cluster进行管理;Member就负责管理控制交换机,连接交换机的方式就是刚刚讲的南向接口。 单一的节点可能会不安全或者是不可靠,所以就提供了另外一个东西就是Region。我们把所有的leader放在一个Region里,作为主集群,其他的作为备份,这样就保持这个集群有一个持续的不间断的对外提供北向接口的能力。下面这些member划了一个一个Region,一个Region中有多个Member,Switch要同时连接到一个 Region中的所有Member上,并选取一个作为主。这样的好处是什么呢?一个switch有多个member,如果我的主域宕掉了,这个switch发现了以后就可以从剩余的里面选择一个新的,备变为主,这样就可以提供一个不间断的服务能力。 我们拿两台服务器做主,然后划分15个Region,一个控制器可以管理一千台的服务器,15个正好是15000台。总的来说就是对控制器进行分层的设计,让leader提供向北接口,member提供向南接口。

简单介绍一下我们实现这个集群采用的技术。Team管理功能,是在Zookeeper之上封装的,这个Team实现了成员管理、leader选举、上报Team事件,具体的方式是很标准的Zookeeper使用方式,这个就不多说了。 那么还有一个重要的问题,不是说你的成员加入集群就完事儿了,我刚刚讲腾讯的方案的时候,腾讯的云管理平台上有大量的VM的信息,这些需要你做一个模块抓取过来,要在你所有的控制器之间共享,所以说就需要有一些数据在所有的控制器间共享,也就是HA。按照我们做网络的习惯,我们把HA分成两种功能,一个是实时备份,一个是批量备份,目标就是希望这个HA系统对上述的APP是不可见的,具体看一下实现。 第一个就是BUS,它提供通讯的通道,当你写入一个数据的时候,就在主那里创建一个单元,发现这个节点发生变化,就把这个单元读出来,这个数据就传过去了。 KeyStore,实现了一个非常简单的数据库功能,采用Key-Value机制,不支持范围查找,只提供了设置和获取接口,没有通知接口。有的同学会问了,说你们跟Zookeeper干上了是吧?那我们做开发的人都知道,当我们熟悉一个工具的时候,就会很自然的重复使用,尽量用熟为止。 实际使用当中的实时备份过程就是这样的,很简单,集群中某个成员业务数据变化时,发送bus消息通知其他成员,同时将本成员的运行数据以key&value的形式保存在KeyStore中。 批量备份就是当新的控制节点加入时,KeyStore就会自动将其他节点的数据备份到本地,App需要先从KeyStore中恢复数据,当恢复完成后,再开始接收bus消息。做keyStore数据恢复时,要求bus可以从批备开始的时间点开始缓存bus消息,等恢复完成后补报这些bus消息,这样就可以保证了最终数据的同步。 今天跟大家分享的话题就到这里,谢谢大家! 嘉宾简介王飓,华三研发副总裁,从事数据通讯设备软件开发长达14年,作为资深的网络协议专家和软件系统架构师,熟悉多个层面的数据通讯协议,擅长做通信协议设计以及实现,对嵌入式系统和复杂软件系统设计,以及对实时系统的性能优化有着十分丰富的经验。此外,对网络安全有着比较深入的研究,对各种网络攻击和防护有着丰富的经验。近年来开始关注并投入SDN相关领域的研究和开发。对OpenStack、OpenDaylight、OpenVswitch、NFV等都有一定的研究,对云计算时代的网络通信有着深刻的理解。 在这个云计算的时代,很多传统的通信技术都会经历一个痛苦的解构重建的过程,如何把已有的网络经验融合到现在的SDN世界当中,充分利用历史的积累,是他目前最为关心的问题。 感谢杨赛对本文内容的整理。 | |

2014中国网络安全大会 . 北京 。10月23日

作者 陈怀临 | 2014-10-21 10:56 | 类型 行业动感 | Comments Off

|

大会介绍(本次活动免费) 为此,”2014中国网络安全大会(NSC2014)”定于2014年10月23日-24日在北京召开。大会以”全球化的网络安全:”新格局?新挑战”为主题,将邀请国内外信息安全领域顶尖专家、国内重量级企业高管、政界嘉宾、知名学者等共聚一堂,围绕互联网金融安全、移动互联网安全、可控可信的企业网络安全、大数据时代的云安全、创业与投资等热点议题发表主题演讲,与参会者共同探讨与分享全球前沿的信息安全技术与解决方案。 本届大会是在国家计算机病毒应急处理中心、中关村管委会的指导下,由中关村海外科技园与赛可达实验室-西海岸实验室(中国)主办,中国金融CIO联盟、中关村信息安全产业联盟、中国科学院北京国家技术转移中心、中国云体系产业创新战略联盟、(ISC)2、OWASP中国、威客众测等多个行业协会、机构组织协办,国内知名媒体CCTV、经济日报、光明日报、人民网、京华报、新浪网、搜狐网、腾讯网、计算机世界、CIO时代、51CTO、IT168、赛迪网、东方安全、SC MAGAZINE等都将对此次大会给予协助并全程报道 诚邀各界人士共襄盛举,共谋发展! 注:报名成功后,邮件统一发送邀请码。 讲师介绍 陈章群 陈钟 程鹏 丁柯 高磊 李雨航 刘立柱 潘柱廷 陆臻 于海波 肖新光 章恒

郑全战 周晓波 日程安排 10月24日 大会第二天 互联网金融安全论坛(中国金融CIO联盟主办) | |

硅谷深处的忧虑~时间筛选了谁

作者 硅谷寒 | 2014-10-19 17:13 | 类型 公司兴衰史 | 5条用户评论 »

系列目录 硅谷深处的忧虑硅谷深处的忧虑 1. 时间筛选了谁?

人们常说,时间是一面筛子,但这面筛子并不总是汰沙而存金,尤其是在硅谷高科技的商业史上,有许多曾经代表了某个时段的最先进技术,竟尔未能在商业战场上生存下来,着实令人唏嘘。当然,现在的我们知道了营销包装的重要性,知道了用户体验的重要性,知道了生态系统的重要性,也知道了华尔街靠山的重要性,但这一切在十几、二十几年前的时候,并不如此简单易懂。 然而,即便你深刻理解了上述所有的一切,并且能力过人,你依然有可能在硅谷收获一个“失败”的结局,因为在硅谷创办自己的高科技企业,从一开始,就是一项成功概率极低极低的乐透游戏。 硅谷最著名的创业孵化器Y Combinator(YC)曾给出了这么一个事实:从YC毕业的511家初创公司,在经过5年之后,只有37家公司被认定是“成功”的[1]。这里,YC对“成功”的定义是:价值超过4000万美元。这是一个不成文的标准,被美国的许多企业家和投资人认可。37 / 511 ≈ 7%,也就是说,另外93%都是失败者。 YC是硅谷顶级的创业孵化器,其孕育出的初创公司,可谓星光闪耀,有:OMGPOP(被Zynga以1.8亿美元收购),Reddit(一个基于新闻的社交BBS,估值2.4亿美元[2]),Airbnb(在线短租网站,估值25亿美元[3]),Dropbox(云存储服务,估值超过40亿美元[4]),等等。YC每年提供两次入驻培训,总共会收到数千份初创团队的申请,其中只有3%~5%的幸运者能够雀屏中选,“入赘”成功。由此可见,想从YC这条路径上获得初创成功,其比率约在0.21%~0.35%之间(3%*7%~%5*7%),而失败的比率超过了99.6%。 当然,这只是来自YC的数据,但我们没有理由去相信那些与YC无关的初创企业会有更大的成功概率,就像没有人会认为来自杭州师范学院的学生会比北大清华的学生更容易成功:) 即使一个初创企业成功迈过了5年的检验期,后面的道路也还是荆棘密布。如果以“三十而立”来做为硅谷高科技企业的“高寿”标准,那么一个公司能够创业成功,并“善始善终”的概率就更加微乎其微了。下面的例子,讲述了一个曾经市值超过两千亿美元的巨头公司,却最终倒在了二十八岁年龄的关口。它的名字叫做Sun Microsystems。

Sun Microsystems创立于1982年,成名于上世纪90年代,在计算机产业的软硬件方面各有一个扛鼎之作:Java软件平台,和基于SPARC处理器的高端服务器。在2005年,Sun推出了网格计算(Grid Computing)服务器领域的巅峰之作,被誉为“黄道星阵”的Sun Grid,装配有3000个CPU,像是太阳系里3000颗璀璨的星辰。 然而,在“黄道星阵”面世之后,Sun没能改变世界,反而陷入了连年亏损,近乎破产的境况,直到2010年被觊觎Java和服务器业务已久的Oracle以74亿美元收购,价格仅值巅峰期的3%。Sun的两个巨型园区,一个卖给Facebook,另一个归于Oracle。唉,丹楼碧阁皆时事,只有江山古到今[5]。 像Sun这般强大的公司,技术、资金、人才,无一欠缺,竟还是失败了。类似的例子,在硅谷还有很多:3COM、SGI、3dfx(3D显卡的开拓者),等等(Intel, Microsoft, in the future?)。 好,现在回到本节的标题,在极其艰难的创业或商业道路上,时间的神谕究竟会选择谁走向成功?创办一个成功企业的方法,真的可以从那些MBA的教材里学到吗? 我做为一个Geek,真地想把那些MBA教材统统烧掉。先让我用略带Geek味儿的描述来谈一谈“成功与失败”。 从模式识别的角度来看,“成功与失败”貌似是一个分类问题(Classification)。如果你熟悉机器学习话,你一定知道用一些线性算法来处理分类的问题,例如SVM(支撑向量机)。然而,"成功与失败"的分类之难,在于其参数的维度太高,几乎是无穷的。也就是说,你不可能设计出只有一百个参数的分类器,来解决有上千亿参数的分类问题。 同样的,对于Sun的覆灭,想给出一个令人信服的逻辑性答案,自然也是不可能的。每一个公司的功败垂成,都牵扯了数以无穷的主客观因素,甚至还有无法描述的“运气”成份参杂其中。 倘若非要回答本节标题的提问,我宁可说:没有谁可以笑到最后,时间会让每一家公司都走向失败与消亡,宛如我们每一个人的生老病死。 的确,这就是时间对我们“注定残酷”的筛选。当有一天,硅谷里满是黄沙与落日的时候,不知道还有没有人能回忆起那些孤独可爱的创业者,她/他们的青春就埋在这里,梦也埋在这里。 (本系列正式开篇,后续会讨论“改变世界”,“软件与硬件”,“算法与思想”,“优秀的人”,“金钱”,等等。本系列会在湾区评论/www.valleytalk.org和36氪/www.36kr.com同时发布) [1]. http://www.businessinsider.com/startup-odds-of-success-2013-5 [2]. http://news.yahoo.com/depending-ask-reddit-worth-240-million-700-million-155121063.html [3]. http://online.wsj.com/article/SB10000872396390443684104578066811794775602.html [4]. http://www.forbes.com/sites/quora/2013/02/07/why-is-dropbox-worth-more-than-4-billion/ | |

科技一周~灵魂的星空

作者 硅谷寒 | 2014-10-18 16:21 | 类型 硅谷科技周报 | 1条用户评论 »

系列目录 科技一周

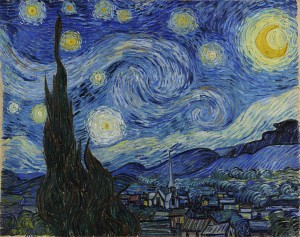

灵魂的星空 2014/10/18

本期的科技一周,重点介绍创业公司。

1. A打开微信向B发邀请; 2. B回应OK; 3. A切换到大众点评,找餐馆信息,并发给B; 4. B回应OK; 5. A切换到Phone App,向餐馆打电话预约餐位; 6. 最后,A切换到地图应用,去餐馆。 在这一流程里,A先后打开了四个应用:微信、大众点评、Phone App、地图应用,在其中频繁切换。倘若使用RavenTech的ProjectFlow平台,那么这些应用都会被“链接”在一起,共同使用ProjectFlow统一的“信息流”界面,整个交互过程如下: 1. A打开ProjectFlow,向B发邀请(ProjectFlow自动调用微信); 2. B在ProjectFlow里,回应OK; 3. A在ProjectFlow里查找餐馆信息,发给B(ProjectFlow自动调用大众点评); 4. B在ProjectFlow里,回应OK; 5. A在ProjectFlow里,打电话预约餐位(ProjectFlow自动调用Phone App); 6. A开车去餐馆(ProjectFlow自动调用地图应用)。 我们看到,新的流程里,A不需要在应用之间频繁切换了,所有的信息都会以“流”形式展现在A和B的手机上,就像是两个人在自然的对话。也就是说,ProjectFlow在后台自动完成了之前需要A手动切换应用的工作。这种交互方式,更加简单,人性化。除了Project Flow之外,RavenTech正在把类似的技术应用到手机的音乐播放器上,这被他们称之为“MusicFlow”。感兴趣的读者,可以在这里下载:[2]. 1. Lytro(图像,高端照相机) 2. Theranos(医疗,验血机) 3. Fitbit(穿戴式设备,手环) 4. Coursera(在线教育) 5. Minted(O2O装饰) 6. Wealthfront(互联网金融,自动化财务投资) 7. Bromium(企业数据安全) 8. Twilio(云通讯) 9. Engyte(企业级云存储方案) 10. Leap Motion(新型人机交互设备) Lytro,这家排名榜首的高端照相机公司,刚刚融资了四千万美元,给员工的待遇也最为优厚,工程师的薪水约在$125000~$147000。排名第四的Coursera,在创始人Andrew Ng被百度强力“挖走”之后,聘请了耶鲁大学的前校长,Rick Levin,担当CEO。自此之后,Coursera被戏称为“常青藤校长们的最佳下一站”。排名第六的Wealthfront,是一家集结了花街金融精英和硅谷软件精英的互联网金融公司,主要为高科技中产人群提供自动财务投资服务。Wealthfront这两年的发展速度十分惊人,从不到1亿美元的基金增加到了10亿美元。 下面,让我们来总览一下这份榜单。可以说,这是一个相当“杂乱”的榜单。从榜单上,我们几乎看不出什么趋势来,或者什么技术最火爆,什么市场是VC投资的重点,因为,十个热门的初创公司几乎分散于十个不同的细分领域。然而,我个人认为,这种“杂乱无章”,才更应当是创业的特点。创业公司应该基于创业者的灵魂而生,不应靠模仿“抄袭”他人而生。如果创业者都追逐自己内心的创意灵魂,又怎会出现在同一个领域里有几十家公司的局面? 创业的天空上,繁星无数,每一颗都独一无二,与其说那是他们的光芒,不如说那是他们的灵魂。

[1]. https://www.youtube.com/watch?v=lKf9pCDc9tk&feature=youtu.be [2]. https://play.google.com/store/apps/details?id=cn.raventech.musicflow&hl=en [3]. Cromwell Schubarth, These 10 Bay Area startups are tops among tech job hunters, http://www.bizjournals.com/sanjose/news/2014/10/01/these-10-bay-area-startups-are-tops-among-tech-job.html?page=all , Oct 2014.

图1. Vincent van Gogh, The Starry Night. 图2. [1]. 图3. www.lytro.com | |

从Clarifai的估值聊聊深度学习

作者 AbelJiang | 2014-10-17 15:45 | 类型 行业动感 | Comments Off

|

前几天和 Ayden @叶瀚中 聊天时,提到了 www.clarifai.com 这家公司。 此前,我已经从各方消息中听说过创始人Matt Zeiler最近打算卖公司。甚至还和朋友打赌说这个公司能不能以$5M出手。 先说结论: 这个公司的水准在13年称得上世界第一 。但是这并不能给该公司以世界级的价值。 讲到这里就不得不提Image Net Challenge。以前的Computer vision的数据集都非常小,最多不过几百类,几万张图,这带来一个问题——我们无法设计特别复杂的计算视觉模型。否则模型的复杂度太高,数据量太少,就会有 Overfitting 的问题。 2012年,华人教授李菲菲牵头搞了一个巨大的数据库 ImageNet。到今天为止,Image Net上已经有了14,197,122张图片了。对每张图片,由人来手工记录图片中物体的名字,并向业界宣布,同学们,如果你们谁开发出来了新的物体识别算法,就在我家的数据库上试试吧。 于是2012年,就有了这个LSVRC – Large Scale Visual Recognition Challenge. 最终比赛结果在2012年底的NIPS会议上公布。 当时,大多数的研究小组还都在用传统computer vision算法的时候,多伦多大学的Hinton祭出deep net这样一个大杀器。差距是这样的: 如果我们仔细看看第二名和第三名的实现,会发现大家使用的技术框架非常接近,都是local descriptor + feature compression这套。而在这套实现上,二者的差距几乎是可以忽略的——都完全不是deep net的对手。 说来也巧,我恰好也参加了NIPS 12,亲身感受了这在后来看来的历史时刻。Hinton当时放话说:“如果你没有参加前面十几年的NIPS,没关系,因为直到今年,Deep net才真正work了”。虽然deepnet取得了如此瞩目的成绩,但是就在当时,还是有大量与会教授表示不愿意接受deepnet。这里面指的“不愿意”分几个层次 在1%的性能提升都可以称之为“major contribution”的时代,被一个和最近10年computer vision,尤其是object recognition领域的进展几乎没有交集的方法,超过了10个百分点,这也难怪大家纷纷表示不承认也不接受deepnet的革命。但是,洪水的闸门已经打开。。。 一年后,新一轮的Large Scale Visual Recognition Challenge又开始了,这时候我们不难发现,Deep net的计算框架已经一统江湖了: 其中Matt Zeiler (http://Clarifai.com) 的算法排名第一,在不用额外训练数据的情况下,跑到了error rate 0.1174这样的成绩。 但是,2013年和2012年的情况又有很大不同。 排名第二的新加坡国立大学的误差,是0.129,第三名ZF的误差是0.133,这都与Clarifai非常接近。再也无法出现Hinton组独步江湖的场面了。 今年的结果还没出来,要等到12月份的NIPS 2014啦。我听到过一些小道消息,在LSVRC 12的训练集(因为测试集保密,所以线下研究的时候,大家都会辟出一部分训练集做测试),某公司已经能跑到10%以内的误差了。当然Clarifai也没闲着,在他主页上已经更新了准确率到10.7%了。 那么Deepnet的难点在什么地方呢?从最近CVPR 14的情况来看,圈子在这个方面作出的改进,几乎见不到什么质的飞跃。调整deepnet在大多数时候变成了一门实验科学:一方面,对2012年原作的修改太大,会导致识别率惨不忍睹,另一方面,很少有人能有Stefan Mallat那样的数学功底能从理论层面分析deep learning到底在干什么。但是,由于图片的数据量实在太大,站在工程角度上,如何能够在几周甚至几天内完成几百万甚至上千万图片的训练,就是一个非常非常技术的活儿了。 在工程实现方面,deepnet开山paper的一作Alex Krizhevsky已经开源了他的代码 https://code.google.com/p/cuda-convnet/ ,并且又另起了一个convnet2的项目 https://code.google.com/p/cuda-convnet2/。 必须提到的,是UC-Berkeley Trevor Darrel的贾扬清,把他写的deepnet开源了。https://github.com/BVLC/caffe 这个功能很全面,性能很高的deep net,不断被大量的开发者完善。目前来看,它是最有希望成为deep net通用架构的一个基础框架。目前,基于Caffe的识别误差,已经降到0.131了——非常接近Matt Zeiler的结果。但是要注意,这些结果几乎都是开源的。 换言之,一群有过几年cv经验的初创小团队,基本都可以超过Hinton 2012年的世界纪录,与2013年Matt Zeiler的纪录非常接近。这简直让我想起战争之王检阅娃娃兵的片段:一个本科生训练出来的deepnet,和一个有30年经验的大学教授训练出来的deepnet,其实并没有区别。 有这么个传说,真假待考,权当八卦说说吧。当年Hinton组在NIPS 12会场上,就被各家公司争相竞购。Hinton带着Google/MS/Baidu等公司的负责人,找了间屋子说我们团队竞拍,每次加价一百万。后来嫌一百万太慢,改加价两百万。再后来的故事,大家就都知道了。。。 但是http://Clarifai.com的估价和Hinton组被收购的故事又有所不同。一方面,Hinton本人是当今世界上最杰出(哪怕是2012年deepnet火爆之前)的machine learning研究者,20多年前back propagation也是他的杰作,而且deepnet的正宗首创效应也不可忽视。另一方面,deepnet席卷整个cv圈子带来的各种效应(比如开源),可能也是大家所始料不及的。

最后,一方面,我希望http://Clarifai.com能被收购,引起更多对cv的关注。另一方面也希望学术圈能尽快找准方向,尽早结束实验报告为主的探索期,能够真正从本质上解释这个伟大的理论究竟为什么work。 | |

《 孙钟秀 。操作系统教程》注释(稿)--第三章:同步, 通信与死锁

作者 陈怀临 | 2014-10-08 19:50 | 类型 操作系统, 科技普及 | Comments Off

维特根斯坦是谁?

作者 陈怀临 | 2014-10-07 10:46 | 类型 行业动感 | 1条用户评论 »

|

作者:Nick Zhang 。

URL:http://blog.sina.com.cn/u/1899141782 路德维希-维特根斯坦生于1889年4月26日。他比哥德尔整大17岁,生日就差两天。他是八个孩子中最小的,有三个姐,四个哥。八个孩子都是一个妈生的。按照血缘关系,维特根斯坦有3/4的犹太人血统。但他爸是皈依的清教徒,他妈是天主教。他受天主教洗礼,葬礼也是按天主教规矩。

我对维特根斯坦的印象就是他这辈子没跟傻逼打过交道。无论是哪个方面:音乐、建筑、数学、哲学,他接触的都是那领域里最牛逼的人。罗素描述他:“最完美的传统意义的天才,热情、深刻、激烈、专横”。

维特根斯坦家境殷实,同艺术有不解之缘。勃拉姆斯,马勒是他家常客,在他家开室内音乐会。舒曼的太太Clara(见照片,本人是杰出的钢琴家作曲家)也常来。被认为是19世纪最伟大的小提琴家乔吉姆(Joachim)是维特根斯坦祖母的侄子,后来过继给她。

维家还赞助了一堆年轻音乐家,后来出名的有指挥家瓦尔特,作曲家勋伯格(见下图)。那时这些年轻的音乐家到维家来参加家庭音乐会,也为了结识赞助者和圈内名流。跟现在创业家找VC一个路子。维家当时是欧洲最富有的家族。维特根斯坦在自己可以支配家族给他的钱财时,也资助了一些他喜欢的艺术家和诗人。那些被资助的艺术家们会写信给小维特致谢,但他看了几封之后,就觉得厌倦了,以后再有感谢信都是原信退回,因为他觉得那些信里充满“低三下四,几乎是行骗”的口气。

维家的人都富有音乐天赋。四哥保罗(见下图)是天才的钢琴家,那时经常和理查-施特劳斯经常一起演奏二重奏。但保罗在一次大战时失去了右手,他后来发明了用左手演奏的技法。战后开过音乐会,单手弹奏施特劳斯、拉威尔的作品。拉威尔的左手钢琴协奏曲(Piano Concerto for the Left Hand)就是献给独臂哥哥保罗的。他家共有7架三角钢琴。小时候一天四哥正家练琴呢,突然冲到小维的房间对他吼道“你丫在家我没法弹琴,你丫那怀疑主义顺着门缝里都能钻进来!”操,一家子都什么德行的。其实四哥是瞧不起小维特的钢琴水平。

大哥汉斯25岁时在美国自杀,那时路德维希13岁。汉斯被认为具有音乐天赋,后来还组织过弦乐四重奏乐队。他不喜欢家里让他经商的安排。两年后,三哥鲁迪23岁时自杀。受到这些压力,他爸觉得应该送他去学校,而不是在家私塾。不幸,后来他二哥库尔特也自杀了。

他考学术型高中失败了,只能去Lintz去读一所技术型高中。巧了,希特勒也在那学校。他和希特勒生日只差6天,但希特勒留了一级,他跳了一级,所以他们俩差两年级。有人说希特勒肯定仇恨维特根斯坦因为他是犹太人,但没证据表明他们认识,尽管他们有一张合照。猜猜哪个是希特勒,哪个是小维?

他在Lintz毕业后,最想到维也纳跟随波尔兹曼(见下图)学习物理。但那年夏天,波尔兹曼自杀了。维特根斯坦小时对机械工程有兴趣,就决定到柏林学机械工程了。在柏林待了三个学期,他觉得是浪费时间。他爸对他说,要不你就去曼彻斯特吧。他就去了。路德维希小时就展现了很强的动手能力,他十岁时就用木头和金属线做了一台缝纫机,不是模型,是真的,真用它缝了件衣服。他平时也喜欢动手修理个机器什么的,这习惯保持到晚年。所以,波尔兹曼死后,他从物理改学机械是自愿的。

他一生的爱好之一就是到了一个地方就去博物馆参观机械部分,看老式机器是怎么工作的。没事还喜欢画机械图纸。这可以解释他在《逻辑哲学论》中,用picture来表示一种哲学观念。有人说,他在战场上看人家画武器图,受的启发。我觉得这事要早。他随身带个本子记自己的想法。

他在柏林时经常去听瓦格纳(见下图)的歌剧。他很欣赏瓦格纳,说“天才显露的地方,技术就不算啥了。” 不知道战前,犹太人怎么看瓦格纳。但战后有相当一段时间,瓦格纳是不受犹太人待见的。当然,维特根斯坦自身的犹太人身份也很模糊。

在曼彻斯特他遇见了数学家利特伍德。利是哈代的合作者,哈代几乎所有著作都是同利合作的,利向维推荐正在曼彻斯特做研究的物理学家卢瑟福。卢那时刚得到一笔奥地利科学院的资助做镭放射性研究,而钱其实来源于维特根斯坦家族。但维不感兴趣。有更深刻的东西等着他呢。在曼彻斯特,做飞机设计,那时怀特兄弟的飞机也不成熟。他专攻发动机,这免不了用到数学,结果他数学越钻越深,整到哲学和逻辑了。他看了两本书:弗雷格的《算术基础》,罗素的《数学原则》(Principles of Mathematics)(注意不是同怀特海合著的《数学原理》Principia Mathematica,从某种意义上说,《数学原则》是《数学原理》的热身)。他在一个夏天就跑到耶拿去找弗雷格(见下图)。弗雷格是分析哲学的鼻祖,过去很多原本归功与罗素的东西源头在弗雷格那儿。

弗雷格见到维特根斯坦后马上觉得小子有慧根,就说:你玩大了,我的东西有点过时了,你还是去找罗素吧。他马上改变暑假完回曼彻斯特的计划,直奔剑桥。后辈有人说弗雷格对维影响巨大,他自己列过十个他认为伟大的人,里面有波尔兹曼、赫兹、弗雷格、罗素、叔本华等。

1912年,维特根斯坦在剑桥,有一天他问罗素:如果我是个大傻逼,我就去当飞艇驾驶员;但如果不是,我想当哲学家。罗素对他说:你先写篇东西给我看下。维特根斯坦拿过纸就写,只写了一句,罗素就说:你丫别写了,做哲学家吧。有人说这段话是罗素编的,无论如何,罗素是真喜欢他。罗素发现维特根斯坦对过去的哲学文献知道的很少,让他做系统阅读。但维特根斯坦一读,马上就发现他过去崇拜的哲学家其实都很愚蠢且装逼,罗素对维的洞察力表示吃惊,最后对他说:你丫要是不想读,就算了,自个琢磨也行。

维特根斯坦曾经思考:学哲学有什么用,如果它能给你的一切就是使你能就深奥的逻辑问题谈论一些似是而非的道理,但却不能使你更好地解决日常生活的重要问题?后辈有人说维特的这种想法是要取消哲学。其实这问题每个学哲学的人都该问问自己,尤其是今天。

维特根斯坦曾告诉他的爱人平森特(图),罗素对他在哲学上的鼓励结束了他九年的孤独和自杀企图。但罗素一直就担心这小子哪天憋不住会要了自己的命,甚至预言他会在1914年2月之前自杀。大卫-休谟-平森特是罗素介绍给他的。平森特是休谟的后代,那时在剑桥读数学。他疯狂地爱上了平森特。感情闹同性恋,也得看出身啊。休谟的英国经验主义在维特根斯坦之后变成了逻辑经验主义,大概没太离谱。这有点像中国唱京剧或说相声的,和梅兰芳的后人比划一下子,就可称“梅派”,给侯宝林的后人磕个头就称“侯派”。我琢磨中国的“派”翻成英文,就得叫“主义”,梅派就是“Mei-ism”。维特根斯坦称平森特是“第一个也是唯一的朋友”。他俩一起去冰岛和挪威旅行。平森特在一战时身体不合格,服不了兵役,但他还是做了皇家的空军测试飞行员,1918年死于空难。平母写信给维告知死讯,那是同二哥库尔特自杀的消息同时来的,维肝肠痛断。《逻辑哲学论》是献给爱人平森特的。

| |

往事如烟--《扒1扒神经网络的神经大神们》

作者 陈怀临 | 2014-10-06 10:42 | 类型 Deep Learning, 机器学习 | Comments Off

|

作者:Nick Zhang 。

自图灵提出“机器与智能”,一直就有两派观点,一派认为实现人工智能必须用逻辑和符号系统,这一派看问题是自顶向下的;还有一派认为通过仿造大脑可以达到人工智能,这一派是自底向上的,他们认定如果能造一台机器,模拟大脑中的神经网络,这台机器就有智能了。前一派,我想用“想啥来啥”来形容;后一派就称之为“吃啥补啥”,估计他们的思想来源于中国古代的原始思维,套一句庸俗的哲学词,前者偏唯心,后者偏唯物。这两派一直是人工智能领域里两个阶级、两条路线的斗争,这斗争有时还你死我活。

1949年,神经心理学家Hebb出版《行为组织学》(Organization of Behavior),在该书中,Hebb提出了被后人称为“Hebb规则”的学习机制。这个规则认为如果两个细胞总是同时激活的话,它们之间就有某种关联,同时激活的概率越高,关联度也越高。换句话说,就是“吃啥补啥”。2000年诺贝尔医学奖得主肯德尔(Eric Kandel)的动物实验也证实了Hebb规则。后来的各种无监督机器学习算法或多或少都是Hebb规则的变种。

明斯基是人工智能的奠基人之一,是达特茅斯会议的组织者。明斯基在一次会议上和罗森布拉特大吵,他认为神经网络不能解决人工智能的问题。随后,明斯基和麻省理工学院的另一位教授佩普特合作,企图从理论上证明他们的观点。他们合作的成果就是那本影响巨大、“是也非也”的书:《感知机:计算几何学》(Perceptrons: An Introduction to Computational Geometry)。在书中,明斯基和佩普特证明单层神经网络不能解决XOR(异或)问题。异或是一个基本逻辑问题,如果这个问题都解决不了,那神经网络的计算能力实在有限。其实罗森布拉特也已猜到“感知机”可能存在限制,特别是在“符号处理”方面,并以他神经心理学家的经验指出,某些大脑受到伤害的人也不能处理符号。但“感知机”的缺陷被明斯基以一种敌意的方式呈现,当时对罗森布拉特是致命打击。所有原来的政府资助机构也逐渐停止对神经网络的研究。1971年,罗森布拉特四十三岁生日那天,在划船时淹死。很多人认为他是自杀。王国维沉湖时遗言“经此世变,义无再辱”,在罗森布拉特,我猜“辱”是明斯基的书,“世变”是随后“神经网络”学科的消沉。不同的是,王静安谓之“世变”是历史潮流,但神经网络学科十年后会逆袭。 表面是科学,但有证据表明明斯基和罗森布拉特以前就有瓜葛。他们是中学同学。布朗克斯(Bronx)科学高中大概是全世界最好的高中,毕业生里出过八个诺贝尔奖、六个普利策奖。远的不说,明斯基是1944年毕业生,乔姆斯基是1945年毕业生,而罗森布拉特是1946年毕业生。美国高中学制四年,明斯基和罗森布拉特至少有两年重叠,而且彼此认识,互相嫉妒。1956年的达特茅斯会议定义了“人工智能”这个词,会议的组织者包括明斯基、麦卡锡和香农等,参会者还有司马贺,纽威尔等。这个会议在定义“人工智能”领域时只是提到了神经网络。那时明斯基是神经网络的支持者。他1954年在普林斯顿的博士论文题目是“神经-模拟强化系统的理论,及其在大脑模型问题上的应用”(Theory of Neural-Analog Reinforcement Systems and its Application to the Brain-Model Problem),实际是一篇关于神经网络的论文。他晚年接受采访时开玩笑说,那篇三百多页的博士论文从来没正式发表过,大概只印了三本,他自己也记不清内容了。貌似他想极力开脱自己和神经网络学科的千丝万缕的关系。达特茅斯会议的主题并不是神经网络,而是后来被纽维尔和司马贺称为“物理符号系统”的东西,也就是说达特茅斯会议,“想啥来啥”派是主要基调。 罗森布拉特被比他大一岁的明斯基妒忌是自然的。工作上,明斯基所负责的麻省理工学院的人工智能实验室也在向国防部和海军申请经费。大多数的圈内科学家,对罗森布拉特突然被塑造的明星范儿很反感。明斯基早期也是“吃啥补啥”派出身,但此时已经改为“想啥来啥”派了。由于他和佩普特对感知机的批判,俩人后来被“吃啥补啥”派称为“魔鬼搭档”。其实明斯基认识佩普特结识还是通过麦卡洛克的介绍,历史真是纠结。被称“魔鬼”是因为《感知机》第一版有言:“罗森布拉特的论文大多没有科学价值。”这话跳步确实有点大,但罗森布拉特人缘不好,没有得到同行的支持。 比罗森布拉特小一岁的维德罗(Widrow)是斯坦福大学教授,在罗森布拉特刚提出“感知机”时,就提出了Adaline可适应性算法。Adaline和感知机很相似,也是机器学习的鼻祖模型之一。罗森布拉特享受盛誉时,维德罗也沾了光,但在罗森布拉特死后,他却并没有被非难。维德罗在几十年后回忆说,那是因为他后来主要在电机系(EE)做集成电路的工作,而不是在计算机系里从事派系繁杂的人工智能研究,圈子不同,老死不相往来。

在信息科学和神经科学的结合部的失败,并没有影响到神经生物学内部。哈佛神经生物学家胡贝尔(Hubel)和威瑟尔(Wiesel)对视网膜和视皮层(visual cortex)中神经细胞的信息处理模式做了深入研究,他们为此获得1981年的诺贝尔医学奖。随后,麻省理工学院英年早逝的大卫·马尔(Marr)为视觉信息处理建立数学模型,影响了后来连接主义的运动。威瑟尔后来离开哈佛去了洛克菲勒大学。1991年洛克菲勒大学时任校长大卫·巴尔的摩出了学术丑闻被迫辞职后,威瑟尔出任洛克菲勒校长,为把那所学校建成生物学的重镇做出贡献。 1974年,哈佛的一篇博士论文证明了在神经网络多加一层,并且利用“后向传播”(Back-propagation)学习方法,可以解决XOR问题。这篇论文的作者是沃波斯(Werbos),他后来得到了IEEE神经网络学会的先驱奖。沃波斯这篇文章刚发表时并没引起多少重视,那时正是神经网络研究的低谷,文章不合时宜。 神经网络在1980年代的复兴归功于物理学家霍普菲尔德(Hopfield)。1982年,那时在加州理工担任生物物理教授的霍普菲尔德,提出了一种新的神经网络,可以解决一大类模式识别问题,还可以给出一类组合优化问题的近似解。这种神经网络模型后被称为霍普菲尔德网络。1984年,霍普菲尔德用模拟集成电路实现了自己提出的模型。霍老也培养了一批后起之秀,包括现在在生物学重镇Salk研究所担任计算神经生物学实验室主任的Terry Sejnowski。霍老后转往普林斯顿担任分子生物学教授,现已退休。霍普菲尔德模型的提出振奋了神经网络领域。一帮早期神经网络研究的幸存者,在生物学家克里克(Crick,对,就是发明DNA双螺旋的那位诺贝尔奖得主)和认知科学大佬唐·诺曼(Don Norman)的鼓励下,以加州大学圣地亚哥分校为基地,开始了“连接主义”(Connectionism)运动,这个运动的领导者是两位心理学家鲁梅尔哈特(Rumelhart)和麦克利兰德(McLelland),外加一位计算机科学家辛顿(Geoffrey Hinton)。 | |

(3个打分, 平均:3.33 / 5)

(3个打分, 平均:3.33 / 5)